简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

第二中方法也更常见,对应于pytorch中clip_grad_norm_(parameters, max_norm, norm_type=2)。如果所有参数的gradient组成的向量的L2 norm 大于max norm,那么需要根据L2 norm/max_norm 进行缩放。第一种方法,比较直接,对应于pytorch中的nn.utils.clip_grad_value(parameters,

(从公众号转发过来发现图片不能引用,直接点上面链接吧)昨天的文章介绍了在学习Deep Learning过程中必须背熟的十几条知识点,主要让大家有个对深度学习的整体认识,有了对知识点的认识,然后可以针对不理解或不熟悉的point再单个的深入挖掘。今天想给大家分享一下DeepLearning常见的十大深度学习架构,这十个架构中,大家有见过或没见过的,见过的回顾一下,没见过的可以有个初步的认识,再有针对

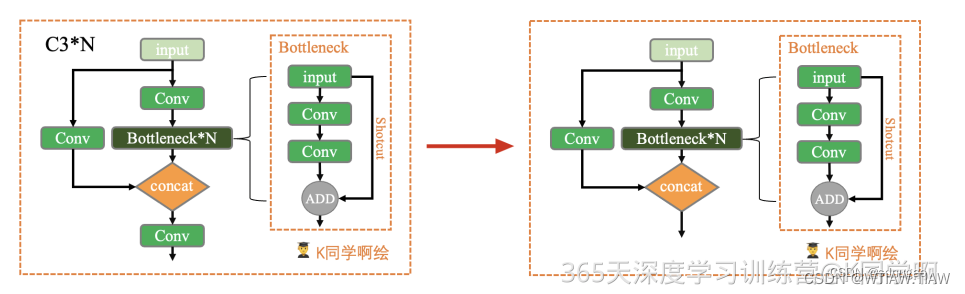

在深度神经网络中,通常将前面的卷积层设计为,后面的卷积层则负责。因此,后面的卷积层需要更加复杂、抽象的特征表达能力,才能有效地提取更好的特征。为了增强特征提取能力,通常可以使用更多的卷积核来学习特征。同时,还可以逐层增加卷积核的通道数,以增加模型的复杂度和表达能力。具体而言,每一层卷积层中的卷积核个数和通道数都可以根据实际任务需要进行相应的调整。需要注意的是,过深或过于复杂的网络结构可能会导致过拟

输入的卷积特征图的大小为(w,h),第一层空间金字塔采用4x4的刻度对特征图进行划分,其将输入的特征图分成了16个块,每块的大小为(w/4, h/4);YOLOV5中使用NMS算法用来移除一些网络模型预测时生成的多余检测框,该算法的核心 思想是指搜索局部得分最大值预测并移除与局部最大值预测框重叠度超过一定阈值的检测 框,需要注意的是,NMS算法对所有待检测目标类别分别执行。Focus模块是作者自己

计算量对应我们之前的时间复杂度,参数量对应于我们之前的空间复杂度,这么说就很明显了也就是计算量要看网络执行时间的长短,参数量要看占用显存的量其中最重要的衡量CNN 模型所需的计算力就是flops:FLOPS: 注意全大写,是floating point operations persecond的缩写,意指每秒浮点运算次数,理解为计算速度。是一个衡量硬件性能的指标。FLOPs: 注意s小写,是flo

Browse State-of-the-Art 其实是paperswithcode团队做的另外一个网站,paperswirhcode主要思路是查找最新的论文和代码,而Browse State-of-the-Art则是按照应用的不同领域来进行查找。Browse State-of-the-Art 其实是paperswithcode团队做的另外一个网站,paperswirhcode主要思路是查找最新的论

DeepMind神作Human-level control through deep reinforcement learning,其实也可以归为end-end,深度增强学习开山之作,值得学习:http://www.nature.com/nature/journal/v518/n7540/full/nature14236.html。并且,神经网络可以很好地学习到特征的描述,之前需要人工设计的特征算

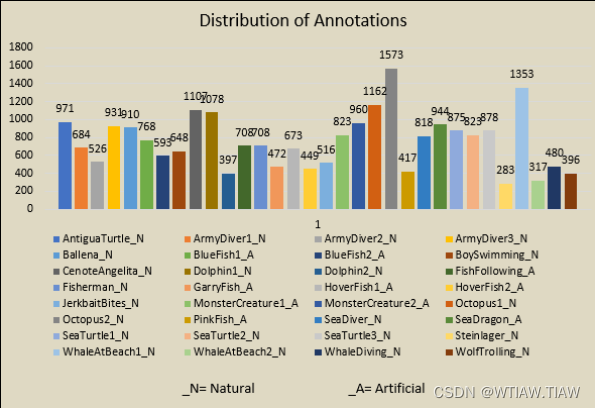

作者联系方式: landrykezebou@gmail.com, panettavisonsensinglab@gmail.com。MOTChallenge Underwater:该数据集包含了水下目标追踪的视频序列和相应的注释,视频序列来自于不同的场景和视角。The PETS 2009 dataset:该数据集包含了水下目标检测和追踪的视频序列,视频序列来自于一个水下实验室。The CoLin

思路:直接按题意模拟,但要重写一下Comparator.注意字符串的排序用comparaTo();其余没什么好说的。利用类模拟结构体。get√import java.awt.List;import java.util.*;import java.util.Scanner;class node{String s;int a,b,c,d,sum;node(Strin...

本节是一个使用PyTorch实现的简单文本分类实战案例。在这个例子中,我们将使用AG News数据集进行文本分类。Dataset)是一个广泛用于文本分类任务的数据集,尤其是在新闻领域。该数据集是由AG’s Corpus of NewsArticles收集整理而来,包含了四个主要的类别:世界、体育、商业和科技为了完成本节内容,需要安装好torchtext与portalocker库定义TextClas