简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这次实验,我们将对如下图片进行划痕检测,其实这个比较有难度,因为清晰度太差了。(1)读取图像为灰度图像,进行自适应直方图均衡化处理,增强图片对比度。(5)最后使用霍夫曼直线检测,检测划痕线段并绘制。(3)然后我们再进行一次直方图均衡操作增强图片。(2)然后进行三次图像去噪 - 高斯滤波。(4)然后使用canny进行边缘检测。有一点效果,但不多。

Baum-Welch算法Baum-Welch算法可以解决无监督学习的隐马尔可夫问题,也即是说,如果如果我们现在有一个训练集没有状态序列,只有观测序列,现在让我们根据观测序列求隐马尔可夫模型参数及:Z=(A,B,C).那么就可以用Baum-Welch算法来解决该问题。将状态序列看做隐变量I.那么我们要学习的模型可以表示为下式:提到隐变量,如果你看过我之前的博客应该知道怎么求解上面这个问题了吧,...

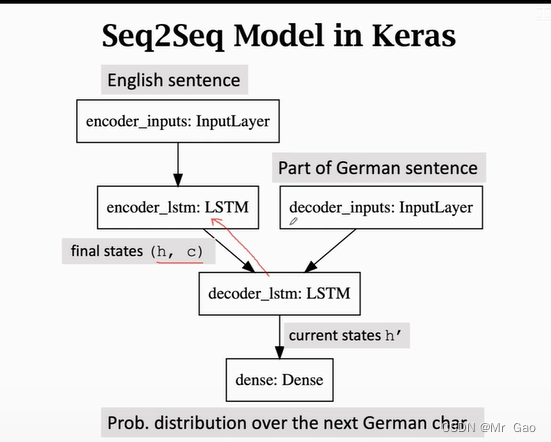

lstm模型最终会输出记忆信息c和最终的输出h,其实我认为,c就是对应RNN里的最终输出h,lstm的最终输出h则是对c进行了一次输出门处理,也就是进行了一次tanh操作和遗忘处理。再次基础上,将德语已经翻译好的句子的第一个字符也进行one-hot编码得到t,将(c,h)和t按照lstm模型流程,t作为x输入,(c,h)作为上一个单元得到的记忆信息和输出然后得到德语下一个预测字符,将下一个预测字符

概率论中 PDF,PMF,CDF的含义在概率论中,我们经常能碰到这样几个概念PDF,PMF,CDF,这里就简单介绍一下PDF:概率密度函数(probability density function), 在数学中,连续型随机变量的概率密度函数(在不至于混淆时可以简称为密度函数)是一个描述这个随机变量的输出值,在某个确定的取值点附近的可能性的函数。概率密度函数都是针对连续性随机变量的,对于连续性随机变

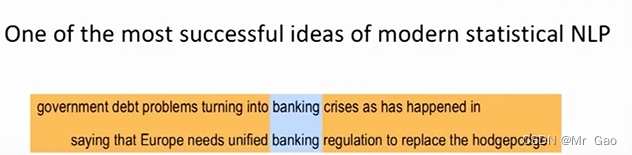

词袋模型其实是一种很简单的统计模型,这个统计模型说法是博主自己定义的,也可能真的统计模型中含有词袋模型这一类,为什么说它是统计模型?因为词袋模型他呢是基于统计的,比如现在我们有两组组词,现在我们希望对这组词建立词袋模型。然后这里要提到的是,词袋模型本质上就是统计一个词组单词的出现次数,在进行向量转化,词袋模型是比较简单的,它并不会考虑这些单词之间的内在联系,同时转化的过程中,原来单词之间的顺序也不

实现代码都在下面了,代码中参数做了简单注释。

下面这个代码大家可以学习学习,这个代码难度最大的在于反向传播推导, 博主推了很久,整个过程都是纯算法去实现的,除了几个激活函数,可以学习一下下面的代码。我下面这个代码还是很严谨的,从数据集生成,损失函数,网络结构、梯度求导,优化器等等组件都实现了。

数据规约数据规约指通过选择替代的、较小的数据来减少数据量,包括有参数方法和无参数方法两类。有参数方法是使用一个模型来评估数据,只需存放参数,而不需要存放实际数据,例如回归(线性回归和多回归)和对数线性模型。无参数方法就需要存放实际数据,例如直方图、聚类、抽样。(1)直方图直方图实用分箱来近似数据分布,是一种流行的数据规约形式。属性A的直方图将A的数据分布划分为不想交的子集或桶。通过这种方式...

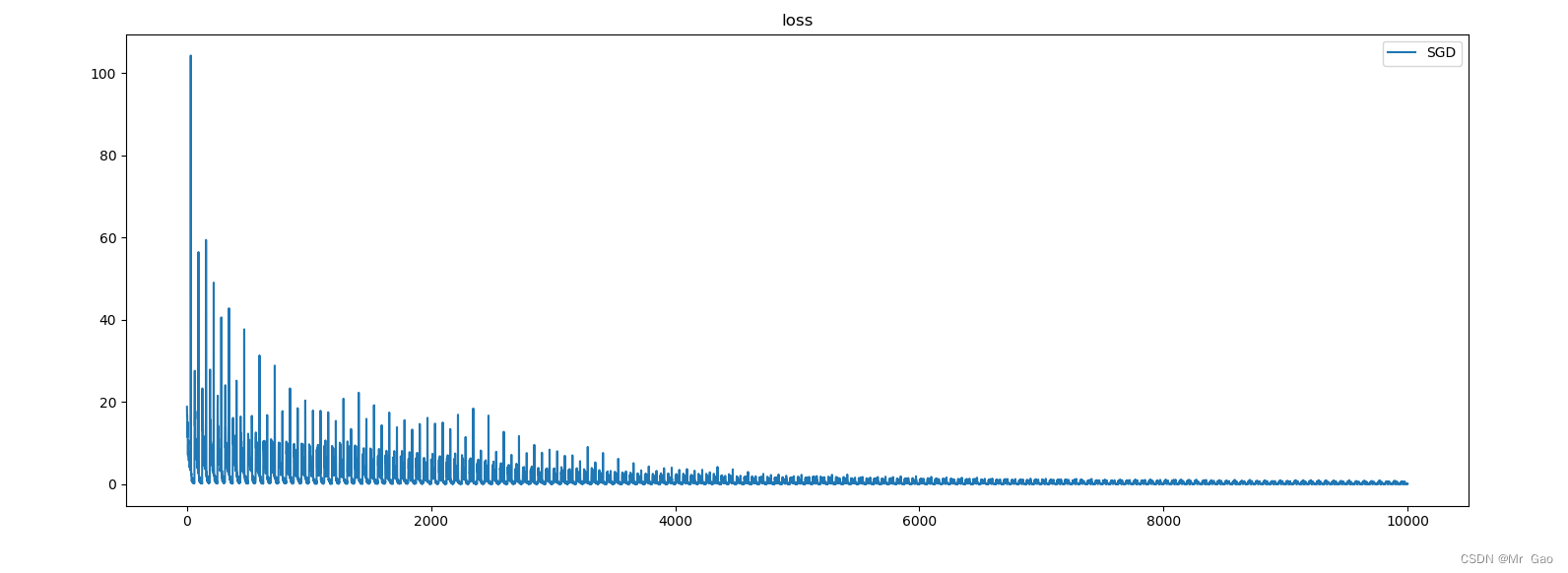

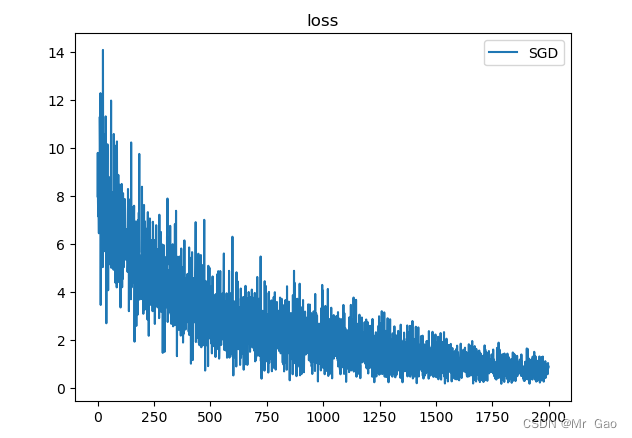

上一次的代码博主看了,有两个小问题其实,一个是,SGD优化的时候,那个梯度应该初始化为0,还一个是我并没有用到随机生成batch。博主修改了代码,并且加入了accuracy图像绘制的代码。可以看到这样看下来,效果就很不错了。

注意:上面的2m 个mxn 矩阵都是同一个矩阵,所以这里也是博主很疑惑的一点,想了很久也没想通,每个位置的背景词汇按理不应该一样啊,但是,他用的确实同一个矩阵,所以skip-gram模型是有一个很大的问题的,他其实在论文中标识除了上下文位置的区分度,也就是上下文词汇是有位置去别的,但是这个模型在真正处理的时候,把上下文的词汇忽略了位置因素,相当于看成了一个集合,所以2m 个mxn 矩阵都是同一个矩