简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

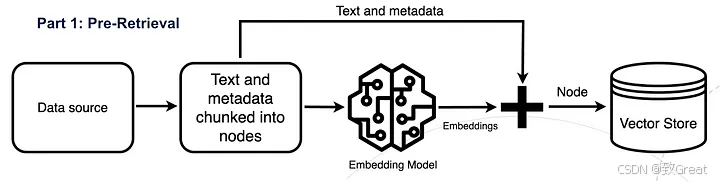

此过程涉及嵌入一组有限的句子以供检索,这些句子周围的附加上下文(称为“窗口上下文”)被单独存储并与它们链接。一旦确定了最相似的句子,就会在将这些句子发送到大型语言模型 (LLM) 进行生成之前重新整合此上下文,从而丰富整体上下文理解。

如果不这样做的话,各个请求间相互争夺gpu资源,最终将导致没有任何一个请求能完成推理任务。等到先来的请求做完了推理,vLLM调度器认为gpu上有足够的空间了,就能恢复那些被中断的请求的执行了。

在遇到复杂任务时,比如第一次搜索没有找到想要的内容,我们可能需要进行第二次、第三次搜索,甚至可能需要调用网络搜索来完成。在这种情况下,顺序执行的任务(DAG)显然无法满足需求。请求方和搜索方之间需要经历多次来回沟通,请求方可能会要求搜索方根据反馈调整搜索策略,这种多次的循环沟通才能逐步逼近最终答案。

束搜索是一种在序列生成任务中用于平衡搜索效率和准确性的算法,它通过同时保留多个候选序列,能够避免局部最优解问题。其束宽决定了搜索范围和计算复杂度,广泛应用于机器翻译、文本生成和语音识别等任务。

来源:华为云确定性运维专刊(第五期)

混合专家(Mixture of Experts,简称 MoE)模型,是一种利用多个不同的子模型(或“专家”)来提升大语言模型(LLM)质量的技术。专家(Experts): 模型中的每个专家都是一个独立的神经网络,专门处理输入数据的特定子集或特定任务。例如,在自然语言处理任务中,一个专家可能专注于处理与语言语法相关的内容,而另一个专家可能专注于语义理解。路由或者门控网络(Gating Network

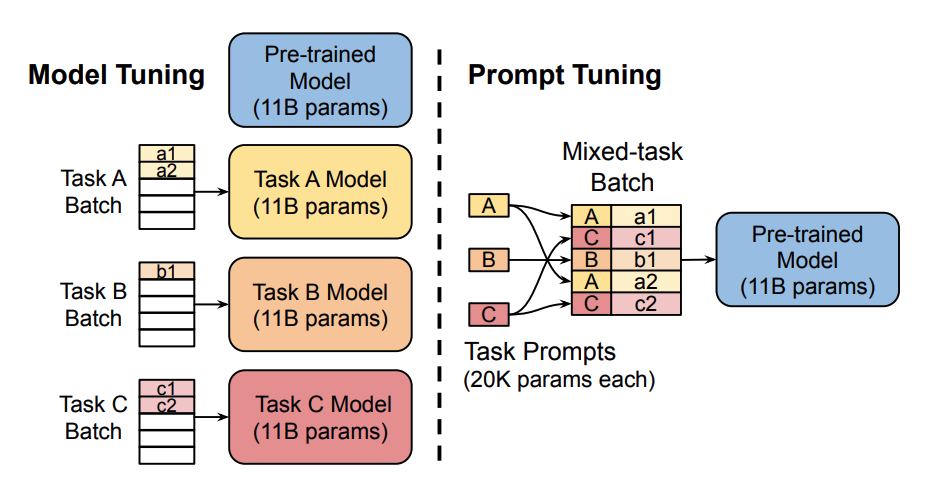

在本篇博客中,主要对 Prompt Tuning、Prefix-Tuning、P-Tuning、Adapter Tuning 这几类微调方法进行对比,总结每种方法的特点和优缺点。训练大型预训练语言模型非常耗时且计算密集。随着模型规模的增长,人们越来越关注更高效的训练方法,比如Prompting。Prompting通过包含一段描述任务或展示任务示例的文本提示,为特定的下游任务调整一个冻结的预训练模型

大模型训练框架 DeepSpeed 详解DeepSpeed 是一个由微软研究院开发的深度学习优化库,它主要针对大规模分布式训练进行了优化,尤其是在使用大量 GPU 进行训练时可以显著提高效率。DeepSpeed 旨在降低模型并行和数据并行的通信开销,同时提供了一系列工具来帮助研究人员和开发者更容易地训练大型模型。:这是一种减少内存使用的优化器,通过将模型状态分布在多个 GPU 上来减少内存占用。混

在讲解MLA之前,需要大家对几个基础的概念(KV Cache, Grouped-Query Attention (GQA), Multi-Query Attention (MQA),RoPE)有所了解,这些有助于理解MLA是怎么工作的,为什么需要这么做。

而重排序模型通过综合考虑更多的特征,如查询意图、词汇的多重语义、用户的历史行为和上下文信息等,重新计算上下文的相关性得分,使得真正相关的文档更容易被识别出来。例如,在传统的TF-IDF或BM25方法中,匹配主要依赖于词汇级别的相似度计算,而大型语言模型则可以理解句子和段落的上下文信息,从而更好地识别出真正相关的文档。总之,Cohere提供的在线重排序模型凭借其便捷的接入方式、卓越的性能以及广泛的适