简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

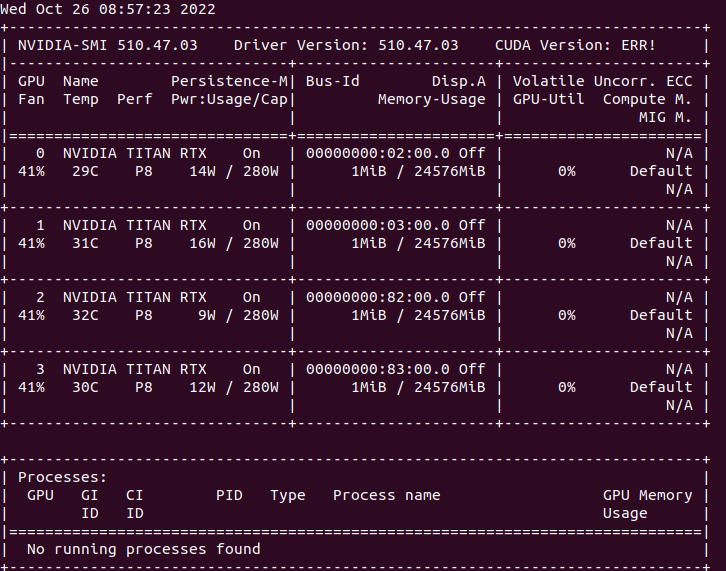

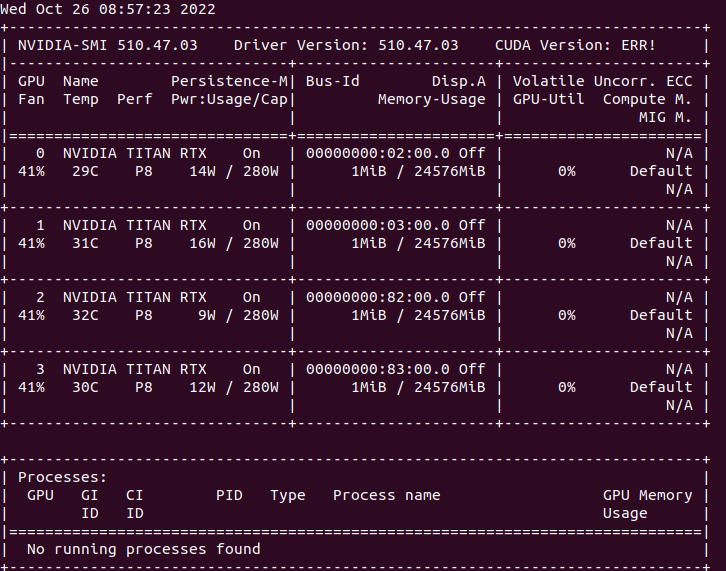

查找了相关的解决方案,大多数说是CUDA、cuDNN、显卡驱动版本不匹配问题,但是我的这套版本用了很长时间了,没有出现过这个问题,然后对问题进行了排查,怀疑是CUDA的动态连接库问题,查看了CUDA/lib目录下的动态链接库文件,果然多了两个文件,nvidia-smi查看显卡驱动后发现,CUDAversion:ERR!把这两个文件删除后,nvidia-smi后显示正常。

deepseek-r1:1.5b这个模型确实很轻量资源占用很少,应该也就占用1GB多点显存,但是也确实比较呆,很多问题都回答不上来,这里如果想要运行其他模型,可以参考ollama的技术文档https://ollama.readthedocs.io/quickstart/ 里面说明了其他模型运行的方式以及所需要的资源。下载完成后安装ollama,默认安装在c盘下面,这个通过默认安装方式无法更改模型就

查找torch与torchvision对应版本github链接:https://github.com/pytorch/vision#installation在线下载或者离线下载1、在线下载在pytorch官网选择相应的历史版本,使用conda或者pip安装,使用官网的镜像下载很慢,建议使用其他的镜像源,这里我使用的是阿里的镜像速度还不错。pip install torch==1.7.1 torch

在虚拟环境pytho3.6、cuda10.2中使用pip安装tensorflow-gpu==1.14运行报错,ImportError: libcublas.so.10.0: cannot open shared object file: No such file or directory,查找了相关资料说是tensorflow和cuda版本不匹配问题,但是我已经安装了cuda10.2重新安装比较麻

deepseek-r1:1.5b这个模型确实很轻量资源占用很少,应该也就占用1GB多点显存,但是也确实比较呆,很多问题都回答不上来,这里如果想要运行其他模型,可以参考ollama的技术文档https://ollama.readthedocs.io/quickstart/ 里面说明了其他模型运行的方式以及所需要的资源。下载完成后安装ollama,默认安装在c盘下面,这个通过默认安装方式无法更改模型就

目标检测中常见的loss函数

查找了相关的解决方案,大多数说是CUDA、cuDNN、显卡驱动版本不匹配问题,但是我的这套版本用了很长时间了,没有出现过这个问题,然后对问题进行了排查,怀疑是CUDA的动态连接库问题,查看了CUDA/lib目录下的动态链接库文件,果然多了两个文件,nvidia-smi查看显卡驱动后发现,CUDAversion:ERR!把这两个文件删除后,nvidia-smi后显示正常。

后始终报错,开始各种查资料,包括语法、tensorboard版本问题,都无法解决,最后发现了一个愚蠢的问题,tensorboard中的 logdir路径是相对路径,在pycharm中terminal的是工程路径,而我的代码是在工程下的一级目录里面,固然找不到生成的日志文件,CD到运行的代码上一级目录解决问题。在pycharm中训练模型,使用terminal开启。在pytorch中tensorboa

在ubuntu18.04下使用cv2.imshow显示图像时,显示的是黑色图像,不能正常显示,如下图所示。若以上方法不能解决,则可能使显示图像过大,窗口不能完全显示,可尝试。添加摧毁所有窗口后,重新运行代码显示正常。具体原因为显示窗口时没有添加。......

deepseek-r1:1.5b这个模型确实很轻量资源占用很少,应该也就占用1GB多点显存,但是也确实比较呆,很多问题都回答不上来,这里如果想要运行其他模型,可以参考ollama的技术文档https://ollama.readthedocs.io/quickstart/ 里面说明了其他模型运行的方式以及所需要的资源。下载完成后安装ollama,默认安装在c盘下面,这个通过默认安装方式无法更改模型就