简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

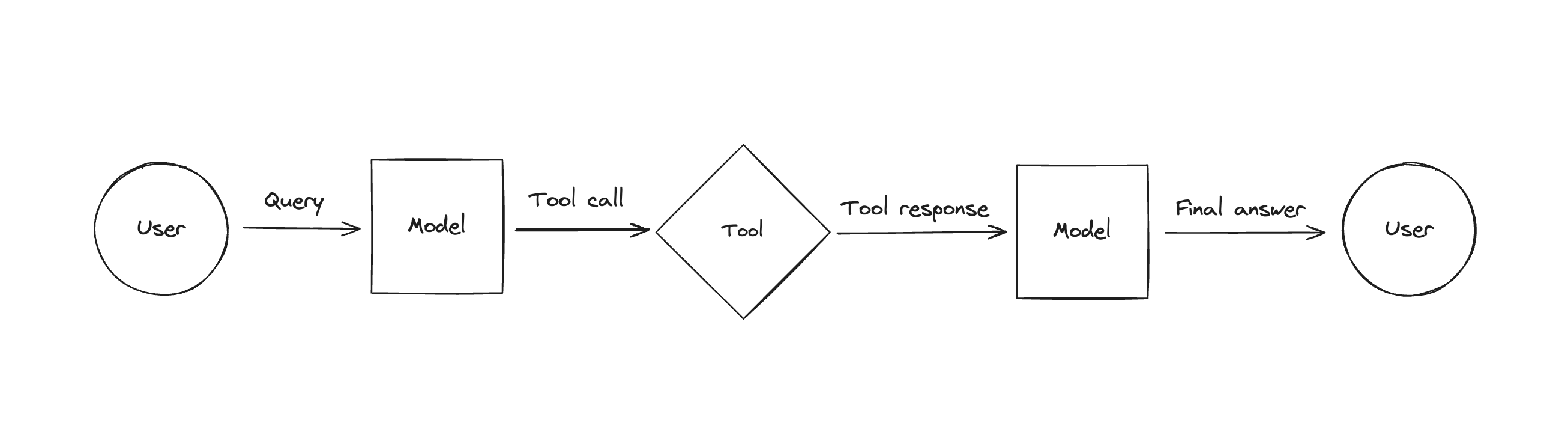

1. 这篇文章我们介绍了Agent这个热门的概念,以及它是如何依托LLM的function call来实现的2. 接着,再展示了借助LangChain的封装来简化这个开发过程,3. 并且还介绍了另外一种不依赖function call的Agent实现。

TensorFlow Serving简单来说就是一个适合在生产环境中对tensorflow深度学习模型进行部署,然后可以非常方便地通过restful形式的接口进行访问。除此之外,它拥有许多有点:支持配置文件的定期轮询更新(periodically poll for updated),无需重新启动;优秀的模型版本控制;支持并发;支持批处理;基于docker,部署简单。(这些优点我们在下面会逐一提到)

参考《Distilling the Knowledge in a Neural Network》Hinton等蒸馏的作用首先,什么是蒸馏,可以做什么?正常来说,越复杂的深度学习网络,例如大名鼎鼎的BERT,其拟合效果越好,但伴随着推理(预测)速度越慢。此时,模型蒸馏酒派上用场了,其目的就是为了在尽量减少模型精度的损失的前提下,大大的提升模型的推理速度。实现方法其实,模型蒸馏的思想很简单。第一步,训

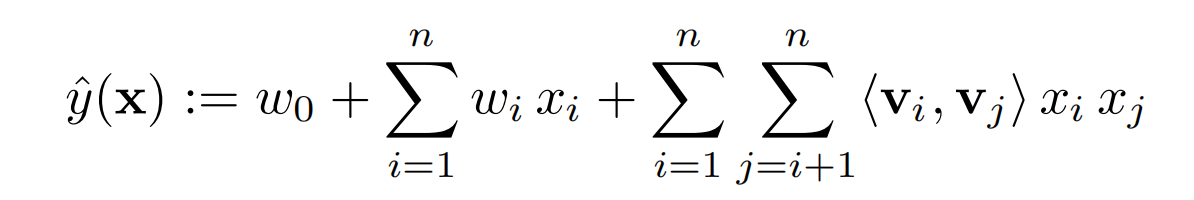

搜广推系统一般包括召回和排序,ctr预估一般应用于排序阶段。而像推荐系统,一个鲜明的特点就是数据极特别稀疏。下面,我们会持续学习那些针对稀疏数据的ctr任务而提出的模型,这篇文章则主要是关于FM系列

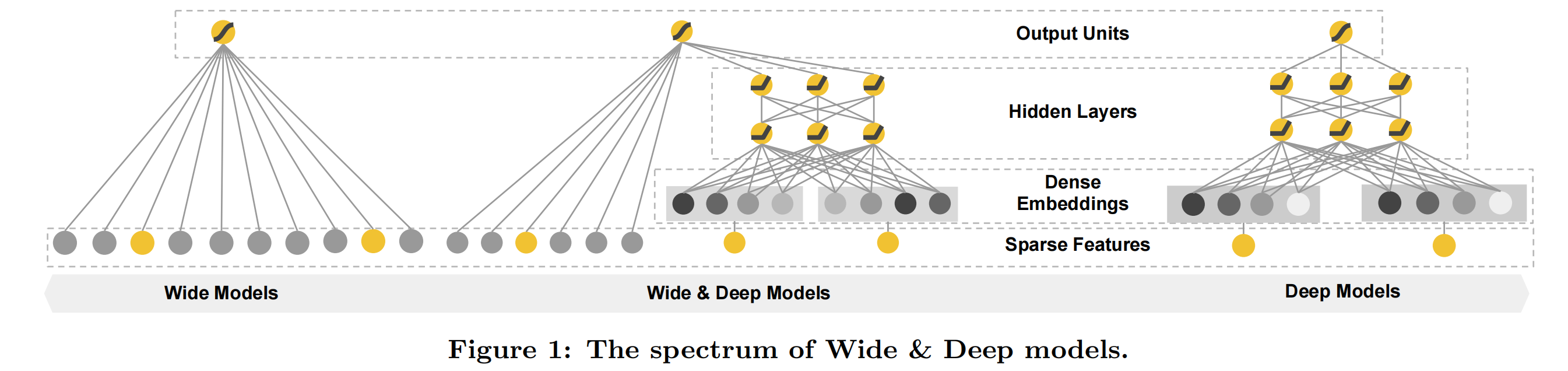

Wide&Deep,即同时加入低阶特征组合交互的线性模型-Wide、高阶特征交叉的深度模型(Deep),Wide部分模型提供模型的记忆能力,而Deep部分提供模型的泛化能力。这是Wide&Deep系列模型很重要的一个点。

参考《Distilling the Knowledge in a Neural Network》Hinton等蒸馏的作用首先,什么是蒸馏,可以做什么?正常来说,越复杂的深度学习网络,例如大名鼎鼎的BERT,其拟合效果越好,但伴随着推理(预测)速度越慢。此时,模型蒸馏酒派上用场了,其目的就是为了在尽量减少模型精度的损失的前提下,大大的提升模型的推理速度。实现方法其实,模型蒸馏的思想很简单。第一步,训

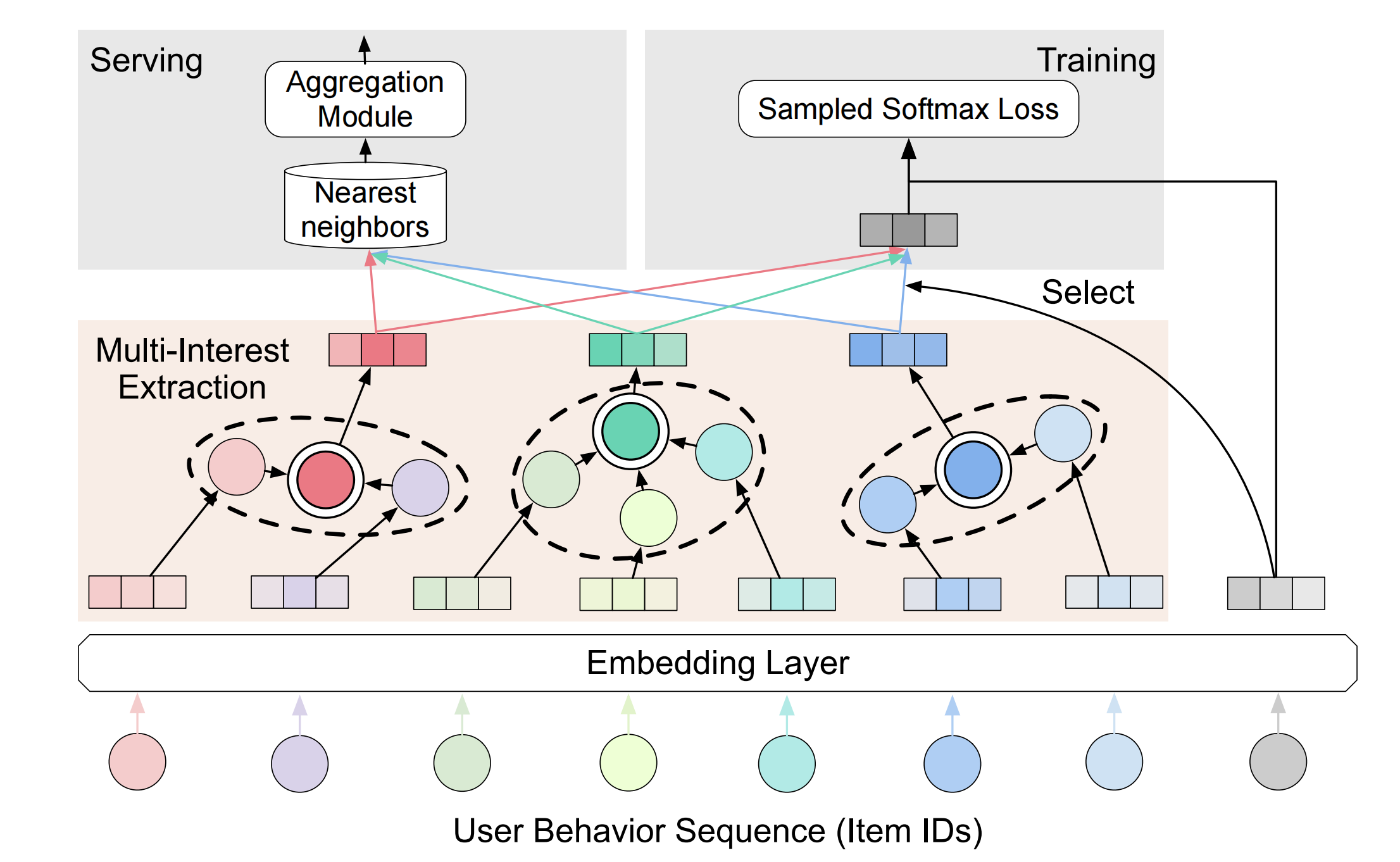

1. 论文指出了推荐召回模型中单个用户兴趣向量的弊端,提出一种可以提取多个用户兴趣向量的模型ComiRec,包括两种多兴趣提取模块:**Dynamic Routing**和**Self-Attentive Method**,对应的模型分别为ComiRec-DR和ComiRec-SA;2. 提出一种新的对用户多个兴趣向量召回结果的聚合方法(Aggregation Module),指出推荐系统可控性的

参考《Distilling the Knowledge in a Neural Network》Hinton等蒸馏的作用首先,什么是蒸馏,可以做什么?正常来说,越复杂的深度学习网络,例如大名鼎鼎的BERT,其拟合效果越好,但伴随着推理(预测)速度越慢。此时,模型蒸馏酒派上用场了,其目的就是为了在尽量减少模型精度的损失的前提下,大大的提升模型的推理速度。实现方法其实,模型蒸馏的思想很简单。第一步,训

原理batch_normalization一般是用在进入网络之前,它的作用是可以将每层网络的输入的数据分布变成正态分布,有利于网络的稳定性,加快收敛。具体的公式如下:γ(x−μ)σ2+ϵ+β\frac{\gamma(x-\mu)}{\sqrt{\sigma^2+\epsilon}}+\betaσ2+ϵγ(x−μ)+β其中γ\gammaγ和β\betaβ是决定最终的正态分布,分别影响了方差和均值

TensorFlow Serving简单来说就是一个适合在生产环境中对tensorflow深度学习模型进行部署,然后可以非常方便地通过restful形式的接口进行访问。除此之外,它拥有许多有点:支持配置文件的定期轮询更新(periodically poll for updated),无需重新启动;优秀的模型版本控制;支持并发;支持批处理;基于docker,部署简单。(这些优点我们在下面会逐一提到)