简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

SOTA也就是state-of-the-art,翻译为体现最高水平的。若某篇论文能够称为SOTA,就表明其提出的算法(模型)的性能在当前是第一名。参考链接:https://blog.csdn.net/haha0825/article/details/103349130/

SOTA也就是state-of-the-art,翻译为体现最高水平的。若某篇论文能够称为SOTA,就表明其提出的算法(模型)的性能在当前是第一名。参考链接:https://blog.csdn.net/haha0825/article/details/103349130/

一、保证环境干净,没有残余的nvidia驱动卸载nvidia驱动2.对于通过PPA以及Ubuntu自带的软件商店卸载指令如下sudo apt-get remove --purge nvidia*sudo apt autoremove2.对于通过官网.run文件,卸载指令如下sudo nvidia-uninstall二、安装前的准备1.禁用nouveau#禁用Ubuntu自带的nouveau驱动,首

SOTA也就是state-of-the-art,翻译为体现最高水平的。若某篇论文能够称为SOTA,就表明其提出的算法(模型)的性能在当前是第一名。参考链接:https://blog.csdn.net/haha0825/article/details/103349130/

Pyramid pooling 方法出自 2017CVPR,原文地址https://arxiv.org/pdf/1612.01105.pdf该文的一大贡献就是Pyramid pooling module(简称PPM)1. PPM有什么用一般可以粗略地认为感受野就是使用上下文信息的大小。在很多网络中,我们都很重视全局信息的获取。在FCN中,就是没有充分的场景的上下文信息,导致在一些不同尺度的物体分割

pytorch保存模型非常简单,主要有两种方法:只保存参数;(官方推荐)保存整个模型 (结构+参数)。由于保存整个模型将耗费大量的存储,故官方推荐只保存参数,然后在建好模型的基础上加载。本文介绍两种方法,但只就第一种方法进行举例详解。一、只保存参数1.保存一般地,采用一条语句即可保存参数:torch.save(model.state_dict(), path)其中model指定义的模型实例变量,如

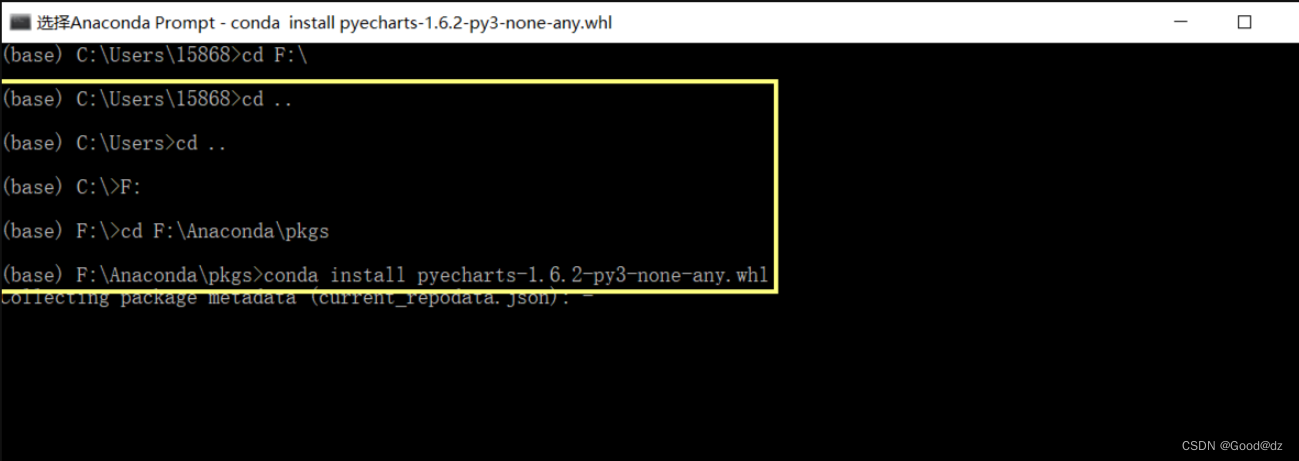

Anaconda Prompt的切换路径

Acc为准确率, F1为精确率. 两者很像,但是并不同,简单来说两者的目的对象并不相同。1.精确度2.准确率accuracy =(TP+TN)/(TP+FN+FP+TN)参考链接:http://www.bubuko.com/infodetail-2343224.html

瓶颈结构指的是通道数的变化,即原通道数减少再增大,用瓶颈来形容这一句结构较为抽象。在resnet中的应用,从下面的右图可知道输入的维度是256,输出的维度也是256,中间维度是64,即数据的通道数先经过减少,后再增加到原来的大小,这就是Bottleneck瓶颈型结构。参考链接:https://blog.csdn.net/DanTaWu/article/details/111468257?utm_m