简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

而且无需进行额外的训练。但是,如果你想为你的应用定制模型,可能需要在你的数据集上对模型进行微调,以获得比直接使用或训练更小型模型更高质量的结果。本文将介绍如何使用Hugging Face的。

大模型参考当前提问和相关知识,生成相应的答案。百度大模型内容安全解决方案采用了检索增强安全大模型作为核心模块,融合了海量的高质量知识库数据,并经过安全对齐优化,能够精准识别 AIGC 生成内容中的各类违规风险,有的放矢地进行过滤和改写。而在大模型处理敏感问题上,由于敏感问题具备一定的推理复杂性、高时效性,因此使用常规的向量数据库存储知识、检索召回注入 prompt,会面临高维护成本的基础上,并不能

了解完嵌入模型、向量数据库相关知识后,在此基础上可以实现一个RAG本地问答系统。

是由 Anthropic 推出的开源协议,旨在为大型语言模型(LLM)提供安全、可解释、可扩展的外部数据与工具集成方案。

音频分类任务是指将音频信号按照其内容的类别归属进行划分。例如,区分一段音频是音乐、语音、环境声音(如鸟鸣、雨声、机器运转声)还是动物叫声等。其目的是通过自动分类的方式,高效地对大量音频数据进行组织、检索和理解。在现在音频分类的应用场景,比较多的是在音频标注、音频推荐这一块。同时,这也是一个非常好的入门音频模型训练的任务。在本文中,我们会基于PyTorch框架,使用 ResNet系列模型在 GTZA

检索增强生成(RAG)将信息检索与生成模型相结合,使其成为问答、摘要和其他自然语言处理(NLP)任务等应用程序的强大技术。为了实现RAG,当今使用的两个最流行的框架是LangChain和LlamaIndex。这两个框架都旨在处理文档摄取、拆分、索引和链接在一起的步骤,以实现无缝的RAG工作流程。但哪一个适合您的项目呢?

如今大语言模型(LLM)的风头一时无两,它们能写诗、能聊天、能编程,简直无所不能!但你有没有发现,有时候它们也挺“傻白甜”的?比如问它今天的天气,它可能给你一个“根据我的知识库…”的过时答案;让它帮你整理本地文件,它只能表示爱莫能助。这是因为 LLM 本身像一个博学但与世隔绝的大脑。,以及一个新晋的潜力股——。今天,我们就用大白话+生动比喻,带你一次搞懂这四大金刚,看看它们是如何协同作战,让 AI

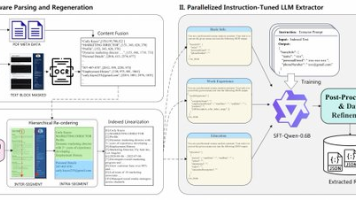

阿里团队最新开源的SmartResume智能简历解析系统,结合Qwen3-0.6B与YOLOv10模型,实现PDF简历十秒内快速解析。本文将带你零代码部署这套多模态AI系统,学习如何将大模型能力落地应用。通过本地部署Qwen3-VL和Deepseek OCR,开发者可轻松构建自己的文档处理应用,无需高昂成本即可实现简历信息的智能提取与结构化处理。目前的AI科技圈一直在致力于将AI模型能力落地应用,

摘要:本文剖析企业级RAG系统构建的三大核心环节——文档预处理、召回与生成增强,针对复杂文档处理、问题优化等难点提供实用解决方案。通过统一文档格式、多维度问题优化、上下文压缩等技巧,提升系统效率与准确性。文章强调业务场景适配的重要性,并分享文档转换、标签提取等实战经验,帮助开发者构建高质量RAG系统。最后指出AI时代率先掌握技术者的竞争优势,呼应大模型学习的重要性。全文兼顾技术深度与实用价值,为R

本书从知识体系、能力模型、沟通技巧等方面帮助大家系统地梳理了人工智能产品经理所必备的基本素质和技能,旨在帮助产品经理找到转型升级的最佳学习路线,以成为合格的人工智能产品经理。随着人工智能热潮的兴起,企业对人工智能领域产品经理的人才需求也开始井喷,人工智能产品经理成为顺应时代潮流的重要人力资源。实际上,人工智能确实给现有的产品和服务带来了全方位的升级,这也给产品经理从业人员提出了更高的要求,是关注人