简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

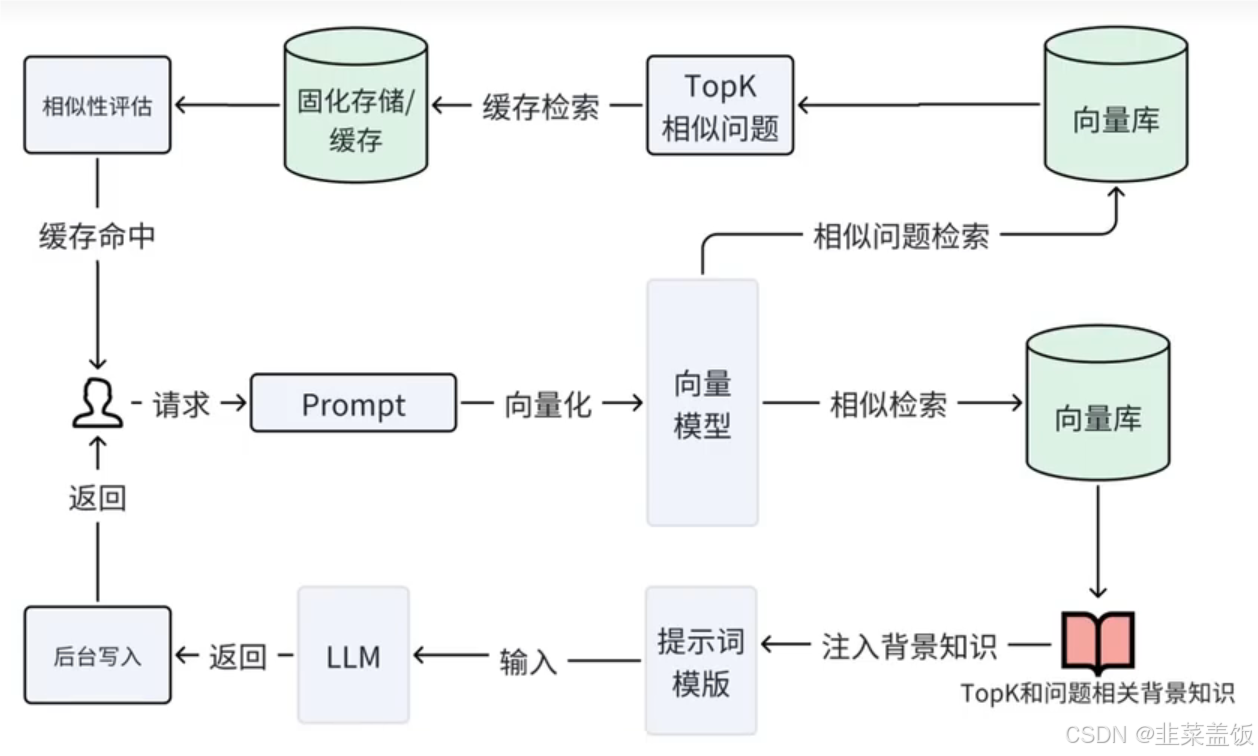

是一种结合了检索和生成的自然语言处理(NLP)技术。它通过将生成模型与外部知识库(如文本数据集、数据库等)进行检索结合,来增强生成模型的能力,提供更准确、更相关的答案。具体来说,RAG检索(Retrieval):模型首先从一个大的知识库中检索出与当前问题相关的文档或片段。这个步骤帮助模型找到具体信息,而不是完全依赖预训练的参数。生成(Generation):在检索到相关信息后,生成模型会基于这些信

⼤模型通常包含数亿甚⾄数百亿个参数,对其进⾏微调需要⼤量的计算资源和存储空间。在微调过程中,直接修改预训练模型的所有参数可能会破坏模型的原始性能。存储和部署微调后的⼤模型需要⼤量存储空间,尤其是当需要在多个应⽤场景中部署不同微调版本时。许多微调⽅法会增加推理阶段的计算延迟,影响模型的实时性应⽤。LoRA可以有效的解决以上问题LoRA存储与计算效率:通过低秩适应(LoRA),可以显著减少所需存储的参

运行以下命令时:出现错误提示:原因分析文件里出现了 非法字段 。Docker Compose 标准语法并不支持 。只有官方标准字段(如 、、 等)可以使用。错误示例这段配置是错误的,需要移除!编辑 然后启动时用指定多个文件:这样 Docker Compose 会自动合并这两个文件:如果你只想复用某个服务定义,可以使用 :要求:出现的警告信息:含义:

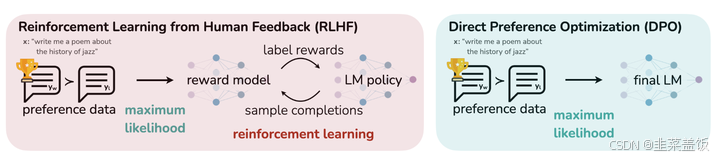

中文含义是:基于人类反馈的强化学习,用奖励模型来训练SFT模型;生成模型使用奖励或惩罚来更新其策略,以便生成更高质量、更符合人类偏好的文本。为什么需要RLHFSFT不够吗?数据层面SFT的目的是预测值与标签token级别完全一致,模型效果依赖于标注数据的质量,而且标注成本相对较高。SFT只有正反馈,没有负反馈机制,模型只知道下一个token是什么是正确的,而不知道什么是错误的。RLHF。

RLHF中的PPO流程复杂: 需要构建一个反映人类偏好的奖励模型而DPO本身是一种不需要强化学习的算法,简化了整个RLHF流程,训练起来会更简单。DPO 省略了两个模块,直接优化目标模型(Actor)的参数,使其生成更符合人类偏好的输出。简而言之,DPO不依赖强化学习中的“奖励”机制和“批评”机制,而是通过人类反馈直接指导优化过程。

我们本地从下载模型文件,因为某些原因,无法下载,会出现下方的错误1.Datasets使用时的数据下载问题。2.Transformer使用报错。

中文含义是:基于人类反馈的强化学习,用奖励模型来训练SFT模型;生成模型使用奖励或惩罚来更新其策略,以便生成更高质量、更符合人类偏好的文本。为什么需要RLHFSFT不够吗?数据层面SFT的目的是预测值与标签token级别完全一致,模型效果依赖于标注数据的质量,而且标注成本相对较高。SFT只有正反馈,没有负反馈机制,模型只知道下一个token是什么是正确的,而不知道什么是错误的。RLHF。

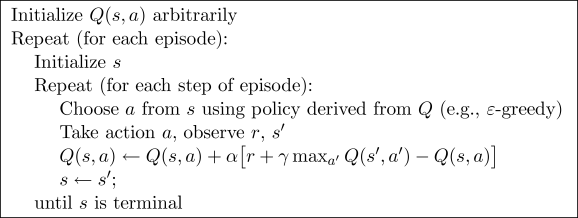

Q learning算法是一种的强化学习算法,Q是quality的缩写,Q函数 Q(state,action)表示在状态state下执行动作action的quality, 也就是能获得的Q value是多少。算法的目标是最大化Q值,通过在状态state下所有可能的动作中选择最好的动作来达到最大化期望reward。Q learning算法使用Q table来记录不同状态下不同动作的预估Q值。

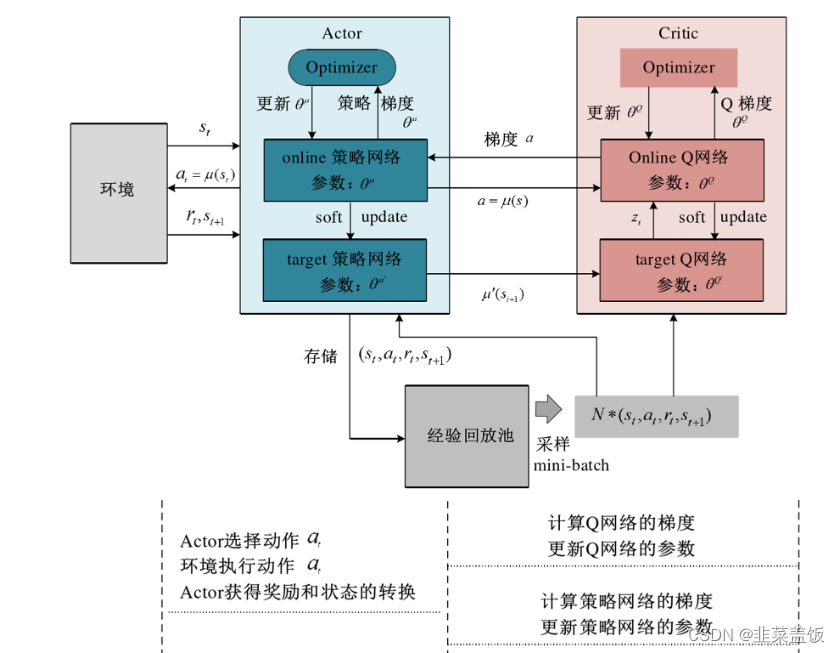

算法是DeepMind团队提出的一种专门用于解决连续控制问题的在线式(on-line)深度强化学习算法,它其实本质上借鉴了算法里面的一些思想。本文将会介绍其基本原理,并实现DDPG算法来训练游戏的例子。

前端请求后端数据时,会用到axios,但是如果不将axios封装好,会导致代码冗余求头能统一处理便于接口的统一管理解决回调地狱配置拦截器,给不同的实例配置不同的拦截器,支持以对象形式接受多个拦截器配置因此,在这里记录一下axios的封装过程。