简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

优秀的数据可视化图表只是罗列、总结数据吗?当然不是!数据可视化其真正的价值是设计出可以被读者轻松理解的数据展示,因此在设计过程中,每一个选择,最终都应落脚于读者的体验,而非图表制作者个人。这里给大家总结了数据可视化的制作的30个小技巧,通过列举一些容易被忽略的常见错误,最终能够快速提升和巩固你的可视化制作水平。一、你不得不注意的图表制作小技巧1.条形图的基线必须从零开始条形图的原理就是通过比较条块

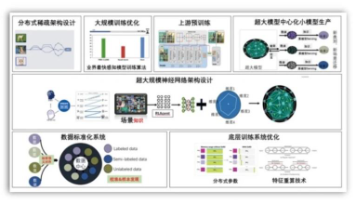

【摘要】本文系统介绍大模型入门学习路线,分为6个核心模块:1)深度学习基础(Transformer架构、优化器等);2)NLP基础知识(分词器、BERT模型等);3)大模型核心技术(训练框架、RLHF流程等);4)推理优化(KVCache、推理成本);5)应用开发(LangChain统一调用);6)前沿动态(顶会论文追踪)。针对当前大模型岗位高薪但技术不成熟的特点,提供从理论到实践的完整学习路径,

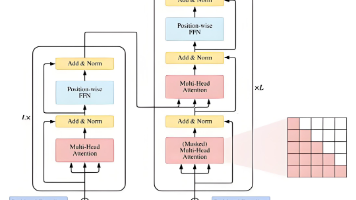

本文深入解析了大模型Transformer架构中的Prefill阶段关键流程。Prefill阶段通过四个步骤处理输入提示词:1)分词将文本转为token序列;2)Embedding层将token映射为向量;3)加入位置编码保留位置信息;4)通过Transformer层计算注意力权重。重点分析了Self-Attention机制的计算过程,包括QKV矩阵运算和注意力权重的softmax计算。文章特别指

主要瞄准现代战场上的“数据洪流”难题,旨在将陆、海、空、天等不同领域成千上万的传感器和武器平台连接起来,通过人工智能技术融合数据,为作战人员生成一张统一的、实时的共用作战图,从而极大缩短从发现目标到实施打击的决策时间,支撑更快的决策。ROUGE(Recall-Oriented Understudy for Gisting Evaluation)是一种用于评估自动文本摘要和机器翻译质量的指标,通过比

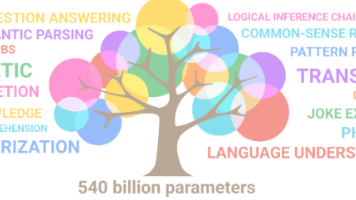

《从指令到智能:大型语言模型的革命与挑战》 本文系统介绍了大型语言模型(LLM)的技术原理、发展历程及现实挑战。与传统编程的指令式逻辑不同,LLM通过海量数据学习语言模式,具备灵活性和自适应能力。其核心技术Transformer架构(2017年提出)通过自注意力机制实现突破,推动模型参数从百万级跃升至万亿级(如GPT-4)。 LLM工作流程分为分词、嵌入和Transformer预测三阶段,依赖向量

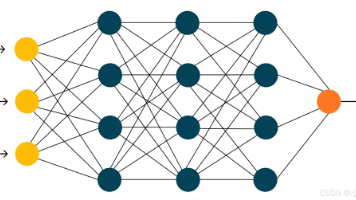

模型微调,顾名思义,就是对模型微微做一些调整。为什么要做微调呢?如果可以的话,每个公司都想拥有一个属于自己的大模型。但是,现实比较残酷,训练一个大模型需要花太多的钱。按照一些大公司的说法,一个千亿参数的大模型,训练一次的成本大约需要几百万美元。这显然就超过一个普通公司承受的范围。虽然我们无法训练一个属于自己的大模型,但一个好消息是,我们可以做模型微调。大模型是构建于神经网络基础之上的,神经网络可以

本文介绍了构建本地私有语言模型的实用指南。文章首先对比了闭源与开源语言模型的优缺点,指出开源模型在透明度、可定制性方面的优势。针对本地部署,重点探讨了小型语言模型(SLM)的应用场景,通过任务分解和代理协作提高效率,同时分析了有限上下文窗口的挑战。文中详细解析了检索增强生成(RAG)技术的四个优化阶段,并比较了RAG、微调与基础模型三种方法的适用场景。最后提供了使用LM Studio搭建本地模型的

本文系统介绍了大模型及其相关概念。大模型指参数规模庞大的人工智能模型,如GPT-3(1750亿参数)和GPT-4(1.8万亿参数)。文章涵盖了大模型的特点(如涌现能力、多任务学习)、分类和应用领域(自然语言处理、计算机视觉等)。同时阐述了大模型与人工智能的关系,以及基于大模型的智能体(AI Agent)和AIGC(人工智能生成内容)技术。最后提供了大模型学习资料获取方式,包括入门指南、实战案例和行

本文分享了如何通过优化Prompt设计大幅提升AI工具工作效率的经验。作者从最初认为AI工具"不够聪明",到掌握Prompt设计技巧后工作效率提升5-10倍,总结了几个核心框架:RTF框架(角色-任务-格式)适合基础场景;COSTAR框架(背景-目标-风格-语气-受众-回应)处理复杂任务;思维链技术让AI展示推理过程;以及通过Few-shot Learning提供示例。文章还提

1. 准备工作同样地,本节还是主要侧重于完成利用深度学习模型来识别验证码缺口的过程,所以不会侧重于讲解深度学习模型的算法,另外由于整个模型实现较为复杂,本节也不会从零开始编写代码,而是倾向于把代码提前下载下来进行实操练习。所以在最后,请提前代码下载下来,仓库地址为:https://github.com/Python3WebSpider/DeepLearningSlideCaptcha2,利用Git