简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

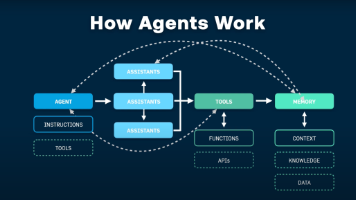

企业Agent是基于大模型的自主决策数字员工,具备感知-思考-决策-执行能力,解决企业数字化转型"最后一公里"难题。通过流程自动化升维、重构人机协作、赋予企业实时响应能力,实现降本增效。其运行依赖大模型推理、算力基础设施、标准化协议和安全四大支柱。已在金融、制造等多行业落地,未来将向多智能协同和行业深度融合方向发展,成为企业数字化基础设施。

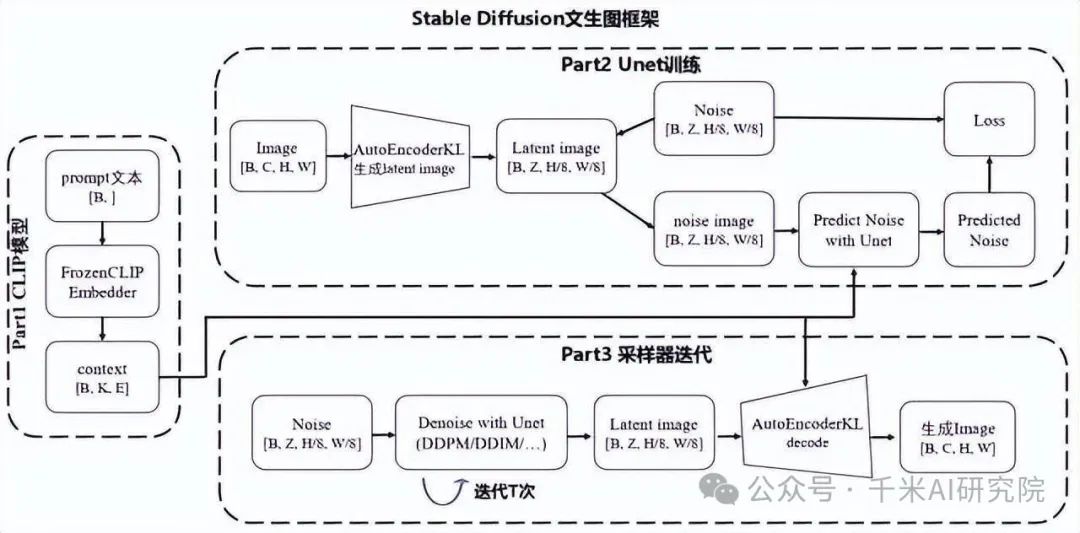

Stable Diffusion(简称SD)StableDiffusion是2022年发布的。

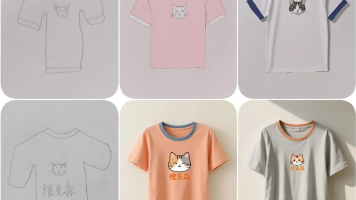

ComfyUI作为专业的AI设计工具,其核心价值在于实现精准图像控制与高效批量生产,特别适合电商产品风格迁移、工业设计效果图制作、印花图案转换等商业场景。通过先进的风格转绘与图案二创功能,它能有效提升设计效率,满足从产品原型到视觉延展的全流程需求,成为现代商业设计领域不可或缺的智能解决方案。

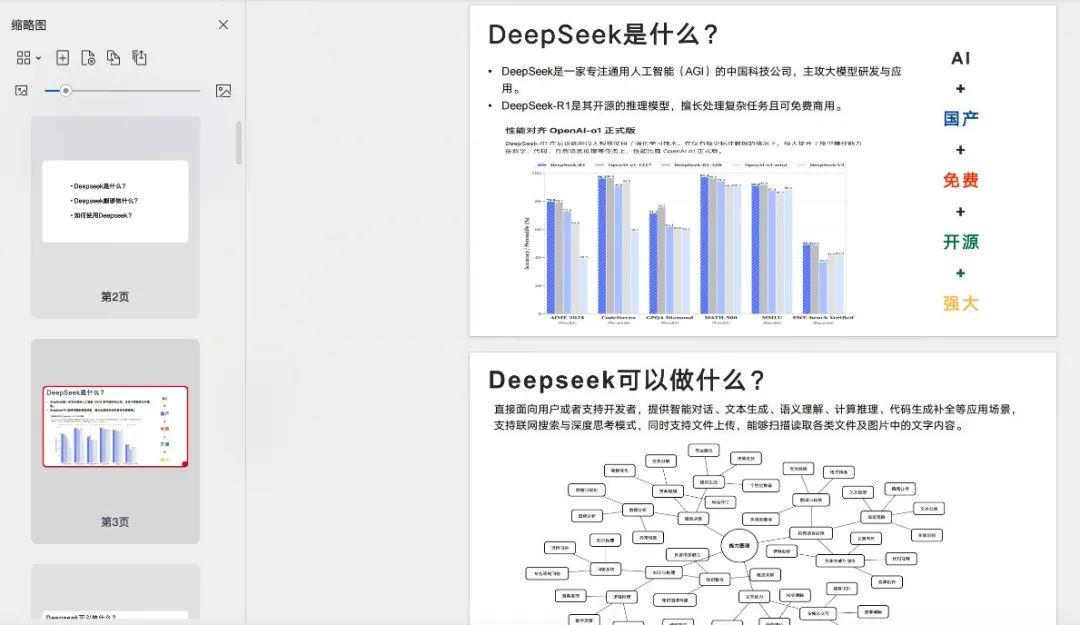

现在DeepSeek可谓是刷爆全网不少小伙伴都表示要体验一下!这几天更是有清华大学团队发布超详细DeepSeek使用手册菌菌已经第一时间给大家整理收集了!

大模型就像是一个魔术,我们在感叹大模型神奇能力的时候,每个观看魔术的人都很好奇,也都想看到魔术揭秘,那么今天,我就通过一个通俗易懂的大白话来试着讲一讲stable diffusion大模型的原理。

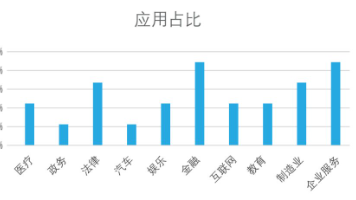

企业采用通用大语言模型面临"试点到生产"鸿沟,主要因三大缺陷:信任赤字、知识鸿沟和经济负担。解决方案包括RAG(解决知识与信任问题)和微调(提升专业行为),而垂直AI的兴起标志着从通用模型向专用系统的转变。企业AI正经历从"以模型为中心"到"以知识为中心"的范式转变,未来竞争优势将取决于企业专有知识的质量、规模和治理水平,而非使用的通用模型。

文章解析企业AI项目落地难的根本原因,提出MCP、RAG和AI Agent三大核心技术解决方案,详细阐述从效率工具到业务创新的三个应用层次,通过实战案例展示技术组合应用的协同效应,为企业AI转型提供从技术选型到实施的完整路线图。

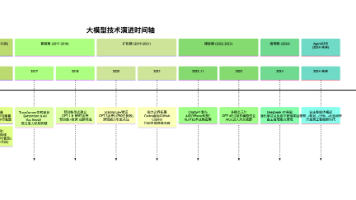

文章详细阐述了人工智能发展的六个关键阶段:从暗流期的技术积累,到Transformer架构的革命性突破,再到规模效应显现的扩张期,ChatGPT引爆的爆发期,DeepSeek R1开启的推理期,以及当前Agent时代的自主智能进化。核心逻辑是算法、算力和数据三股力量叠加突破临界点,使AI能力从语言理解逐步发展到可靠推理,再到具备自主行动与自我进化的能力,正迈向真正的自主智能生产力时代。

LangChain 是一个专门为大型语言模型(LLM)应用开发而设计的技术框架,它极大地简化了基于LLM和聊天模型的端到端应用程序构建流程。

本文解析了AI Agent在企业级Helm Chart生成项目中的架构演进,从"全自主决策"到"结构化工作流"再到"多Agent协作"。通过结构化约束、工程解耦、外部反馈和LangGraph编排等关键技术,解决了AI不确定性问题。核心观点是:AI Agent落地不是替代人,而是用AI提效、用工程控风险,从最小可行任务开始迭代,而非追求"全能Agent"。