简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在每次互动后,你会更新之前状态下所选择了的行动的Q值,使用一个称为贝尔曼方程的公式。这个公式会考虑之前选择了的行动后的奖励和当前状态的Q值和之前状态的Q值,以更新当前状态下的Q值。这个公式可以简单解释为:当前状态下选择某个行动的Q值等于当前即时奖励加上折扣后的下一状态的最优行动的Q值。在Q学习中,你会记录每个房间的状态、每个行动的奖励以及你对每个行动的期望价值,这个期望价值被称为Q值。当你在迷宫中

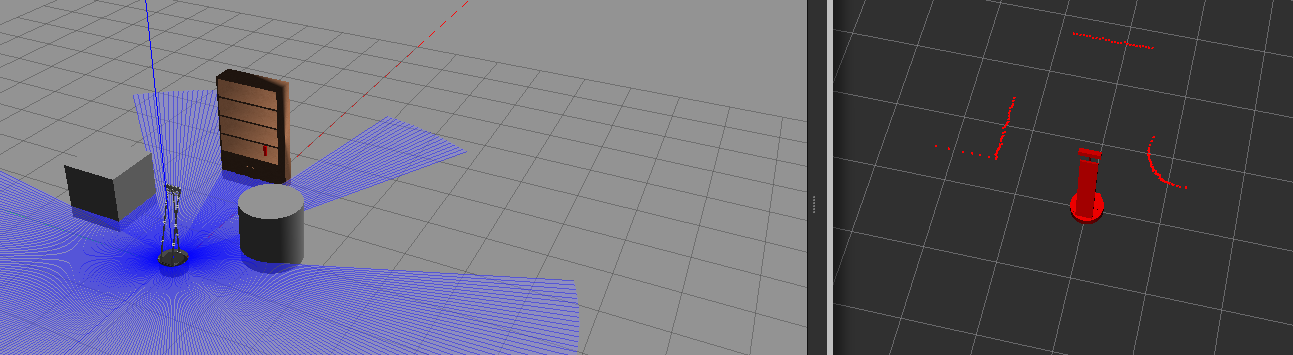

它通过发射激光束并接收反射光来测量物体的距离,生成点云数据,用于构建环境的三维模型。是一个 ROS(Robot Operating System)命令,用于订阅并显示 /scan 话题上的消息内容。–noarr 参数用于简化输出,不显示数组的完整内容,而是显示数组的类型和长度。RViz 是 ROS(Robot Operating System)中的一个可视化工具,用于显示和调试机器人数据。它支持多

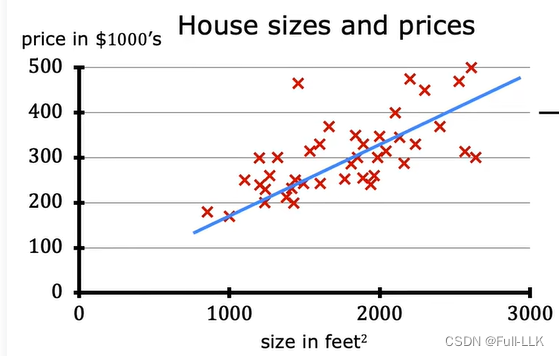

机器学习就是机器通过不断训练数据集从逐渐知道正确的结果机器学习包括监督学习和非监督学习监督学习:需要输入数据和结果数据来不断训练学习监督学习包括回归和分类回归是结果是连续的,不是有限的分类是结果是离散的,是有限的非监督学习:只需要输入数据来学习例如聚类(将某类输入数据分一组,另外一类数据分一组)

最终聚类完后可以判断新的数据是属于哪个组的,只需要通过判断其距离哪个聚类中心最近即可。讲数据点分成K个不同的组,如果不知道K值,可以一个个尝试,效果最好的就是可以的K值。像素点分为不同的聚类(特征值相似度高的就是一堆聚类)依然是根据特征,不同对象不同的表达特征形式也不一样。

基于价值迭代的方法只能应用在不连续的、离散的环境下(如围棋或某些游戏领域),对于动作集合规模庞大、动作连续的场景(如机器人控制领域),其很难学习到较好的结果(此时基于策略迭代的方法能够根据设定的策略来选择连续的动作)。策略是其从学到的价值函数里面推算出来的。之前说过Q 函数(Q-Function)表示在状态 s 下采取动作 a 后所能获得的期望累积奖励,也可以理解为当前即使奖励+下一个状态的价值函

卷积神经网络(Convolutional Neural Network),多用于图像识别,但不仅仅用于图像识别。不过我们在学习卷积神经网络的过程中,可以把图像识别当成假想任务,理解起来会更直观一些。为什么图像数据从多维(图像的原始格式)转化为一维向量(供全连接神经网络处理)时,为何会丢失空间和通道的相关信息,以及可能隐藏的模式信息。想象我们正在处理一张包含蓝天和绿色草地的照片,天空和草地之间有一个

在每次互动后,你会更新之前状态下所选择了的行动的Q值,使用一个称为贝尔曼方程的公式。这个公式会考虑之前选择了的行动后的奖励和当前状态的Q值和之前状态的Q值,以更新当前状态下的Q值。这个公式可以简单解释为:当前状态下选择某个行动的Q值等于当前即时奖励加上折扣后的下一状态的最优行动的Q值。在Q学习中,你会记录每个房间的状态、每个行动的奖励以及你对每个行动的期望价值,这个期望价值被称为Q值。当你在迷宫中

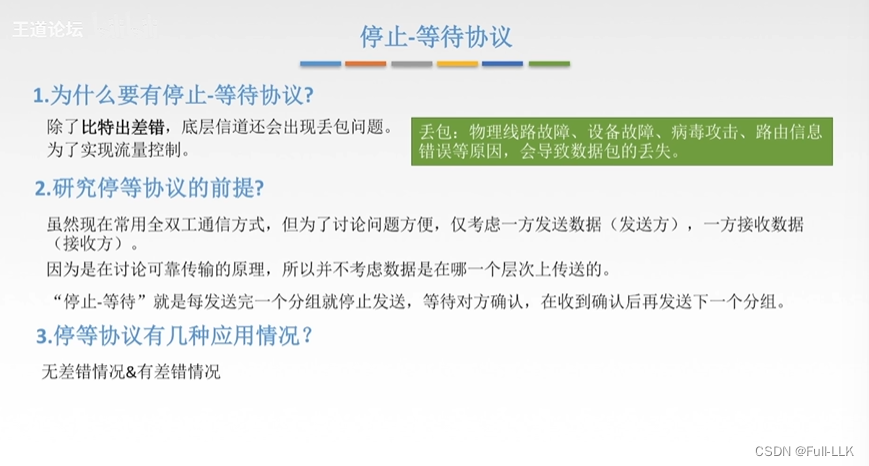

这样的设计足以满足停止-等待协议的基本需求,因为协议的核心在于确认机制,而不是在于能够处理大量的帧编号。如果迟到的确认0帧在发送方超时重传后到达,那么此时意味着0帧完成,发送方会开始发送1帧,那么当接收方再次接受到重传的0帧时会重传确认0帧,那么当发送方发送1帧后再接受到确认0帧时由于已经接受到确认0帧了,那么会将其丢弃。如果此时迟到的确认0帧在发送一帧后达到发送方,此时发送方已经收到过确认0帧了

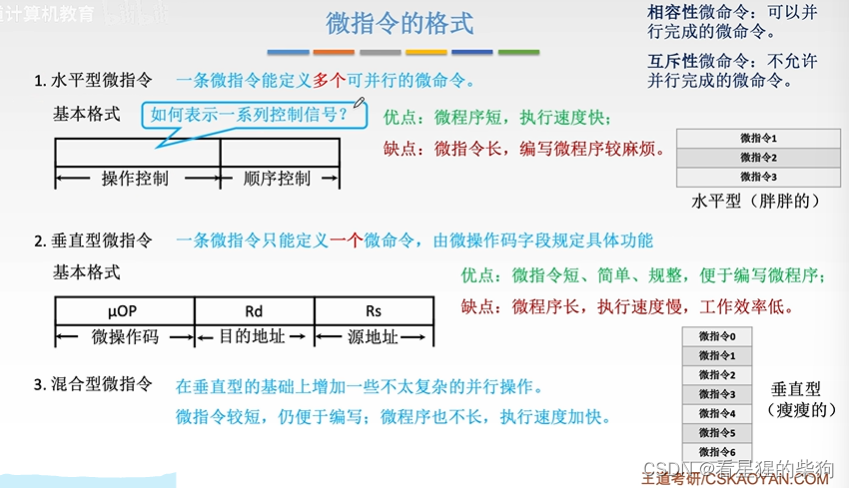

垂直型微指令的一个微操作码对应一个微命令,所以可能一个水平型微指令要对应多个垂直型微指令。任何一条指令的第一条微指令地址都是零号地址,可以由专门硬件产生。任何指令的中断周期的第一条微指令地址都一样,可以由硬件产生提供。就是通过CMDR的一些比特位上的信息和一些测试源得到微指令地址。水平型微指令的操作控制部分对应一系列微命令的控制信号。各指令对应的微程序这里是指执行周期的微指令。有译码器,所以同样长

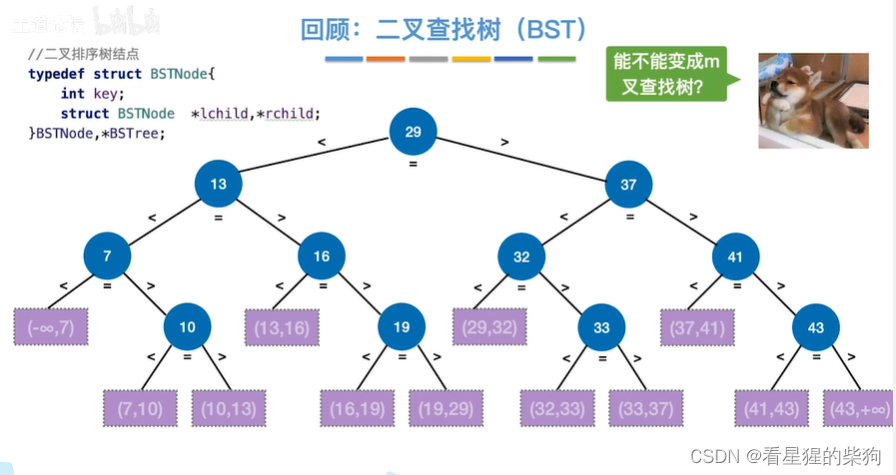

所以高度为h的最高的B树,此时的叶子节点树最小就是图中等比得来的,最大得小于终端节点的关键字总数可以多到为此时等比得来得叶子节点的关键字的数模加上终端节点关键字数目,若等于,此时高度还可以增加了。此时假设此时h为最高的B树的高度,那么此时高度最高的B树的除终端节点的节点的关键字数目必须为最小节点关键字总数,终端节点的关键字数目可以大于等于节点最小关键字总数。所以此时关键字数目为n的对应的最高的高度