简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在运行代码过程中,遇到过好几次这种Error,但是每次都忘记,需要记录一下:The "freeze_support()" line can be omitted if the program is not going to be frozen。

图像超分:真实感图像超分辨率的局部判别学习方法《Details or Artifacts: A Locally Discriminative Learning Approach to Realistic Image Super-Resolution》单图像超分辨率(SISR)问题,它旨在从低分辨率(LR)图像重建高分辨率(HR)图像。最近,由于其生成丰富细节的潜力,使用生成对抗网络(GAN)的SI

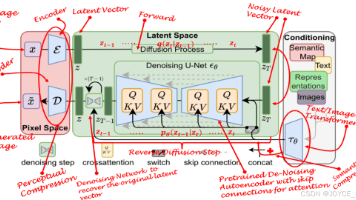

也许过去十年在计算机视觉和机器学习方面的突破是 GANs(生成对抗网络)的发明——这种方法引入了超越数据中已经存在的内容的可能性,是一个全新领域的敲门砖,现在称为生成式建模。然而,在经历了一个蓬勃发展的阶段后,GANs 开始面临平台期,其中大多数方法都在努力解决对抗性方法面临的一些瓶颈。这不是单个方法的问题,而是问题本身的对抗性。图像生成缺乏多样性模式崩溃多模态分布问题学习训练时间过长由于问题表述

神经网络的层数(深度)是模型复杂性的核心参数,直接影响其表示能力与泛化性能。本文从理论、实验和实际应用角度分析层数与泛化能力的关系,指出层数增加并不影必然导致泛化能力提升,而是需要平衡模型容量、数据规模与正则化策略。通过经典案例与最新研究,揭示深度学习的优化难题与泛化机制,为实践提供指导。

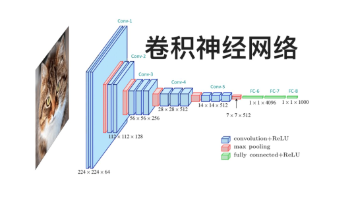

卷积神经网络(Convolutional Neural Network,CNN)是深度学习神经网络经典形式之一,由于其计算过程中包含卷积运算,因此得名。卷积神经网络(CNN)通过使用卷积层来提取图像数据的局部特征,再通过池化层(Pooling Layer)来降低特征的空间维度,最后通过全连接层(Fully Connected Layer)进行分类或回归任务。CNN已经在图像识别、目标检测、图像生成

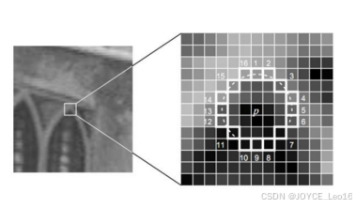

特征提取是计算机视觉领域经久不衰的研究热点,总的来说,快速、准确、鲁棒的特征点提取是实现上层任务基本要求。特征点是图像中梯度变化较为剧烈的像素,比如:角点、边缘等。FAST(Features from Accelerated Segment Test)是一种高速的角点检测算法;而尺度不变特征变换 SIFT(Scale-invariant feature transform)仍然可能是最著名的传统局

本文将从反向传播的本质、反向传播的原理、反向传播的案例三个方面,详细介绍反向传播(Back Propagation)。

在面对模型不收敛的时候,首先要保证训练的次数够多。在训练过程中,loss并不是一直在下降,准确率一直在提升的,会有一些震荡存在。只要总体趋势是在收敛就行。若训练次数够多(一般上千次,上万次,或者几十个epoch)没收敛,再考虑采取措施解决。在最后一层使用错误的激活函数会导致网络最终不能输出你期望的范围值,最常见的错误就是最后一层使用Relu函数,其输出无负值。如果是做回归任务,大多数情况下不需要使

输入为单张图像和多张图像:SISR方法输入一张低分辨率图像,利用深度神经网络学习LR-HR图像对之间的映射关系,最终将LR图像重建为一张高分辨率图像。RefSR方法借助引入的参考图像,将相似度最高的参考图像中的信息转移到低分辨率图像中并进行两者的信息融合,从而重建出纹理细节更清晰的高分辨率图像。

然而,目标检测算法的有效性很大程度上取决于输入图像的质量。图像退化是一个常见的问题,可能由低分辨率、噪声、模糊和压缩伪影等多种因素引起,严重阻碍目标检测系统的性能。本文深入探讨图像退化对目标检测的影响,分析其带来的挑战,并探索缓解这些影响的潜在解决方案。随着技术的进步,目标检测系统对图像退化的鲁棒性无疑将得到提高,从而拓宽其在不同领域中的应用范围和可靠性。在光与像素的复杂交织中,清晰与复杂相遇,目