简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

软件开发是很分裂的,只有不断使用原则和规律,才能带来质量。只要不是玩具性质的项目,项目应该可以大概划分为0-1,1-10,10-100,100-1000四个种重要阶段。其中,0-1是原型验证性的;1-10是Demo展示性的;而10-100是项目的最小功能集,可以让产品初步达到可以第一次发布的阶段;最后100-1000则需要对项目做持续的迭代,完善项目的完整功能,达成完整发布。项目立项的时候,...

云原生选题推荐,持续更新…云原生技能树直接选题云原生技能树直接需要的选题,希望完整,有体系,优质文章会直接采纳作为云原生技能树相关选题的参考资料云原生环境下,从容器、k8s、k8s下的包管理(helm)、服务网格(istio)到云原生上的微服务开发的分层体系讲解云原生下有很多工具链,哪些是核心工具链,核心工具链的命令大全Terraform命令介绍k8s持续集成介绍什么是ServiceMesh,它解

使用Bard来学习的体验不错,和之前使用GPT学习知识的效果差不多,用来理解数理知识点的原理很实用,推荐多使用。它不能回答中文也未必是坏事,可以强迫在学习中使用英文语境。Google Bard的新模型使用的是PaLM,暂时不支持中文,本次测试使用Bard模型来辅助理解一个时间序列预测模型ARIMA。

什么是有限状态机(Finite State Machine)?什么是确定性有限状态机(deterministic finite automaton, DFA )?什么是非确定性有限状态机(nondeterministic finite automaton, NDFA, NFA)?[1] wiki-en: Finite state machine[2] wiki-zh-cn: Finit...

0x01 布尔代数(Boolean algebra)大名鼎鼎鼎的stephen wolfram在2015年的时候写了一篇介绍George Boole的文章:George Boole: A 200-Year View。怎样用数学公理重新表达经典逻辑?George Boole在19世纪的时候开始思考这件事,在他的书《The Mathematical Analysis of Logic》里面Geo...

语言核心Python编码规范realpython深入探索Eval really is dangerous, Python的Eval无论怎样难以做到安全,看来Python里做沙盒很麻烦Exploring Python Code Objects, 上面的文章用到了Python的code对象,这里有进一步的探索dis — Disassembler for Python bytec......

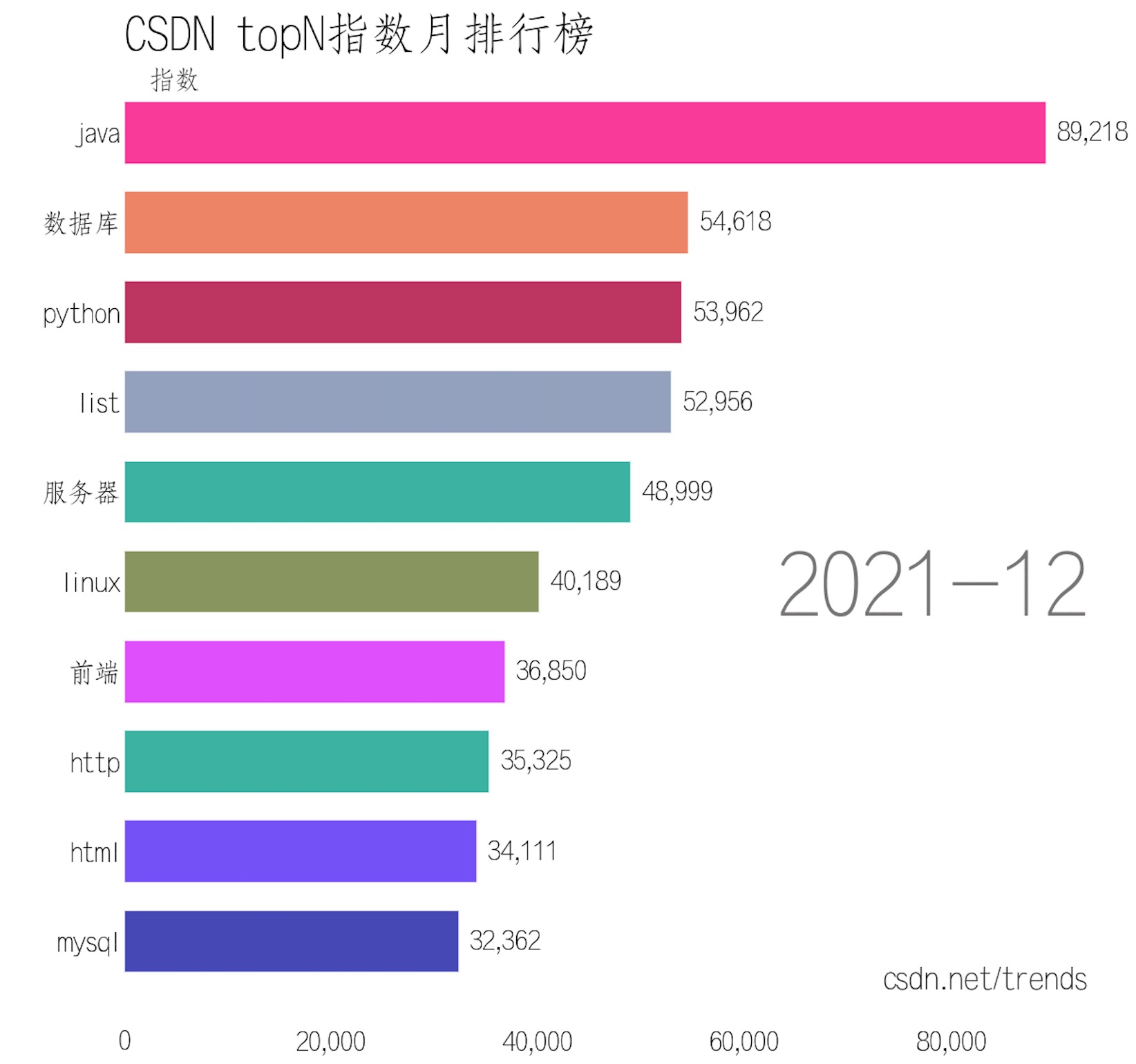

开源一个 topn 词竞赛动画项目 topn_race:GitCode 仓库:https://gitcode.net/csdn/topn_race核心功能:输入:按月统计的topN词频数据输出:topN词频竞赛动画(可带音效)源码结构本项目基于开源项目:https://github.com/dexplo/bar_chart_race 定制,src/bar_chart_race 从 bar_char

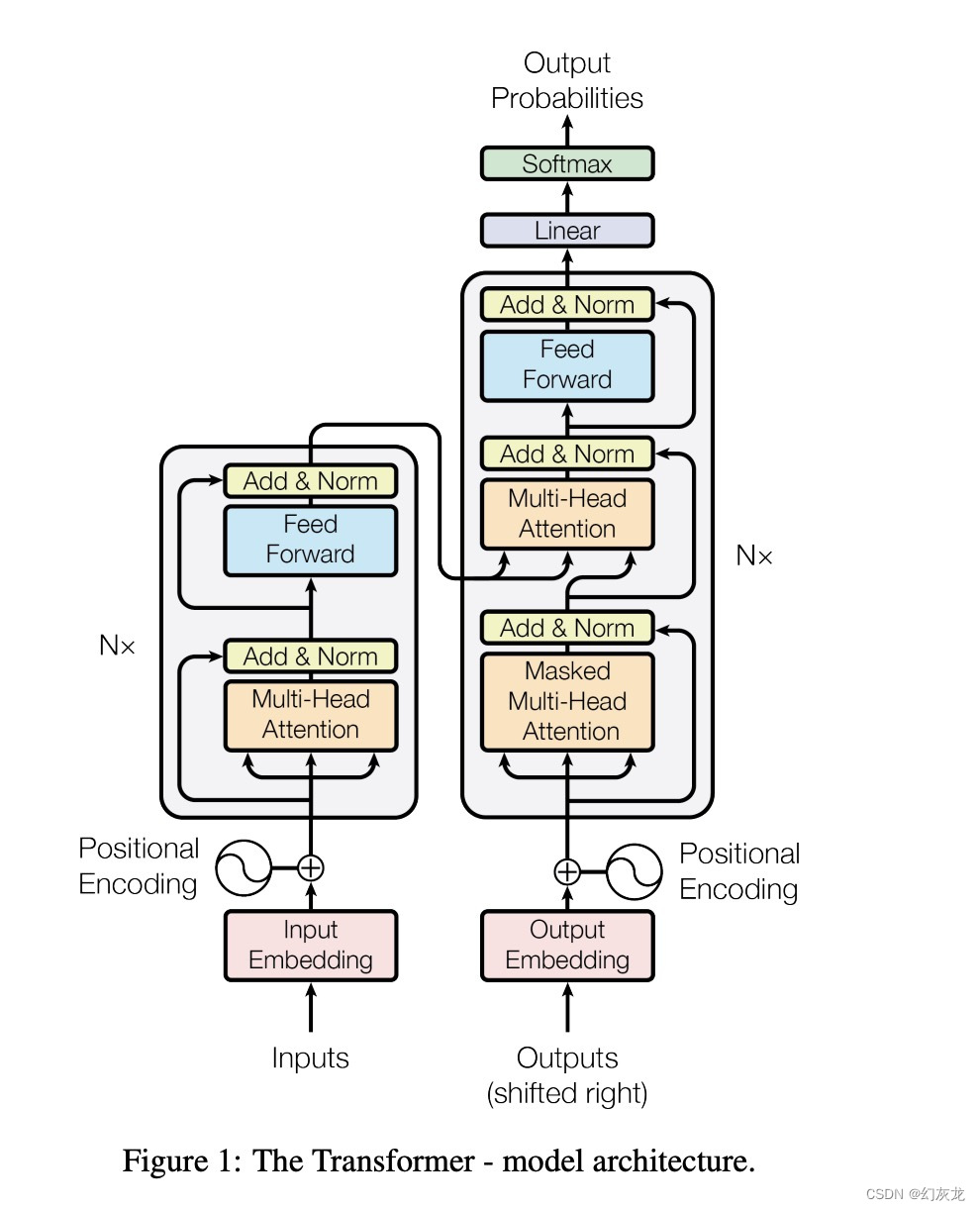

其中,左侧的每个Trm代表,右侧的放大图,也就是原始Transformer的Encoder部分结构。Bert的训练任务包括MLM(Masked Language Model)和NSP(Next Sentence Prediction). Bert的训练是无监督的,因为MLM实际上就是将语料的某些Token遮挡起来,那么输出结果需要知道答案是什么(标注信息)实际上就包含在语料里。GPT是无监督的,因

使用Bard来学习的体验不错,和之前使用GPT学习知识的效果差不多,用来理解数理知识点的原理很实用,推荐多使用。它不能回答中文也未必是坏事,可以强迫在学习中使用英文语境。Google Bard的新模型使用的是PaLM,暂时不支持中文,本次测试使用Bard模型来辅助理解一个时间序列预测模型ARIMA。

本文是在知乎上对同名问题做的回答:直接答案: 是!细细说下为什么。从前,写代码只要在单机上写即可,但是编程会演化。例如,写单机程序。写一个单机命令行程序; 写一个单机GUI程序,此时需要关心数据,模型,界面; 写一个单机网页程序。程序利用到了单机的资源: 内存,CPU,磁盘存储。为了利用内存,做了各种压榨内存的内存分配器,为了便利地使用内存,有了引用计数和垃圾回收。为了利用CPU,操作系统提供了进