简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

通道注意力和空间注意力分别为各种下游视觉任务在提取特征依赖性和空间结构关系方面带来了显著改进。通道注意力和空间注意力的结合使用被广泛认为有利于进一步提升性能;然而,通道注意力和空间注意力之间的协同作用,尤其是在空间引导和缓解语义差异方面,尚未得到深入研究。这促使我们提出了一种新的空间与通道协同注意模块(SCSA),该模块涉及我们在多个语义层面上对空间注意力和通道注意力之间协同关系的研究。我们的SC

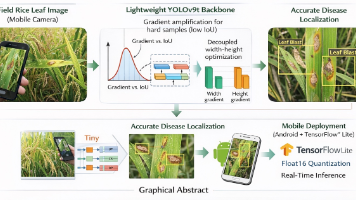

水稻叶部病害的早期准确检测对于精准农业至关重要,然而在资源受限的移动设备上部署高性能目标检测模型仍然是一个重大挑战。在本工作中,我们提出了N−EIoU−YOLOv9N−EIoU−YOLOv9,一个轻量化检测框架,其核心是一种源自非单调梯度聚焦和几何解耦原理的信号感知边界框回归损失,称为N−EIoUN-EIoUN−EIoU(非单调高效交并比)。

模块化是计算机科学的基石,它将复杂功能抽象为原子构建模块。在本文中,我们通过将生成模型抽象为原子生成模块,引入了新一级的模块化。类似于数学中的分形,我们的方法通过递归调用原子生成模块,构建了一种新型生成模型,从而形成了自相似的分形架构,我们称之为分形生成模型。作为一个运行示例,我们使用自回归模型作为原子生成模块来实例化我们的分形框架,并在具有挑战性的逐像素图像生成任务上对其进行了检验,在似然估计和

你是否想过,未来的语音助手不仅能“说话”,还能根据你的需求调整音色、语速甚至情绪?近日,一项名为的突破性技术横空出世,它基于大语言模型(LLM),将文本转语音(TTS)技术推向了全新高度!今天,我们就来揭秘这项“会思考的语音合成黑科技”。

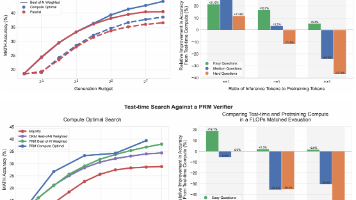

遵循Lightman等人[22]的方法,我们基于基础LLM定义问题难度。具体来说,我们将模型在测试集每个问题上的pass@1率(通过2048个样本估计)划分为五个分位数,分别对应递增的难度等级。我们发现,这种基于模型的难度分箱比MATH数据集中的手工标注难度更能预测测试时计算的有效性。需注意,上述难度评估假设可访问地面真实正确性检查函数,而实际部署时我们无法知晓测试提示的答案。因此,基于难度的计算

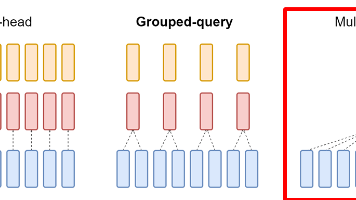

在了解MQA之前,我们先简单回顾一下Transformer模型中的多头注意力机制(MHA)。MHA是让模型能够同时关注输入序列中不同位置信息的关键技术,它通过多个"注意力头"来捕捉不同的语义关系。而MQA则是MHA的一个精简版本:它保留了多个查询(query)头,但所有查询头共享同一个键(key)和值(value)头。这个看似简单的改动,却带来了惊人的性能提升!MQA代表了大模型高效推理的重要方向

我们推出了MiniMax-M1,这是全球首个开源权重、大规模混合注意力推理模型。MiniMax-M1采用了混合专家系统(Mixture-of-Experts,简称MoE)架构,并结合了闪电注意力机制。该模型是在我们之前的MiniMax-Text-01模型(MiniMax等人,2025年)基础上开发而来的,该模型总共有4560亿个参数,每个标记激活459亿个参数。M1模型原生支持高达100万个标记的

由大语言模型(LLMs)驱动的深度研究助手正在迅速发展,然而,在使用通用的测试时扩展算法生成复杂的长篇研究报告时,其性能往往会趋于平稳。受人类研究迭代性的启发,人类研究包括搜索、推理和修订的循环过程,我们提出了测试时扩散深度研究助手(Test-Time Diffusion Deep Researcher,TTD-DR)。这一新框架将研究报告的生成视为一个扩散过程。TTD-DR以初步草稿为起点,这一

#百度搜索开放平台 #百度AI开放计划 #mcp #mcpserver#create2025 #AI当AI应用如雨后春笋般涌现,开发者们却面临一个共同困境:“酒香也怕巷子深”。即便产品再创新,若无法触达用户,一切努力终将归零。而百度搜索最新推出的AI开放计划,正试图用“开放”二字撕开流量困局,为开发者铺就一条从技术到商业的“高速公路”。AI应⽤爆发时代,智能体、H5、⼩程序、APP等各种AI应⽤形

在人工智能的浩瀚宇宙中,大模型如同璀璨的星辰,以其卓越的知识理解、复杂的语言生成能力和惊人的信息处理能力,在学术领域内掀起了新的热潮。涌现出一大批优秀的模型,比如,OpenAI的ChatGPT、GPT4等,百度的文心一下、字节的豆包,还有最近大火的DeepSeek-V3等等。然而,当这些理论上的巨人踏入工程实践的广阔天地时,却常常展现出一种与之不相称的“矮子”姿态。比如大模型的幻觉问题,准确性问题