简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

《2026年网络安全预测》揭示AI已从防御工具演变为网络战武器,自主恶意软件、深度伪造和AI驱动勒索软件威胁激增。身份安全成为新防线,零信任架构加速采用,量子计算和物联网漏洞带来新挑战。网络安全已从IT问题转变为核心业务重点,组织需采用持续威胁暴露管理和人机协作的AI辅助防御,以比攻击者更快的速度恢复,实现真正的韧性。

本文是一位普通本科转行网络安全5年、月薪2W+的从业者分享的行业真实情况和学习建议。文章指出网络安全行业虽缺人,但需要真正能解决问题的技术人才,而非仅靠考证或速成班。作者分享了从零基础到进阶的实用学习资源,包括Hacksplaining、Try Hack Me等入门网站,Hack The Box等实战平台,以及优质YouTube教学频道。最后强调网络安全行业看重实际能力而非学历背景,建议有意入行者

看到一个平台上的博主,目前在做独立开发者,开发了20多个网站,网站的类型主要是工具型和信息整理型,谷歌广告的收益一个月1万多。目前他除了依靠谷歌广告的收入外,也在做自媒体,拓展这一块的收入,毕竟依赖一家平台,还是有风险的,和投资一样,收入最好多元化,要冗余,不只依赖一家平台。

程序员副业指南:5种变现途径解析 程序员凭借技术优势和互联网思维,具备发展副业的天然优势。本文介绍了5种适合程序员的副业方向:1)接外包项目,直接变现技术能力;2)做技术自媒体,打造个人IP;3)成为独立开发者,开发小程序或App;4)AI工具出海,把握最新技术趋势;5)运营付费社群,提供持续价值。文章通过真实案例说明,程序员可结合自身专长选择合适方向,但要控制风险,避免影响主业。文末还提供了网络

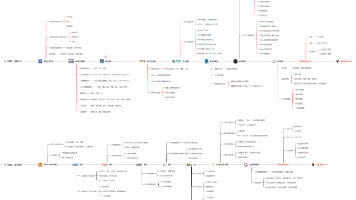

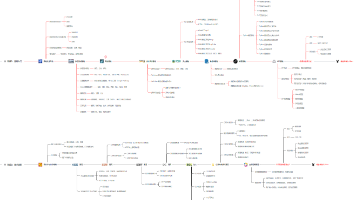

网络安全高效学习三步法:先打基础(2-3周掌握Linux、网络协议等核心概念),再练渗透(学习八大漏洞和工具使用),最后攻内网(靶场实战提升企业级攻防能力)。这套路径帮助新手避免盲目学工具,从原理到实战循序渐进,学完可胜任初级渗透岗位,后续通过编程和内网渗透进阶成为企业需要的安全人才。关键要理解"慢即是快",基础扎实才能高效成长。

2025年,网络安全威胁呈现高度复杂化、隐蔽化与自动化的特征,勒索病毒、无文件攻击、AI驱动的APT攻击等新型威胁层出不穷。面对此类挑战,高效的应急响应能力已成为企业生存的“生命线”。本文结合全球最新威胁情报与实战经验,系统梳理45个网络安全应急响应核心技巧,涵盖预防准备、事件检测、快速阻断、深度分析、恢复加固五大阶段,助力企业构建“零信任”防线。

网络安全工程师2026年学习路线分为两个阶段:1-2个月筑基期掌握Linux、网络协议、Python编程等基础,能搭建测试环境并理解漏洞原理;2-3个月攻坚期学习渗透测试、漏洞挖掘等核心技术,达到独立发现低危漏洞水平。行业现状显示,网络安全人才缺口大但竞争激烈,需掌握AI攻防等新技能,认证与实战经验缺一不可。建议通过Docker部署靶场环境进行实战训练,逐步提升能力。

本文探讨网络安全工程师如何实现技术变现与收入增长。随着AI与各行业深度融合,网络安全需求激增,但实战型人才缺口不断扩大。文章提出20+实战路径,包括漏洞赏金猎人(年入5万+)、安全众测接单(月均3k-1.5万)、AI模型定制开发、护网/考证中介等。校园市场也被视为黄金机会,如宿舍网络优化、二手设备倒卖等低成本项目。通过短视频科普(如黑客工具测评)也可实现知识变现。文章强调技术硬实力是关键,帮助网安

独立开发者的多元化创收路径 本文探讨了独立开发者的多种盈利模式: 软件产品开发(APP/SaaS/桌面软件) 流量型网站运营(广告收益) 定制开发服务 插件/扩展开发 知识付费(教程/课程) 开源项目赞助 技术咨询服务 模板/代码销售 技术支持维护 独立游戏开发 案例显示,某开发者通过20多个工具型网站获得月均1万+广告收入,同时拓展自媒体实现收入多元化。文章强调独立开发者需具备产品、运营等综合能

我现在的同事里,有以前做销售的、做行政的、做会计的,最离谱的是有个前外卖小哥,学了三个月网安,现在做安全监控,月薪比以前送外卖多 5K。他们跟我一样,都曾在失业时焦虑到失眠,但转头选对了网安这个 “缺人缺到急眼” 的赛道,反而活得更滋润。2025 年的就业市场,不是没有机会,是你没找对地方。传统岗位卷不动了,不如转头看看网安 ——327 万的人才缺口,零经验能入门,边学边赚钱,这不比你投 100