简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

掌握高效的端口扫描技巧,能让你在安全测试中事半功倍。通过合理配置nmap参数,结合自动化脚本和定时任务,你可以构建一个强大的端口扫描体系,为后续的渗透测试和安全评估打下坚实基础。工具只是辅助,真正的高手还需要深厚的网络安全知识和丰富的实战经验。希望这篇文章能为你的安全测试之路提供一些启发和帮助。最后,安全测试是一项需要持续学习和实践的技能。如果你有任何问题或想法,欢迎在评论区留言讨论。黑客&网络安

最开始就是简单学习代码知识,个人建议最开始还是Python或者Go,Python在数据处理和Ai这里其实都很有优势,Go的优势是比Python快,同时线程高并发。我的理解是工具的自动化其实就是代替人去做重复工作的事情,比如一个漏洞扫描器,常规的漏扫工具的原理就是通过已知的poc,代替人工去尝试,通过特定的请求和返回特征去判断是否存在。判断,是一个自动化脚本准确性的依据,也就是特征值,在一个脚本中,

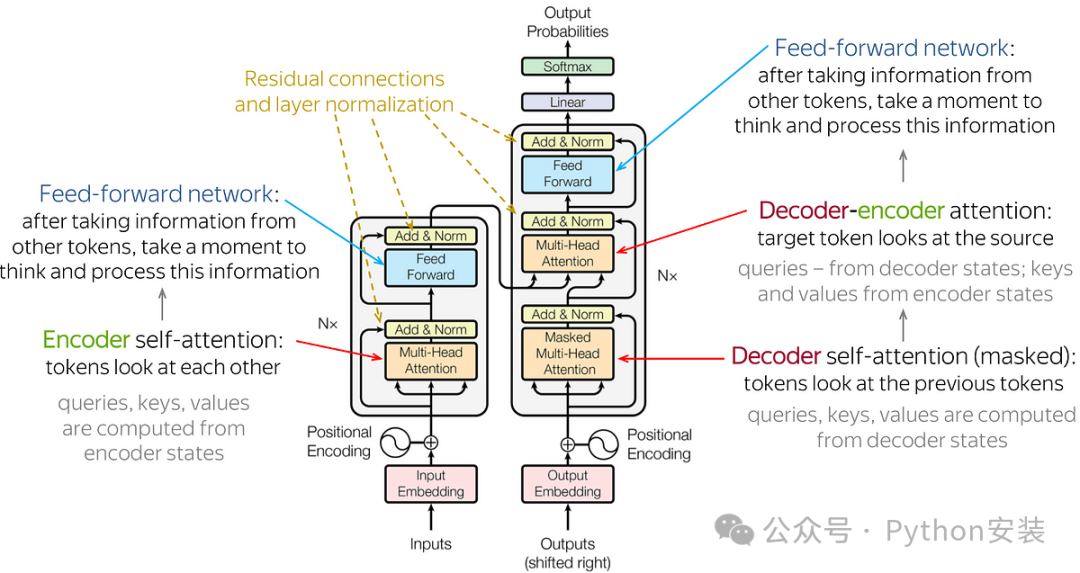

人工智能大模型,是指通过在海量数据上依托强大算力资源进行训练后能完成大量不同下游任务的模型。大模型以其在模型精度和泛化能力等多个指标上超越传统AI模型的表现,以及赋能千行百业的巨大潜力,成为当今世界各国人工智能技术发展的核心方向。大模型经过近一年半的高速发展,已在政府、医院、学校、企业等各类需求群体中建立初步认知。其中一部分需求群体设立专项预算、开放业务场景,对大模型进行试点应用。

你知道的数据标注都有哪些?数据标注(Data Annotations)是指对收集到的、未处理的原始数据或初级数据,包括语音、图片、文本、视频等类型的数据进行加工处理,并转换为机器可识别信息的过程。矩形框标注是一种的简单处理方式,常用于等。多边形标注是指在静态图片中,使用多边形框,标注出不规则的目标物体,相对于矩形框标注,**多边形标注能够更精准地框定目标,**同时对于不规则物体,也更具针对性。语义

内容概要:包括 内网、操作系统、协议、渗透测试、安服、漏洞、注入、XSS、CSRF、SSRF、文件上传、文件下载、文件包含、XXE、逻辑漏洞、工具、SQLmap、NMAP、BP、MSF…技术文档也是我自己整理的,包括我参加大型网安行动、CTF和挖SRC漏洞的经验和技术要点,电子书也有200多本,由于内容的敏感性,我就不一一展示了。网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己录的网安

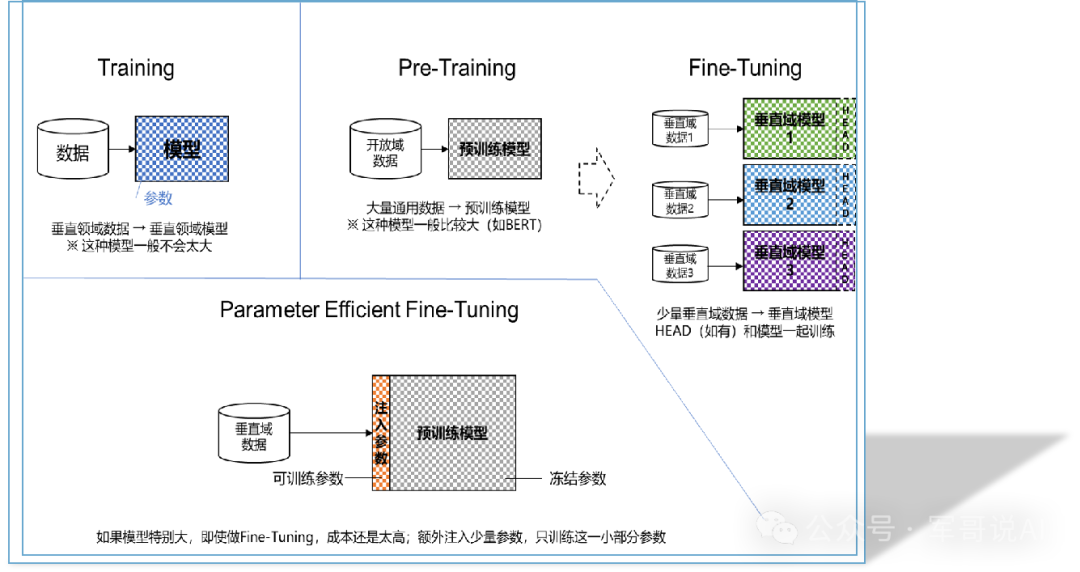

*轻量化微调 (Parameter Efficient Fine-Tuning,PEFT)😗*一种优化策略,用于减少模型的计算资源需求,同时保持或提高模型性能。由于大模型的参数太大,即使是fine-tuning通常也需要很大的算力和数据,因此提出在保持原有大模型参数不变的前提下,注入少量参数,通过只训练该部分参数的方式来实现微调目的。在机器学习和深度学习领域,训练、预训练、微调和轻量化微调是几个

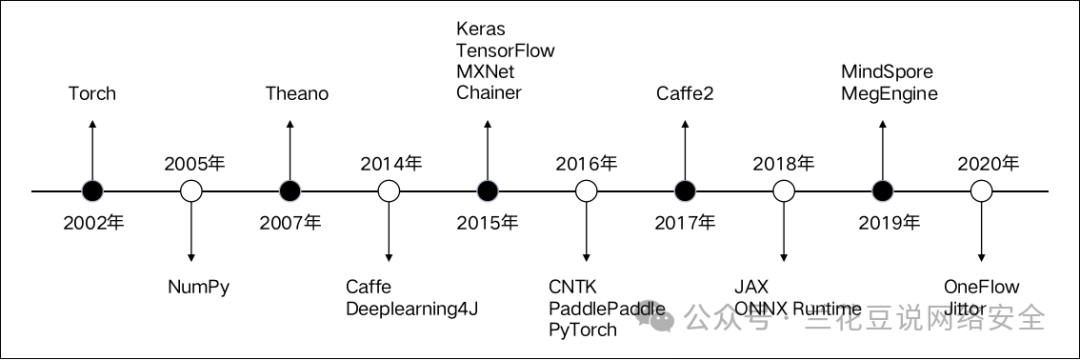

AI江湖传言:得框架者得天下,可见AI框架的重要性,它通过框架性思维整合了人工智能的三驾马车(算法、算力、数据),如果想成为头部AI企业,AI框架就是其中一项核心竞争力,这样才不会受制于人,才能体现AI基础研究能力,这也是为什么AI公司争相研发自己的AI框架。主要作者为微软的研究团队。正是在这样一个环境优美,生活惬意的地方,可能是做学术最好的环境,自由和灵感在这里悄无声息地碰撞,这里的研究所是全球

如果你真心想要入门大型语言模型(LLM),只看这一个文章应该是可以入门的。但是修行下去,还是要靠自己的了!如果你把大语言模型/LLM 当成一门技术来看,那就要看一下这门技术需要什么。基本要求:开发语言:Python , C/C++开发框架和工具库: Numpy /Pytorch /Tensorflow /Keras /Onnx数学知识:线性代数、高数、概率、凸优化这些东西我们假定你都已经会了,或者

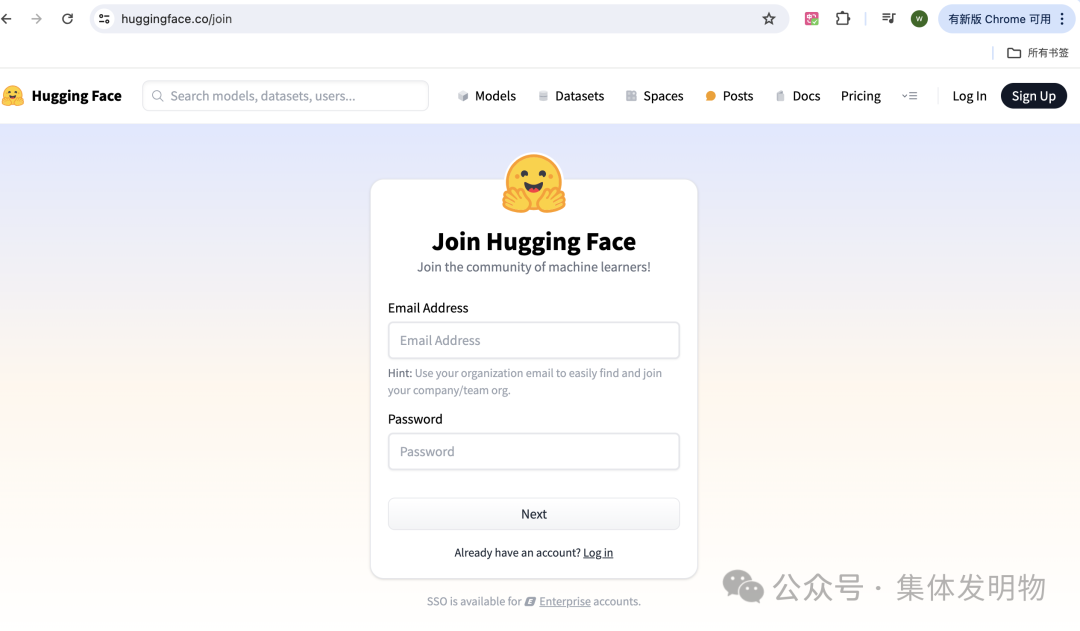

我总是受大脑运行方式的启发…大脑收集信息,然后对信息进行加权再输出,问题就在于,怎么调整这些权重使这些信息发挥作用。—— 杰弗里·辛顿今天和大家分享下,怎么用开源工具免费微调大模型。要用到的工具有:autotrain:huggingface开放的零代码大模型微调平台,无需编程,只需要通过简单的界面操作就能够进行colab:一个在线交互式Python运行环境,主要是用来提供大模型微调时的云端计算资源

本文将完整介绍使用LoRA进行模型微调。使用框架。代码可以在 我的github[1] 上找到。