简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

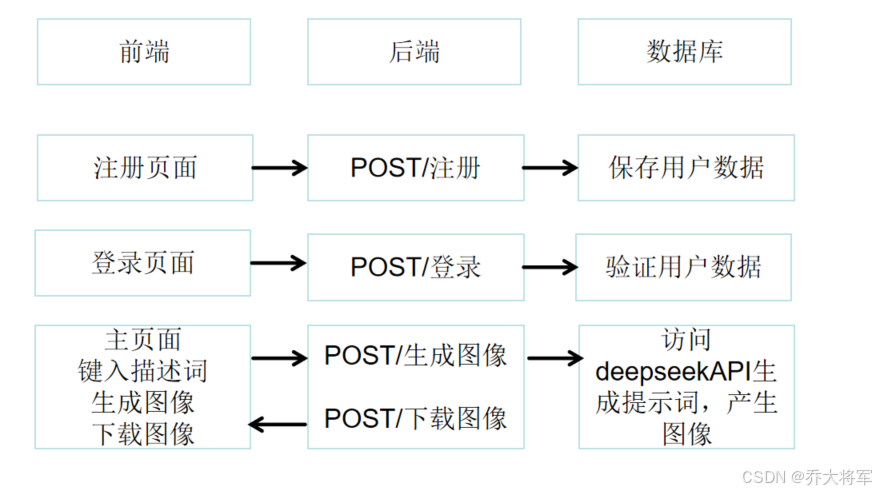

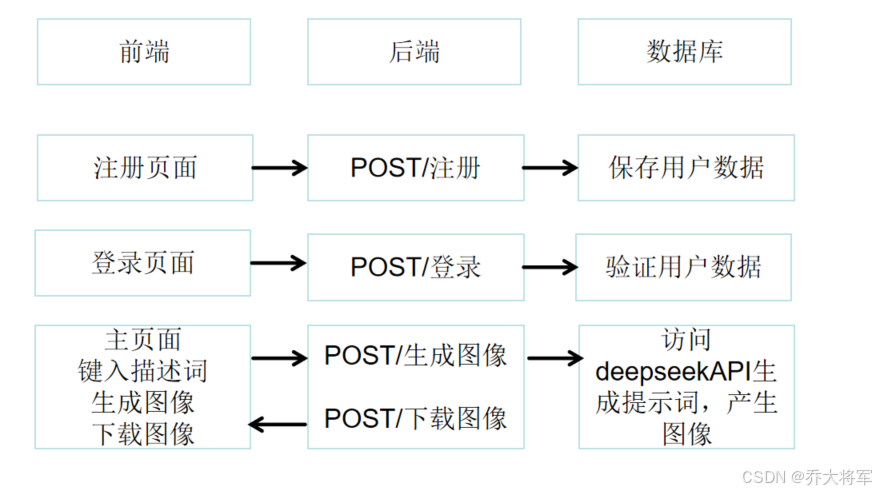

你现在是一个ai图片生成机器人,我给你一些提示,你用你的想象力去生动描述这幅图片,并转换成英文填充到下面url的占位符中:!当你向这个URL发送请求Pollinations AI的服务器会根据URL中的参数生成一张图片,并将图片返回给你,其中包含了不少AI绘图所需的参数,内行人应该一眼就能看懂~但是它可以生成图像生成的描述词,那么是否可以使用deepseek生成描述词,然后用其他的AI绘画工具去生

访问deepseek时出现网络延时问题。

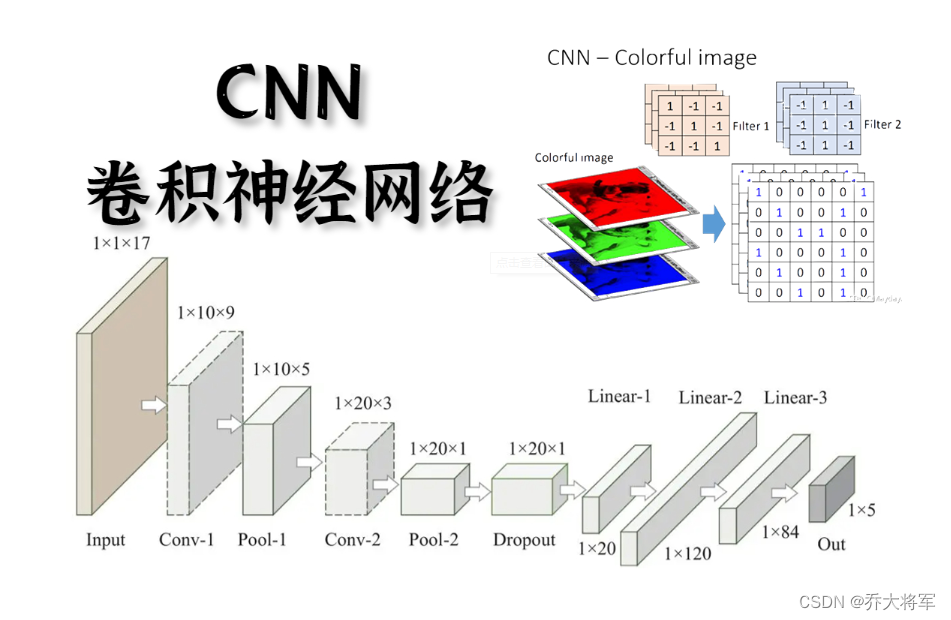

大家联系神经网络提取特征的过程,经过隐藏层,将输入特征值增大,减小,特征数量增多,减少,最后学习到了特征,虽然人是看不出,读不懂这样的特征。那么卷积的作用也是提取特征,而且克服了神经网络的参数过多,容易过拟合的问题。想象一下,一张图片有主次之分,有背景,有人物,把一张图片分成一块一块的(张量),每一块都有它的代表特征,怎么得到这个特征呢???引入卷积核(类似于神经网络中的权重参数矩阵)卷积核在定义

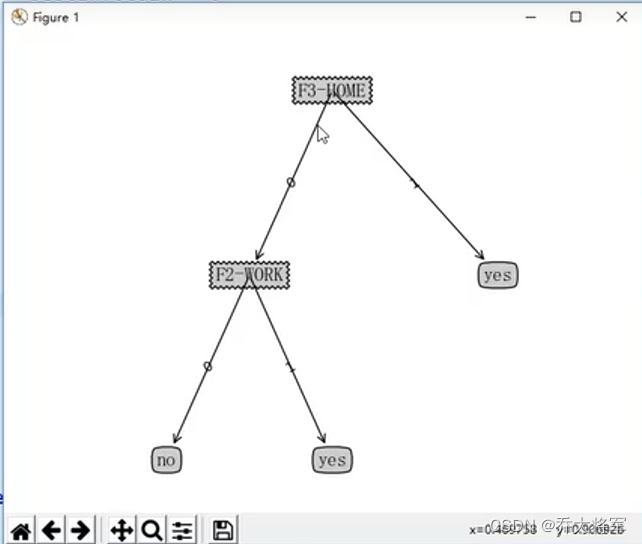

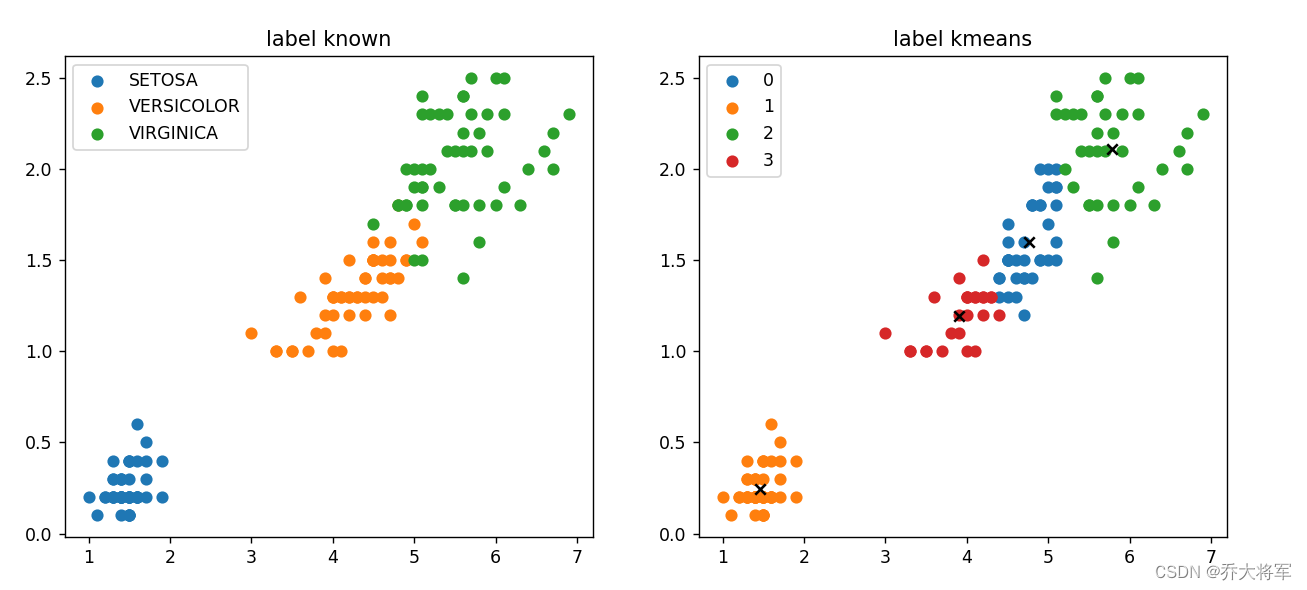

本文主要实现K-means这一算法,根据聚类算法理论篇(K-means,DBSCAN原理)可知:输入:数据dataK值输出:簇组其工作流程:1.根据K值,随机创建K个初始化质心点(Initialozation Randomly selecr K center points。2. 算出所有样本点到质心点的距离,得到样本属于那个簇。3. 更新,根据簇内样本重新算出簇内的质心。4. 重复执行2,3步,重

你现在是一个ai图片生成机器人,我给你一些提示,你用你的想象力去生动描述这幅图片,并转换成英文填充到下面url的占位符中:!当你向这个URL发送请求Pollinations AI的服务器会根据URL中的参数生成一张图片,并将图片返回给你,其中包含了不少AI绘图所需的参数,内行人应该一眼就能看懂~但是它可以生成图像生成的描述词,那么是否可以使用deepseek生成描述词,然后用其他的AI绘画工具去生