简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

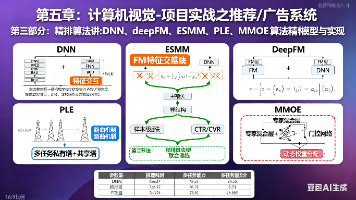

本文介绍了DeepFM模型在推荐/广告系统精排算法中的应用。该模型结合了FM和DNN的优势,既能显式建模低阶特征交互(如用户性别×商品品类等常见交叉特征),又能通过DNN捕捉高阶非线性关系。文章详细解析了DeepFM的三部分结构(FM、Embedding、DNN),对比了其与纯DNN模型的差异,并提供了PyTorch实现代码。作为工业界成熟的CTR/CVR精排基础模型,DeepFM具有端到端训练、

PlattScaling是一种广泛使用的概率校准方法,旨在将机器学习模型的输出分数映射为概率,以提高预测结果的可解释性和实用性。然而,这种方法并非没有缺陷。首先,PlattScaling通过训练额外的逻辑回归模型来实现校准,这通常需要进行交叉验证以避免过拟合,导致计算资源和时间的显著增加。其次,由于过分关注概率拟合,可能会导致预测概率与实际分类结果不一致,特别是在数据分布不平衡的情况下。为了解决这

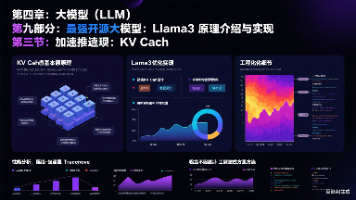

摘要:KVCache是一种用于加速Transformer模型推理的技术,通过缓存历史token的Key/Value向量避免重复计算。在自回归生成过程中,KVCache将计算复杂度从O(T²)降至O(T),显著提升推理效率。Llama3对KVCache进行了多项优化,包括高效缓存布局、动态长度支持、分块机制和显存优化等,使其能更好支持长上下文推理。该技术通过存储中间状态,解决了传统Transform

本文介绍了基于LangGraph构建历史与数据分析协作系统的设计方案。该系统通过模块化Agent架构,将历史查询、数据收集、分析处理和报告生成等功能拆分为节点化流程,实现自动化历史研究和数据分析。系统核心包括用户输入解析、历史知识检索、数据收集清洗、分析可视化及报告生成五大模块,支持多用户协作和模块化扩展。文中提供了Python代码示例展示节点间的数据流转,并给出知识库扩展、多维分析和可视化增强等

本文介绍了LangGraph,一种基于图结构的大模型工作流编排工具。作为LangChain的扩展,LangGraph通过节点和边的概念管理复杂流程,支持状态驱动和可视化调试。核心包括Graph、Node、Edge和State四个组件,适合需要多工具组合的复杂Agent设计。与传统Agent相比,LangGraph提供了更可控的流程、直观的可视化和便捷的调试能力。文章展示了基本使用方法,包括定义节点

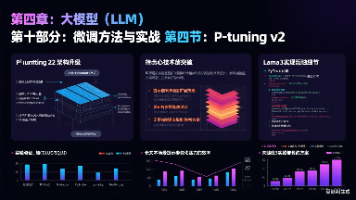

Prefix-Tuning是一种高效的大模型微调方法,通过在各层注意力机制中嵌入可学习的前缀向量(PK/PV),实现仅训练少量参数(1%)即可引导模型输出。相比全参数微调,它显著降低计算开销;相较于PromptTuning,其在生成任务中表现更优。核心原理是将前缀拼接至Key/Value矩阵,使模型隐含记忆特定信息。实验表明,Prefix-Tuning在GPT-2/3等生成任务中接近全参数微调效果

摘要:本文探讨了Embedding技术在AI发展中的核心作用。从Word2Vec的词向量表示开始,Embedding实现了从离散符号到连续向量的转变,构建了语义空间基础。随后在推荐系统(如淘宝的item2vec)和广告系统(如Wide&Deep模型)中得到广泛应用,解决了高维稀疏特征的处理问题。随着技术演进,Transformer模型(BERT/GPT)实现了动态上下文相关的Embeddi

LangChain是一个模块化的开源框架,用于简化大语言模型(LLM)的集成与应用开发。其核心特性包括模块化设计、组件可组合性和模型易扩展性,支持OpenAI、HuggingFace等多种模型。框架提供LLM类处理文本生成、ChatModel类管理对话交互,以及Embedding类实现语义处理。通过PromptTemplate动态生成提示词,结合LLMChain实现任务链式调用,并支持多模型协作。

本教程详细介绍了基于Llama3的现代文与古文互译大模型微调实战。针对现有模型在古文翻译上的不足,采用QLoRA方法对Llama3-8B进行高效微调,单卡24GB GPU即可运行。内容包括:数据准备(构建平行语料)、模型加载与量化配置、LoRA参数设置、训练过程及推理测试。项目优势在于低成本实现高质量翻译,适用于教育辅助和古籍数字化,但需注意古文多义性带来的挑战以及语料质量要求。完整代码涵盖数据处

DeepSeek-V3作为第三代开源大模型,实现了236B参数的混合专家架构(MoE),采用Top-2路由机制,仅激活21B参数即可完成推理,显著提升了计算效率。该模型在中文任务表现优异,具备完整开源生态和商用授权,但实际落地仍面临四大挑战:MoE部署复杂度高、路由负载不均衡、精调成本大及业务适配性问题。针对这些问题,建议采用DeepSpeed-MoE等专业推理框架,结合路由平衡优化和LoRA精调