简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

51单片机和STM32是嵌入式开发中两种主流的微控制器,它们在架构、性能、应用场景等方面存在显著差异。

给单片机植入操作系统(通常是实时操作系统,RTOS)主要是为了在资源有限的环境中实现更高效、更可靠的多任务管理和系统调度。通过植入操作系统,开发者能更专注于业务逻辑,而非底层细节,从而提升开发效率和系统可靠性。

嵌入式 Linux 镜像制作的本质是“硬件驱动软件,软件适配硬件阶段核心产出物解决的核心问题环境搭建交叉工具链+硬件信息确保能为目标硬件编译代码Bootloader 制作u-boot.bin解决“如何初始化硬件并加载内核”内核与设备树制作解决“内核如何识别并驱动硬件”根文件系统构建rootfs解决“用户如何与系统交互、运行应用”镜像集成与烧写完整系统镜像解决“如何将软件组合并写入硬件存储”

一种简单而强大的信息整合策略,它通过直接连接不同来源的特征来拓宽网络的“信息面”,为后续的网络层提供更丰富、更原始的数据原料,让其自行学习最优的特征组合方式,从而提升模型对复杂模式和关系的捕捉能力。它在现代网络架构(如 U-Net, Inception, DenseNet, 多模态模型)中扮演着不可或缺的角色,是构建复杂、高性能神经网络的基础组件之一。

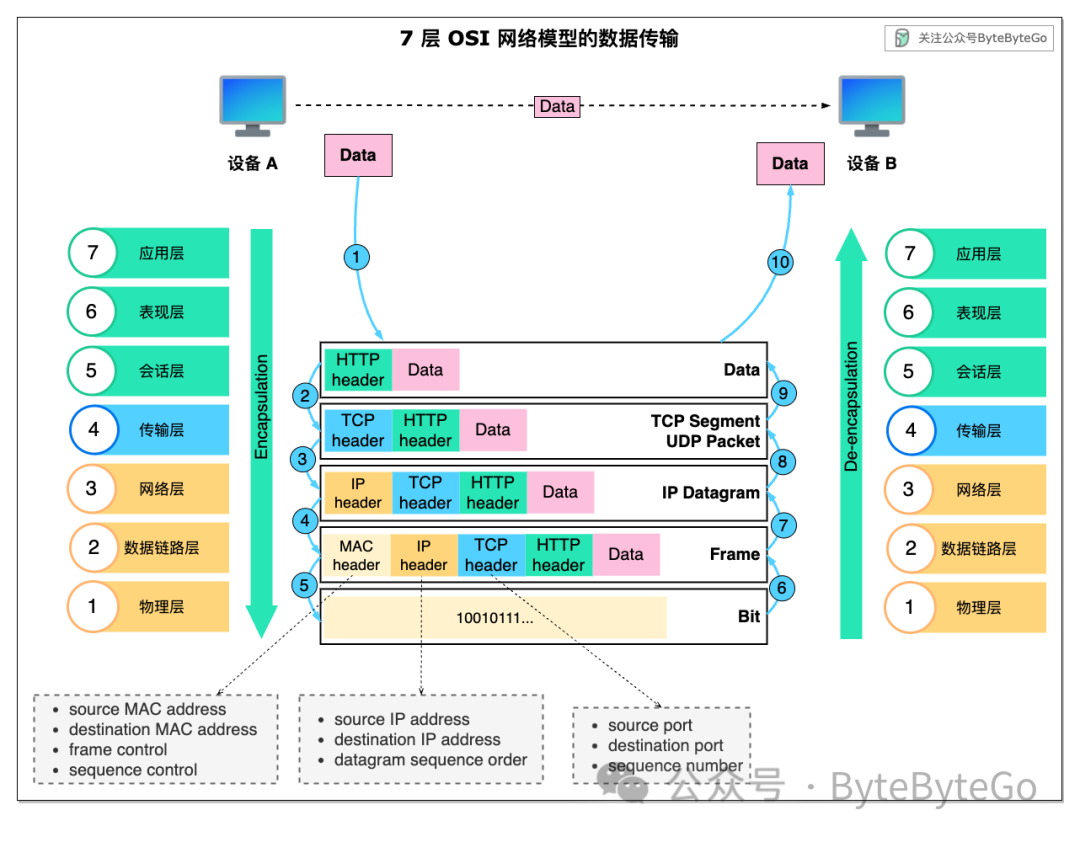

我们为什么需要 7 层 OSI 网络模型?

Transformer模型完全基于注意力机制,没有任何卷积层或循环神经网络层。尽管Transformer最初是应用于在文本数据上的序列到序列学习,但现在已经推广到各种现代的深度学习中,例如语言、视觉、语音和强化学习领域。Transformer作为编码器-解码器架构的一个实例,其整体架构图如下展示。正如所见到的,Transformer是由编码器和解码器组成的。

需要注意的是,这种计算方式是基于严格的月份差异,不考虑每个月的具体天数。如果您需要考虑具体的天数差异,那么您可能需要在计算中使用更复杂的逻辑,考虑每个月的实际天数和闰年的情况。需要注意的是,这种计算方式是基于严格的年份差异,不考虑每年的具体天数,也不考虑闰年的情况。如果您需要更精确的年龄差异计算,可能需要在计算中考虑每年的实际天数和闰年。请注意,这个方法会自动考虑每个月的具体天数和闰年情况,因此得

推挽输出:有两个晶体管控制电流,可以同时输出高电平和低电平,适用于需要驱动较大负载的场合。开漏输出:仅使用一个晶体管,输出高电平时通过上拉电阻实现,适用于总线通信、多个设备共享一个信号线的场合。参考:https://blog.csdn.net/weiqifa0/article/details/115191377。

Pytorch中分类回归常用的损失和优化器

Softmax:将模型的输出转换为概率分布。交叉熵损失:计算真实标签与预测概率分布之间的差距。为什么要用交叉熵呢?因为交叉熵可以来衡量预测差距,这个我们只需要这个知识点,并且知道上面的公式就好了。我们逐步分析这两个步骤。y_hat是模型的原始输出(logits),表示每个类别的“分数”。会自动处理 softmax 和交叉熵损失的计算。损失函数的目的是衡量模型的输出与真实标签之间的差异,差异越小,损