简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

有关支持哪些 csv 参数的更多信息,请参阅 csv 模块文档python复制代码 loader = CSVLoader(file_path='./example_data/mlb_teams_2012.csv', csv_args={})本文主要介绍了 langchain 中已经提供的文本加载器txtcsvpdfmarkdownhtmljson,以及基本的使用方式和使用场景。这些不同类型的文本加

LLMs 被视为 AI 领域的一个里程碑式的突破,但要将其应用于实际生产环境,并且还能用对、用好并非易事。模型的使用成本和响应延迟是目前将大语言模型(LLMs)应用于生产环境中的核心难题之一。在本期刊载的这篇文章中,作者从自身项目的实践经验出发,分享了一系列实用技巧,帮助优化 LLM Prompt ,能够一定程度上降低大模型的使用成本和响应延迟。文章首先解析了导致高成本和高延迟的根源在于输入输出

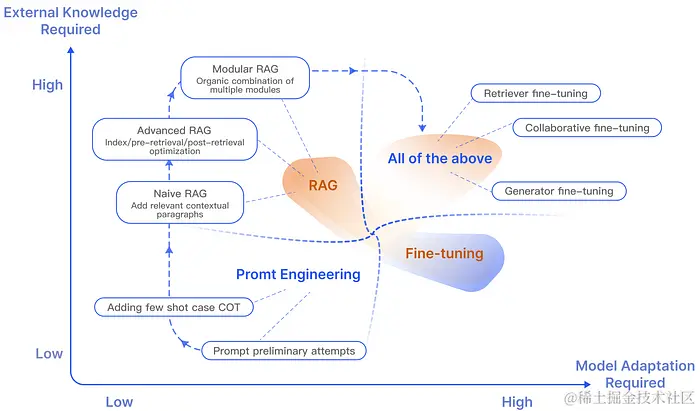

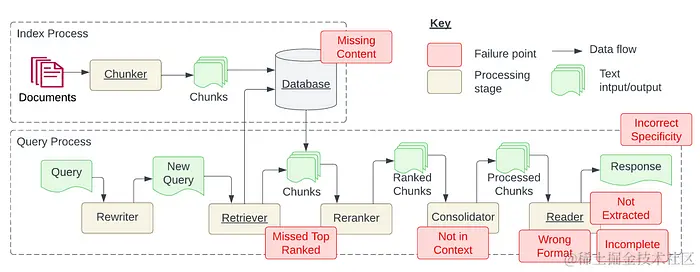

本文探讨了使用RAG技术时可能面临的七大挑战,并针对每个挑战提出了具体的优化方案,以提升系统准确性和用户体验。缺失内容:解决方案包括数据清理和提示工程,确保输入数据的质量并引导模型更准确地回答问题。未识别出的最高排名:可通过调整检索参数和优化文件排序来解决,以确保向用户呈现最相关的信息。背景不足:扩大处理范围和调整检索策略至关重要,以包含更广泛的相关信息。格式错误:可以通过改进提示、使用输出解析器

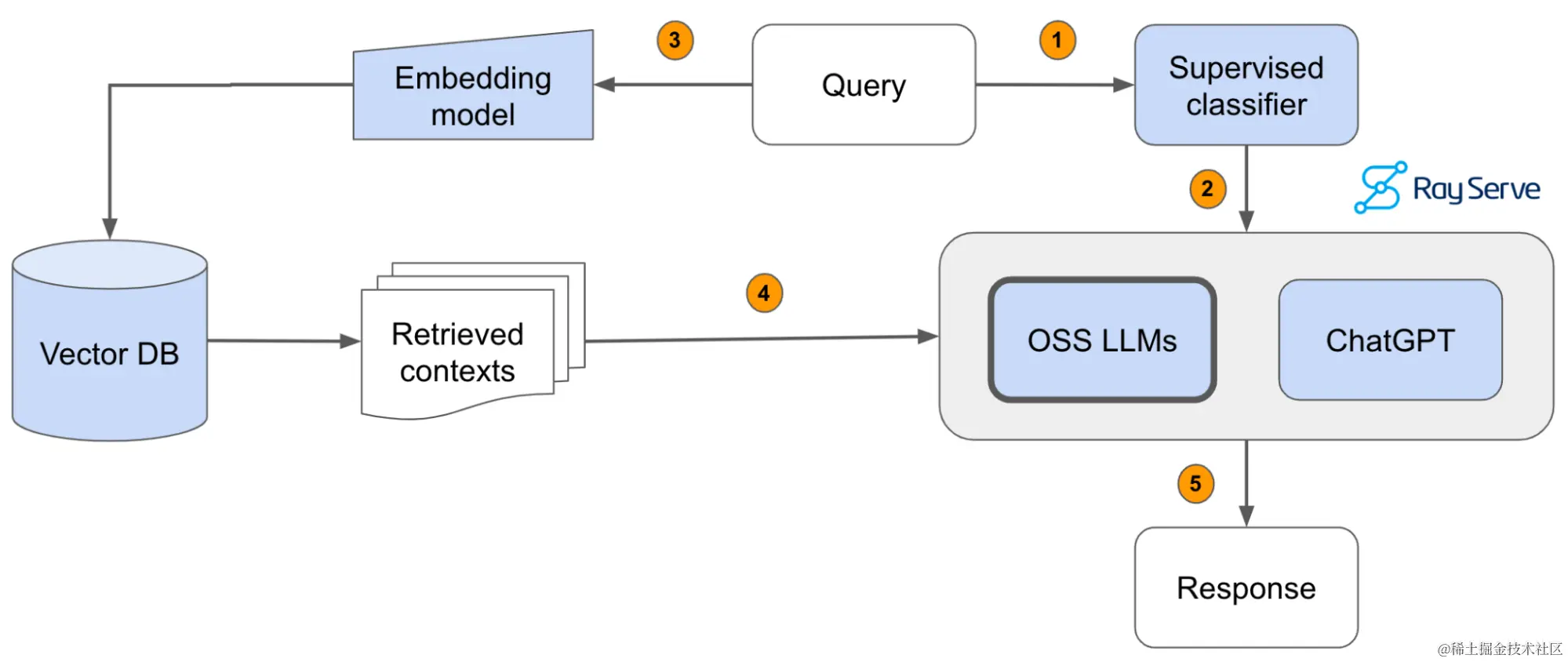

根据用户查询的意图在RAG应用程序内路由控制流可以帮助我们创建更有用、更强大的基于检索增强生成 (RAG) 的应用程序。我们希望用户能够交互的数据很可能来自各种来源,例如报告、文档、图像、数据库和第三方系统。对于基于业务的RAG应用程序,我们可能希望使用户能够与来自业务中一系列领域的信息进行交互,例如来自销售、订购和会计系统的信息。由于数据源的多样性,信息存储的方式以及我们想要与之交互的方式也可能

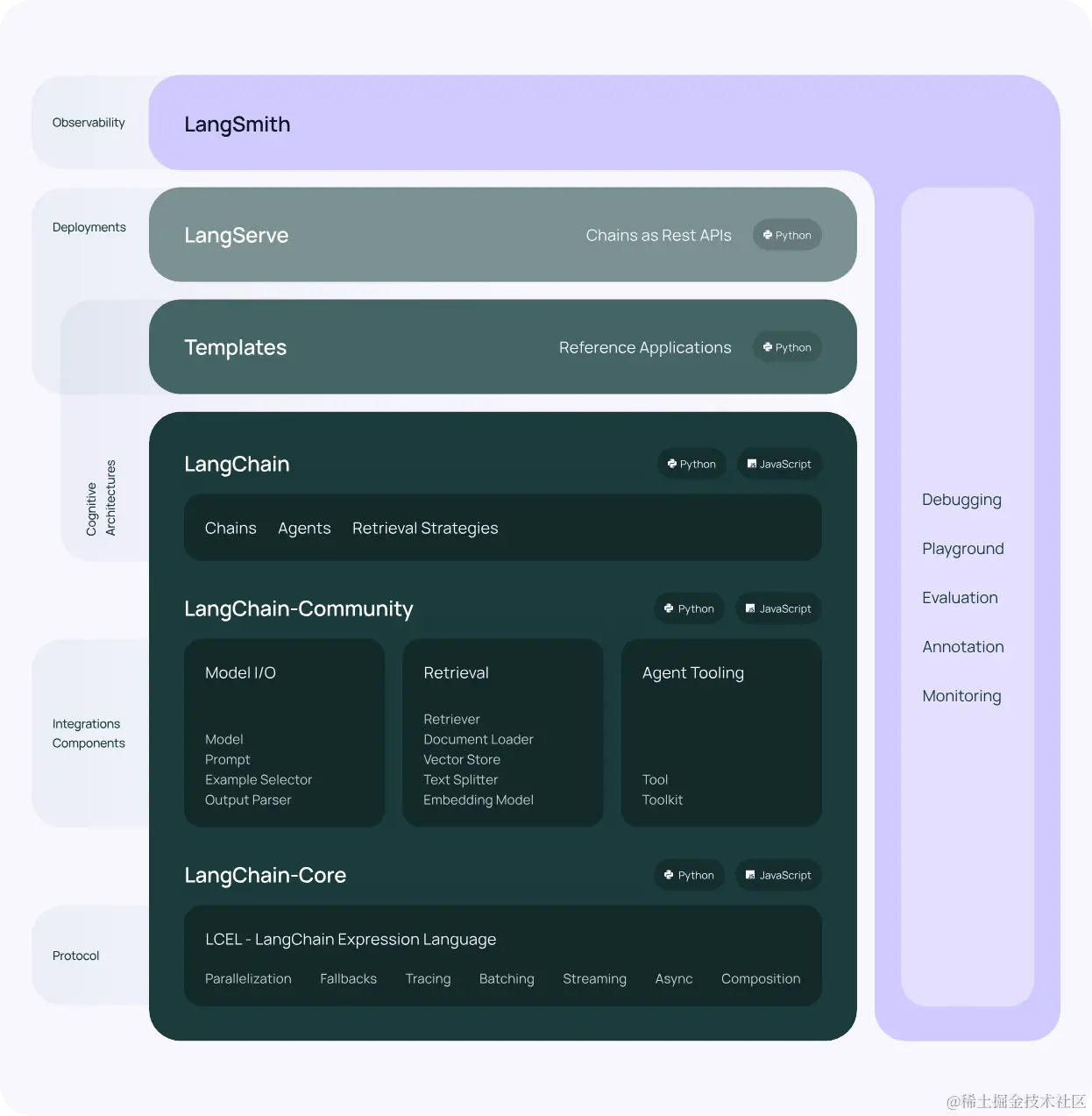

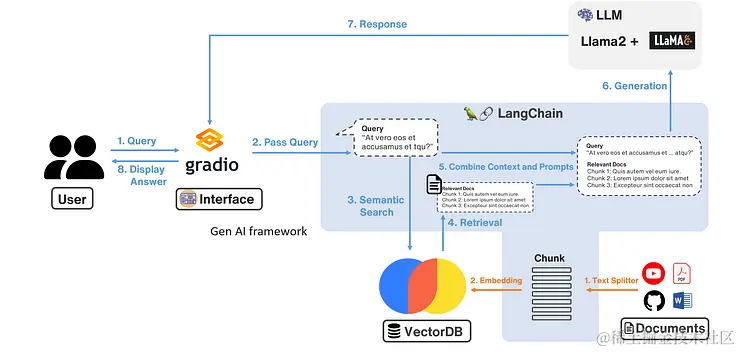

本文将逐步指导您创建自己的RAG(检索增强生成)系统,使您能够上传自己的PDF文件并向LLM询问有关PDF的信息。本教程侧重于图中蓝色部分,即暂时不涉及Gradio(想了解已接入Gradio的,请参考官网)。Llama2ChromaDB核心在于Langchain,它是用于开发由语言模型支持的应用程序的框架。LangChain就像胶水一样,有各种接口可以连接LLM模型与其他工具和数据源,不过现在La

本文深入探讨了如何通过优化动态上下文信息(Dynamic Context)来提升 AI Agents 的工作效率和准确性。文章首先概述了五种常见的技术策略,包括信息标识(Message Labeling)、针对不同需求设定不同上下文、优化系统提示词(System Prompts)、精简 RAG 系统中冗余信息,以及其他处理上下文的高级策略。

什么是promptLangchain 中 构建。使用 langchain 构建消息类型。prompt 选择器的类型,以及为什么需要选择器。读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用如果你是零基础小白,想快速入门大模型是可以考虑的。一方面是学习时间相对较短,学习内容更全面更集中。二方面是可以根据这些资料规划好学习计划和方向。

RAG是的缩写,翻译为中文的意思就检索增强,以基于最新,最准确的数据建立LLM的语料知识库。LLMLangChain是一个用于开发由语言模型驱动的应用程序的框架。具有上下文感知能力:将语言模型与上下文源(提示说明、少量镜头示例、基于其响应的内容等)联系起来。原因:依靠语言模型进行推理(关于如何根据提供的上下文回答,采取什么行动等)py复制代码 import osos.environ["QIANFA

如果我们要使用自定义索引,请在index_type参数中指定特定索引类型。ini复制代码 index_params = client.create_index_params() # 准备一个 IndexParams 对象field_name="scalar_2", # 标量字段名称index_type="INVERTED", # 明确索引类型index_name="inverted_index"

本文主要是 Milvus 向量数据实战总结。LLM 痛点以及解决方案RAG 是什么,为什么选用RAG。langchain文档加载器,chat model文档拆分的注意点,chat model区别。chat 示例代码。