简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

规模较大的培训机构通常具有更多的教学资源和更丰富的教学经验,而规模较小的培训机构可能会更加注重个性化的教学和服务。综上所述,选择一家靠谱的线下嵌入式培训机构需要综合考虑机构的行业口碑、师资力量、培训课程、学习环境和机构规模等方面。通过对这些方面的综合评估和比较,可以选择到适合自己需求的培训机构,从而获得更高质量的培训和学习体验。优秀的师资力量可以带来更高质量的教学和学习体验。在选择培训机构时,应该

嵌入式作为一种广泛应用于企业级开发的编程语言,对于想要从事软件开发行业的人来说,掌握嵌入式技能是非常重要的。要明确的是,参加嵌入式培训并不等于就业。因此,在选择嵌入式培训机构时,需要考虑机构的行业口碑、师资力量、培训课程、培训模式、学习环境、机构规模等方面。因此,在选择培训机构时,需要深入调研,多方考察,确保自己的学习投入得到有效的回报。一家靠谱的嵌入式培训机构应该有完整的课程体系,能够覆盖嵌入式

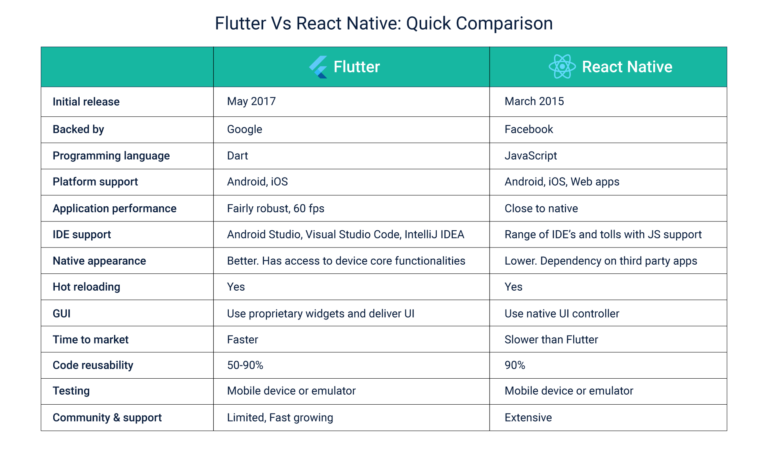

跨平台程序员之间关于 React Native 和 Flutter 的旷日持久的争论越来越白热化了。前几年,React Native 还是开发人员的首选框架,但是自 2017 年 Flutter 发布以来,其已经发展成为 React Native 的一个强有力竞争对手。最近,随着许多初创公司选择了 Flutter 用于 MVP 开发,React Native 正在面临来自 Flutter 的激烈竞

小伙伴在选择大数据培训机构的过程中,首先要去考察了解培训课程内容是否是符合企业的发展需求,是否是与时俱进的,掌握比较新颖的技术点是满足时下企业的用人需求。而小伙伴想要了解一家大数据培训机构所提供的培训课程体系是否新颖,可以先去了解企业对大数据开发技术的需求点是什么,然后对比大数据培训机构的课程内容是否符合市场需求。大数据开发技术所包含的编程技术知识点比较多,所以小伙伴在选择大数据培训机构的时候,要

Spark闭包里的执行器代码可以使用累加器的 += 方法(在Java中是 add)增加累加器的值。驱动器程序可以调用累加器的value属性(在Java中使用value()或setValue())来访问累加器的值。累加器用来对信息进行聚合,通常在向 Spark传递函数时,比如使用 map() 函数或者用 filter() 传条件时,可以使用驱动器程序中定义的变量,但是集群中运行的每个任务都会得到这些

2.创建sequenceFile格式的表,插入数据时报错。1.创建parquet格式的表并插入数据进行查询。注:impala不支持ORC格式。

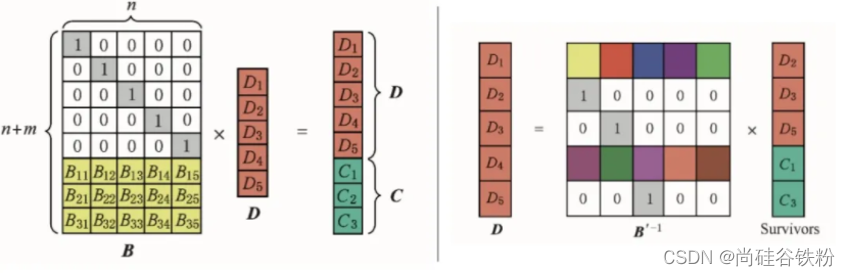

另外,如果让client端直接写一个连续布局文件需要缓存下足够的数据块,然后生成校验块并写入,以RS(6,3),blockSize=128M为例,client端需要缓存1.12G的数据,这点决定了连续布局的文件更适合由普通文件转化而来,而条形布局就不存在上述缺点。在条形布局下,数据被依次写入条的各个单元中,当条被写满之后就写入下一个条,一个条的不同单元位于不同的数据块中。RS码在使用的时候需指定2

数据清洗, 是整个数据分析过程中不可缺少的一个环节,其结果质量直接关系到模型效果和最终结论。在实际操作中,数据清洗通常会占据分析过程的50%—80%的时间。国外有些学术机构会专门研究如何做数据清洗,相关的书籍也不少。我将在这篇文章中,尝试非常浅层次的梳理一下数据清洗过程,供各位参考。照例,先上图:预处理阶段预处理阶段主要做两件事情:一是将数据导入处理工具。通常来说,建议使用数据库,单机跑数搭建My

开发者易于配置Quarkus不是即插即用技术,但不需要很复杂就可以配置并快速应用。该平台提供实时编码功能,开发者可以立即查看代码更改后的影响、实时修复Bug。在设置Quarkus时,开发人员可以为可以在JVM模式下运行,也可以在本机模式下编译并运行的应用程序,选择自己喜欢的Java框架。Quarkus基于著名的Java库,团阶是经验丰富的Java开发者,沉淀了二十多年的标准,事实上也说明了Java

一、背景在网站平台类业务需求中用户的「最大登陆天数」,需求比较普遍。原始数据:u0001 2019-10-10u0001 2019-10-11u0001 2019-10-12u0001 2019-10-14u0001 2019-10-15u0001 2019-10-17u0001 2019-10-18u0001 2019-10-19u0001 2019-10-20u0002 2019-10-20说