简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

DeepSeek(深度求索)是一家聚焦实现AGI的中国的人工智能公司,致力于通过突破性的技术研究让人类未来更美好。秉承“智慧求真,科技向善”的愿景,DeepSeek将持续探索大模型的技术边界,以创新驱动产业变革,让AGI技术真正赋能人类社会。Deepseek通过算法-软件-硬件的协同创新打破英伟达cuda护城河,通过技术开源推动多元硬件生态的成熟,为更低成本的构建本地大模型贡献了力量。

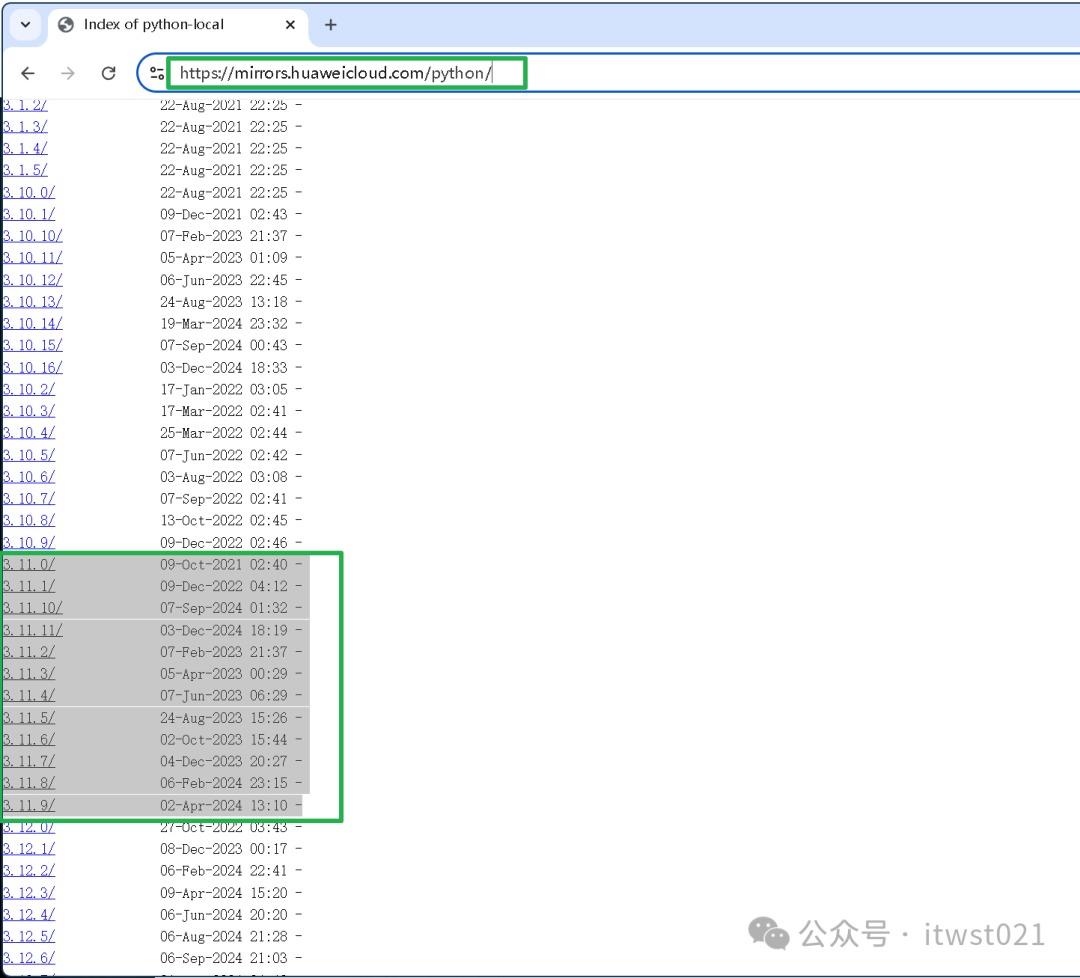

网上现在很多的分享文章,都是基于容器化快速的安装部署来使用 DeepSeek-r1 大模型的,对于没有接触过容器化相关知识的朋友们来说,那安装部署使用就不是很方便,今天就分享介绍两款本地简单安装的 Web-UI 界面的客户端,就能使用上本地 DeepSeek-r1 大模型了。

Base LLM与Instruction-Tuned LLM不是对立的技术路线,而是AI进化的两个必要阶段。理解它们的差异与协作方式,就像掌握了“原材料”与“成熟产品”的关系。

近年来,随着深度学习技术的飞速发展,大型神经网络模型如BERT、GPT-3等已经成为自然语言处理、计算机视觉、语音识别等领域的重要工具。这些模型之所以称为"大型",是因为它们通常包含数十亿甚至数千亿的参数,比以往的模型要庞大得多。然而,模型的规模庞大并不总是意味着性能更好,因此我们需要一套有效的方法来评估这些大型神经网络的性能。本文将探讨为什么要评估大型神经网络模型,以及如何使用一系列关键指标来评

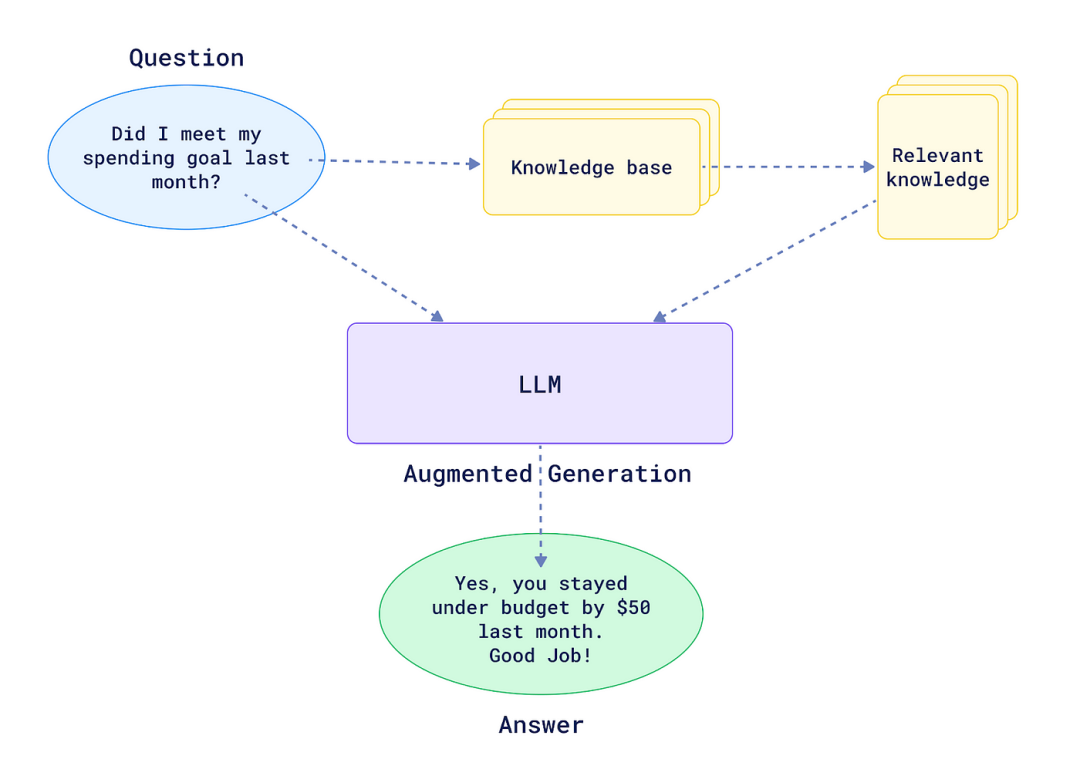

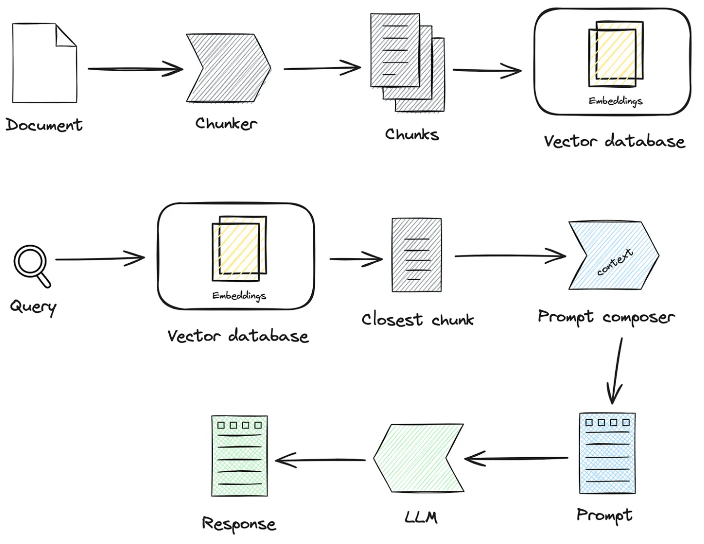

RAG 框架的世界多种多样,发展迅速,我们探讨的十个框架都具有独特的优势和功能。

2. RAG流程优化RAG流程的优化我们又分为了静态文档的RAG和动态数据获取的RAG,目前大部分涉及到的RAG只覆盖了非结构化的文档静态资产,但是实际业务很多场景的问答是通过工具获取动态数据 + 静态知识数据共同回答的场景,不仅需要检索到静态的知识,同时需要RAG检索到工具资产库里面工具信息并执行获取动态数据。(1) 工具资产库构建企业领域工具资产库,将散落到各个平台的工具API,工具脚本进行整

我们按照下图的数据介绍组件。• ragflow的的官方文档相对来说还是比较欠缺的,特别是用户交互这块。• ragflow的ui使用成本相对比较高,组件不知道返回什么,只能根据示例或意图推断• 使用ragflow建议是有技术底子的• 英文文档的描述习惯和中文还是有很大的差别的说实话,用着有点崩溃,哈哈。

这个文件用于设置 GRUB 引导加载器的参数,确保在系统启动时禁用 IPv6。必须先处理上面的两个配置文件,最后才配置GRUB,否则会导致无法禁用ipv6。通过Ollama、AnythingLLM和Weaviate的有机结合,DeepSeek知识库架构不仅提升了知识管理的智能化水平,还有效优化了信息检索的速度和准确性。Ollama为架构提供了本地化、可定制的AI推理平台,AnythingLLM增强

定期总结学习成果,撰写博客、发表文章或分享经验,不仅可以加深对知识的理解,还能提升个人的行业影响力。通过不断输出高质量的内容,你可以在AI领域建立起自己的品牌,吸引更多机会。

并要求简单介绍了一下实习经历,因为我的实习经历大多是to c的,所以他也没太自习挖掘实习经历,问的比较多的是如何处理后台数据,在实习中学到了什么。然后就问了一些基本问题,