简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

说明本地服务器一般用http://localhost:8080 来访问,只能通过本地自己访问。别人可以访问链接么,正常情况下是不可以的,防火墙等等限制。本文的主角ngrok 就是救场的英雄。可以映射到本地机器来访问,可以通过http,也可以通过https.用法详细可以通过官网链接设置,笔者也把步骤罗列一下。笔者为Mac OS.https://dashboard.ngrok.com/get-star

1. 如何判断新的巨头在哪里?产业选择:必须有大算力的产业,比如AI平台。技术优势:要有算法,数据带来的巨大优势,软硬件结合。协作能力:必须是一个开放的平台,不断演化。异构计算(英语:Heterogeneous computing),又译异质运算,主要是指使用不同类型指令集和体系架构的计算单元组成系统的计算方式。常见的计算单元类别包括CPU、GPU等协处理器、DSP、ASIC、FPGA等。异构计算

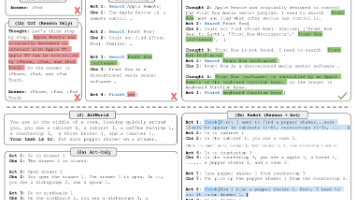

本文提出了一种名为ReAct的新方法,通过协同大型语言模型(LLM)的推理能力和交互式决策能力来提升任务解决效果。ReAct采用交错生成推理轨迹和具体操作的方式,使两者相互促进:推理轨迹帮助模型制定、跟踪和调整行动计划,而操作则允许模型与外部环境交互获取信息。实验表明,在HotpotQA问答和Fever事实验证任务中,ReAct通过与维基百科API交互克服了思维链推理中的幻觉问题;在ALFWorl

ReferencesTensorFlow Recommenders homepagehttps://www.tensorflow.org/recommendersTensorFlow Recommenders repository on GitHubhttps://github.com/tensorflow/recommendersBuilding a retrieval model using

非常感谢你 Pieter 今天来参加访谈 我想很多人觉得你是一个 知名的机器学习 深度学习 和机器人学研究者 我希望能让观众们听一听你的故事 你是如何最终走上了现在的道路的呢?这是个好问题 其实如果你问14岁的我这个问题 我要立志做什么 问题的答案大概不会是这些 实际上 在当时 我认为成为一名专业篮球运动员应该不错 但我觉得没有能力实现那个目标 我感觉 对机器学习来说这是一件幸事 因为篮球的打算没

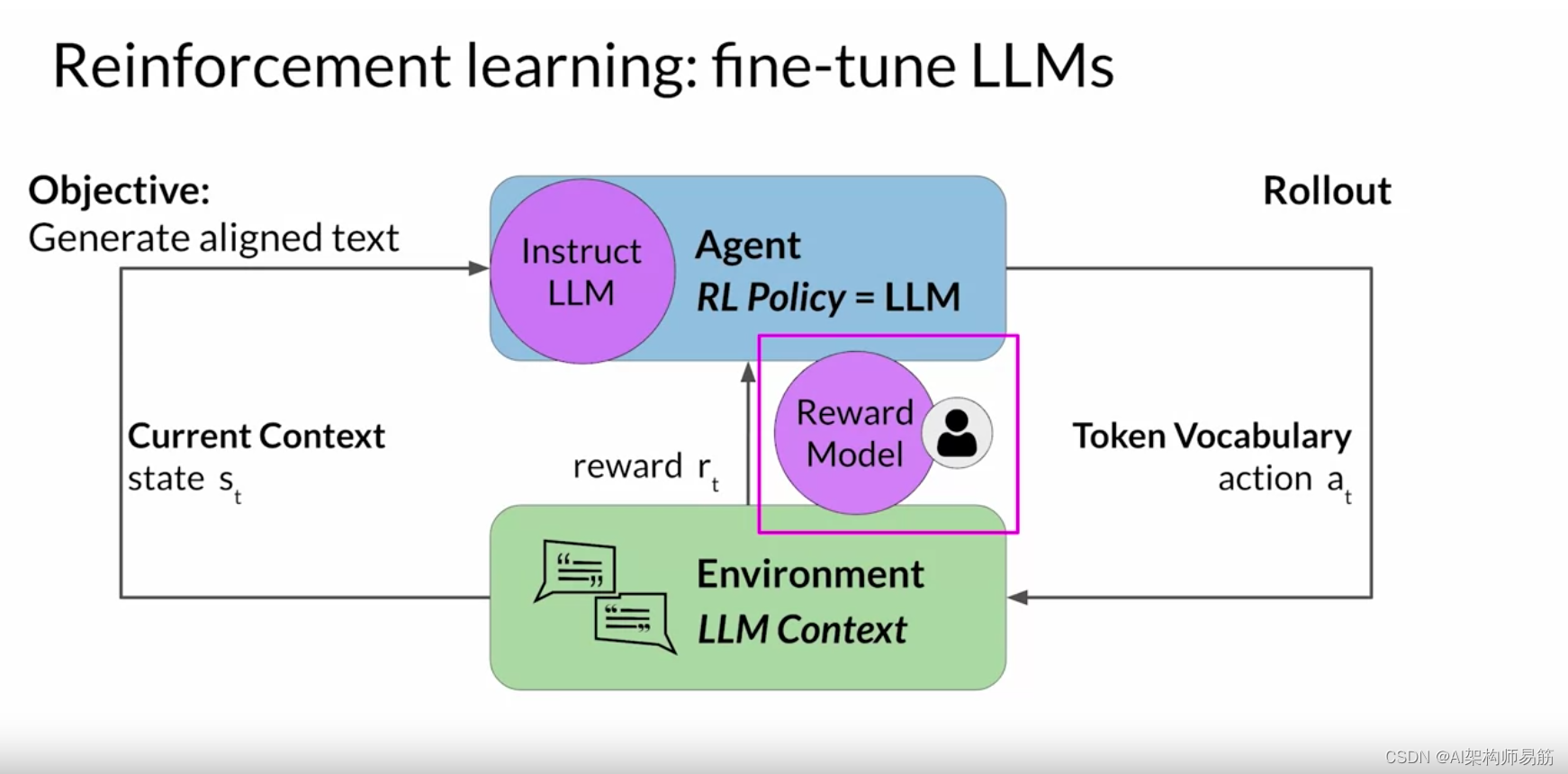

让我们考虑一下文本摘要的任务, 即使用模型生成一段简短的文本,捕捉 较长的文章中最重要的观点。您的目标是通过向模型 展示人工生成的摘要示例,使用微调来提高模型的总结能力。2020年,OpenAI的研究人员发表了一篇论文,探讨了使用 人工反馈进行微调来训练模型撰写文本文章的简短摘要。在这里,你可以看到,与 预训练模型、 指令微调模型甚至参考人类基线相比,根据人类反馈进行微调的模型产生的响应效果更好。

卷积审计网络 看书太复杂,被劝退的概率太高。1. 卷积 – 用吃饭消化 来理解卷积函数 f(t)g(x-t)卷积:不稳定输入,稳定输出,求系统存量卷积就是把g(x) 函数翻转了,因为翻转了,所以叫做卷积2. 卷积神经网络 的主要功能是识别图片里面的内容,比如图片是猫是狗周围像素点如何对当前的点产生影响图像的卷积操作f(t) = 不稳定输入g(x-t) = 稳定输出电脑里面的图片都可以看作是一个一个

案例:跨境电商如何用ChatGFT选品ChatGPT+素材和资料来自:Jungle ScoutEM, Michael Soltis 和 文韬武韬AIGC。

1. 自注意力 self attention2. 自注意力 self attention 代码实现3. Transformer4. 多头注意力代码5. Transformer 代码6.Q&Atransformer 特别适合应用到芯片上。参考https://www.bilibili.com/video/BV19o4y1m7mo?p=1...

Large Language Model(大型语言模型)是指具有大规模参数数量和处理能力的语言模型。这些模型通过深度学习技术训练,能够处理和生成自然语言文本。大型语言模型在自然语言处理领域发挥着重要作用,它们能够理解和生成文本,执行语言相关的任务,如机器翻译、文本摘要、情感分析、对话系统等。这些模型的训练基于大量的文本数据集,使其能够学习语言的结构、语法、语义和上下文相关性。近年来,随着技术的发展