简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

资源隔离:为每个推理实例分配独立GPU,避免多租户干扰预热策略:启动时预加载模型到GPU显存,减少首请求延迟自动伸缩:基于HPA实现动态扩缩容,CPU利用率阈值设为70%备份机制:定期将检查点保存至对象存储(如MinIO)通过上述方案,可在K8s环境实现Deepseek-R1的稳定运行,实测QPS可达120(batch_size=32时),端到端延迟控制在1.2秒以内。建议每两周进行一次模型热更新

语言模型」是一种「人工智能系统」,旨在处理、理解和生成类似人类的语言。它们从大型数据集中学习模式和结构,使得能够产生连贯且上下文相关的文本,应用于翻译、摘要、聊天机器人和内容生成等领域。图片。

使用TensorRT进行加速推理时,需要先将onnx格式转化为tensorrt格式,以下是使用C++来进行转化代码以及对应的CMakeLists.txt文件。本文主要为大家详细介绍了如何使用C++将yolov8 onnx格式转化为tensorrt格式,文中的示例代码讲解详细,感兴趣的小伙伴可以了解一下。以yolov8为例,使用cmake编译好后会生成build可执行文件,执行以下命令即可等待生成y

输入你的Google帐号和密码,让MCP Server借助你的Google授权来对MCP客户端进行认证,并允许后续的资源访问。需要再次说明的是,这里我们直接使用Google颁发的token作为访问MCP资源的凭证,- 验证访问令牌的有效性,检查令牌是否存在、是否过期,这个方法在每次API请求时被调用,也正是该接口保证了后续MCP Server访问的安全性。,如典型的使用MCP Server扩展LL

对于yolov8的模型,要加速的话,首先要进行模型转换,从onnx转换为tensorrt。本文推理主要使用Tensorrt的C++的Api,实现推理加速。

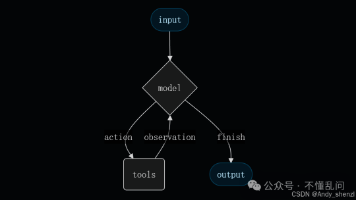

LangChain 在 1.0 版本中,将所有 Agent 的创建方式统一为了一个入口——create_agent()。它取代了旧版本中的 create_react_agent、create_json_agent、create_tool_calling_agent 等多种分支函数,真正让开发者用一行代码即可创建任何类型的智能体。在 LangChain 0.x 时代,框架内的 Agent 系统经历了

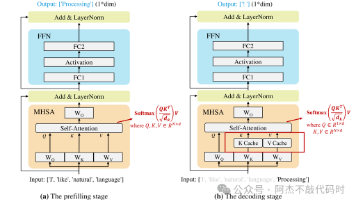

大语言模型 (LLM) 因其在各种任务中的卓越表现而备受关注。然而大语言模型的部署推理并不简单,尤其是针对在给定资源受限场景下,巨大的计算和内存需求给LLM推理部署带来了挑战,具体如:高延迟、低吞吐、高存储等。

deepseek最近引起了NLP领域的极大关注,也让大家进一步对MOE架构提起了信心,借此机会整理下MOE的简单知识和对应的大模型。本文的思路是MOE的起源介绍、原理解释、再到现有MOE大模型的整理。

在现实世界中,团队可能需要处理并非整齐地排列成行和列的数据。当处理照片、视频和自然语言等复杂的非结构化数据时,这种情况尤为常见。这时,矢量数据库就派上用场了。哪个矢量数据库最适合您的项目?目前市场上领先的矢量数据库有哪些?深入了解我们对市场上 17 个最流行的矢量数据库的概述,了解您的选择并为您的项目挑选最佳工具。要点总结什么是向量数据库?几年前首次出现,旨在为基于神经网络的新一代搜索引擎提供支持

技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。开源了六种大小的基础和聊天模型,即0.5B、1.8B、4B、7B、14B、32B、72B 和 110B,以及 MoE 模型(64个expert)开源了0.5B、1.5B、7B、57B-A14B(共57B但激活14B