简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

💥💥💞💞❤️❤️💥💥博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。⛳️行百里者,半于九十。📋📋📋🎁🎁🎁。

随着全球能源结构转型和智能电网技术发展,能源市场呈现高度动态化与不确定性特征。传统基于规则的交易策略难以适应复杂市场环境,而Q-learning算法凭借其无模型学习、动态适应性和鲁棒性优势,成为优化能源交易决策的重要工具。本文系统阐述Q-learning算法原理,构建面向能源市场的马尔可夫决策过程(MDP)模型,通过仿真实验验证其在电力交易、微电网运营等场景中的效益优化能力,并提出深度强化学习、多

文献来源:为满足“低碳”能源结构的要求,数量庞大的分布式能源接入电网呈规模化趋势,其波动性和随机性给电网的运行安全带来了巨大挑战[1-3]。为应对挑战,微电网作为新兴的电网业态可灵活地进行分布式能源管理,而储能系统在其中起到储存电能、削峰填谷、应急供电等重要作用[4-6]。但在低温环境下,储能系统中起核心作用的电池却常出现充放电效率下降、寿命衰减速率增大等问题[7-8],高速率的电池老化除了增加如

本文研究了离散时间非线性多智能体系统在切换通信拓扑下的共识问题,并采用模型预测控制(MPC)方法进行求解。对于遵循马尔可夫切换规律的系统,现有的MPC解决方案难以基于模型预测获得可靠的优化结果。为此,我们提出了一种新的基于神经网络的算法,通过实时近似和最小化MPC的成本函数,降低通信不足带来的影响。通过不同应用和场景的仿真验证了所提方法的有效性。

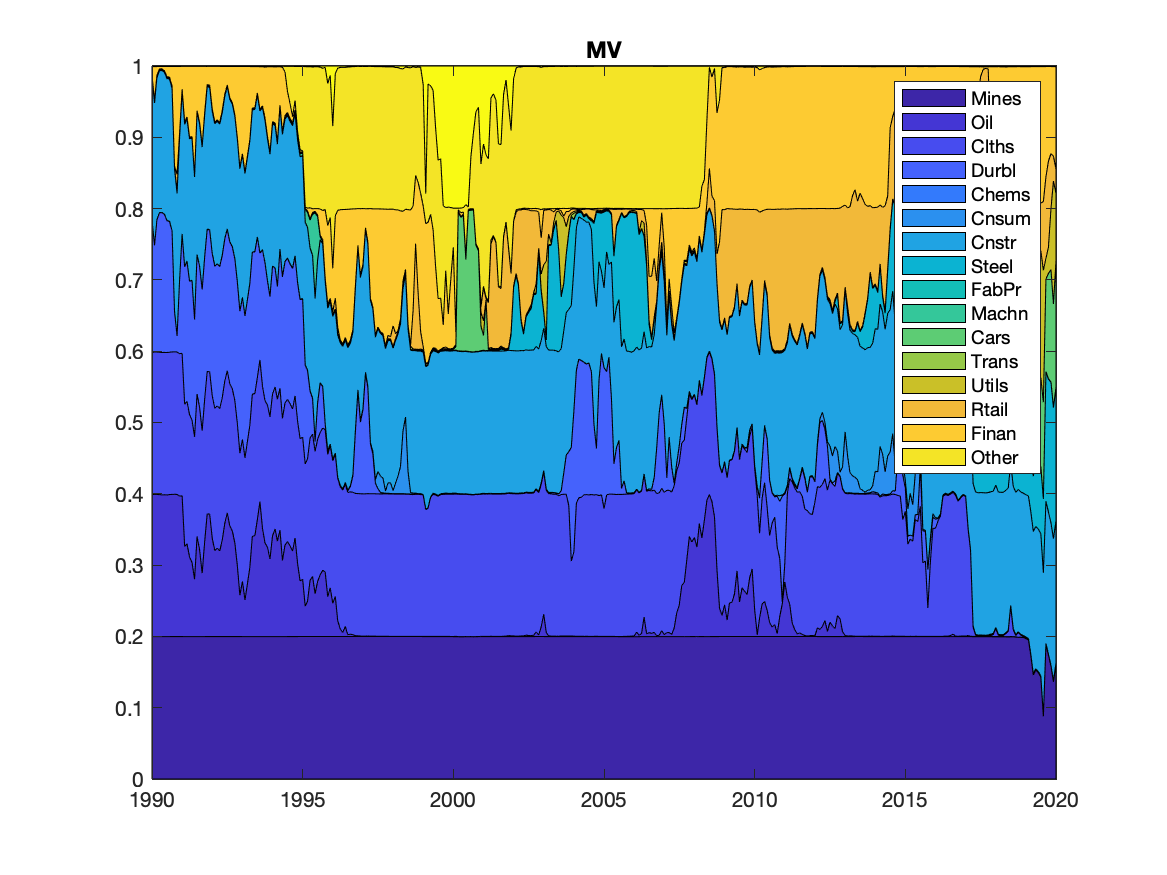

我们的研究基于 Pavlo Krokhmal、Jonas Palmquist 和 Stanislav Uryasev 的论文《Portfolio optimization with conditional Value-at-Risk objective and constraints》。因此,我们遵循了他们关于优化条件风险价值(CVaR)以在回报和对大幅下跌(或潜在损失)的保护之间取得最佳投资组合

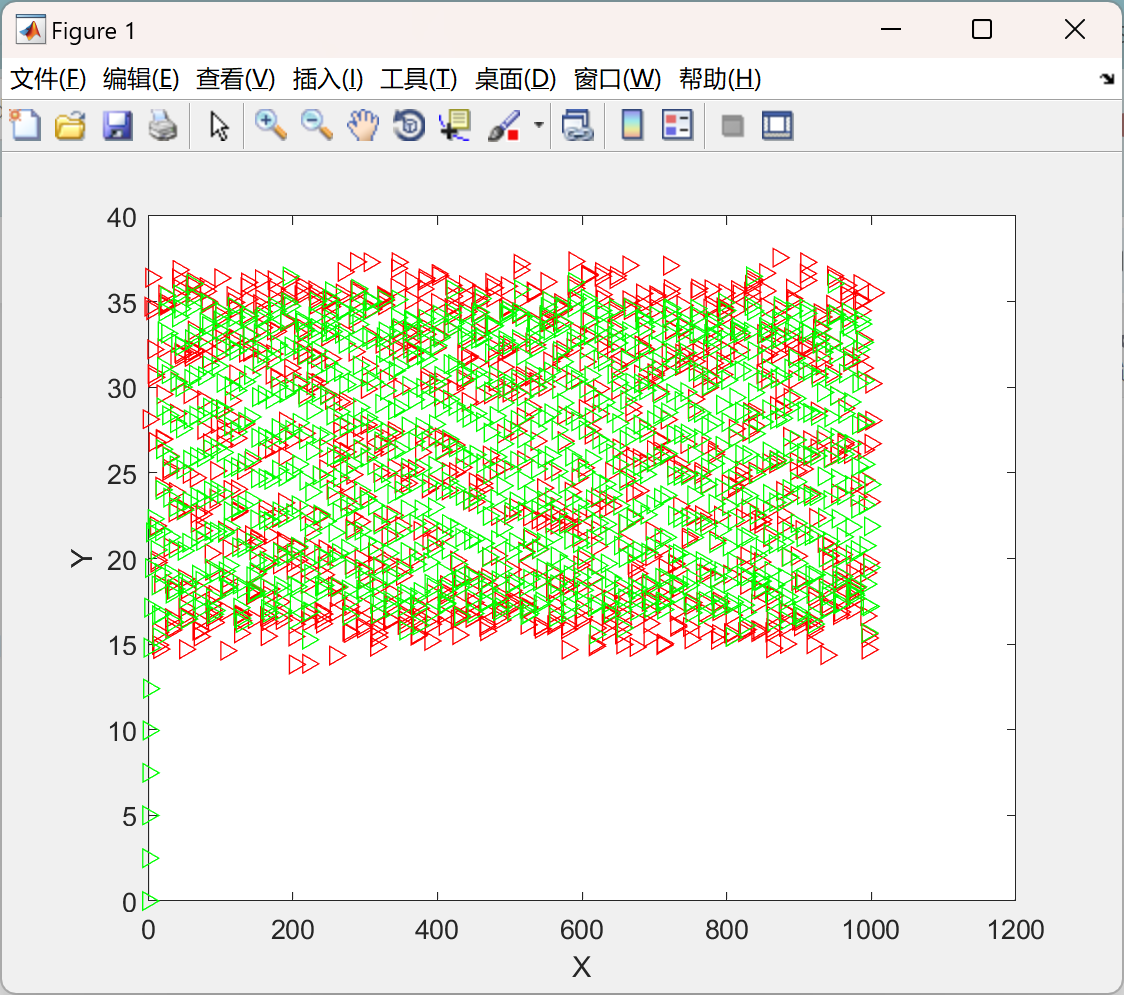

人工势场法作为一种常用的路径规划方法,具有计算简单、实时性好等优点,在移动机器人路径规划中得到了广泛的应用。- **混合策略**: 将人工势场法与其他路径规划算法(如A*算法、Dijkstra算法等)结合,增强解决局部极小值问题的能力。- **在线学习**: 通过机器学习的方法自适应调整势场参数,提高在复杂环境中的适应能力。1. **计算效率高**: 由于只需要计算力的大小和方向,算法简单快速,适

优势:DDPG通过端到端学习连续控制策略,避免了传统方法对精确模型的依赖,在非线性、高维状态空间中表现优异。其在倾转旋翼无人机中的应用已覆盖姿态控制、路径规划与多模态过渡等场景。挑战训练效率:复杂动力学下的样本需求量大,可结合优先级经验回放(PER)加速收敛。鲁棒性提升:引入TD3(双延迟DDPG)抑制Q值高估,或结合模型预测控制(MPC)增强抗干扰能力。硬件部署:需优化算法实时性,适配嵌入式飞控

飞机电力系统 (EPS) 是安全关键系统,可为起落架或飞行控制执行器等重要负载提供电力。随着一些液压、气动和机械部件被电气部件取代,现代飞机 EPS 变得越来越复杂,因为硬件子系统数量更多以及它们与嵌入式控制软件的交互 [1]。电力系统的电气化允许实施智能控制技术,通过对电力资源的优化管理来实现更高的性能和整体效率。然而,今天的 EPS 设计主要遵循顺序衍生设计过程,其估计早期设计决策对最终实施的

DQN是一种结合了深度学习和Q-learning的强化学习算法。它通过神经网络来近似Q函数(状态-动作值函数),从而能够在高维状态空间中有效地进行决策。DQN算法的核心思想是利用神经网络来估计每个动作的价值,并根据价值选择最优动作。状态:无人机的当前位置、速度、姿态以及周围环境的感知信息(如障碍物位置、禁飞区等)共同构成无人机的当前状态。动作:无人机可以采取的动作包括改变飞行方向、调整飞行高度、加

💥💥💞💞❤️❤️💥💥博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。⛳️行百里者,半于九十。📋📋📋🎁🎁🎁。