简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文总结了作者在腾讯、阿里、百度等公司的大模型算法岗面试经历。面试内容涵盖了大模型的基础知识、结构差异、位置编码、预训练与推理、RLHF(包括PPO和DPO的区别)、超长上下文处理、智能体组件等。此外,还涉及了数据清洗、模型幻觉、复读问题、工具调用等实际应用问题。面试官注重考察候选人的基础知识、项目经验、问题解决能力以及对大模型技术的深入理解。整体面试体验良好,面试官专业且愿意深入探讨,面试难度适

最近这一两周不少大厂都已经开始秋招面试了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。今天分享我们一星球成员面试 minimax 大模型岗一面、二面面经。面试题涉及项目、论文、八股都会问到,难度中规中矩,想找大模型方向的同学可以了解下,有什么问题欢迎评论区交流后续我会继续分享同学们的面试经验,希望能够帮助大家拿下满意的 offer 这份《AI

大部分常用的 Python 库,在定义插件时都可以直接导入(比如 json,time,random)。其他一些必要的模块(比如 requests,datetime等),还可以从左侧的依赖包中添加,这就给了插件模块比代码模块高了几个维度的灵活性。

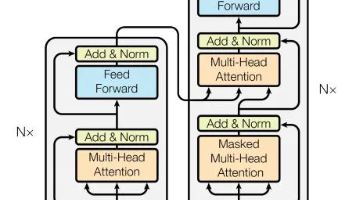

Transformer架构最初由谷歌研究人员于2017年在论文《注意力就是你所需要的一切》("Attention Is All You Need")中提出。这一架构的诞生标志着自然语言处理领域的一次重大突破,因为它彻底颠覆了传统的序列到序列学习模型的设计思路。在此之前,基于循环神经网络(RNN)的模型在机器翻译、语音识别等任务中占据主导地位,但RNN的串行处理方式使其计算效率低下,时间复杂度为O(

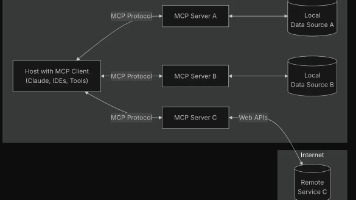

最近看到很多文章都在谈mcp,但是很多文章都会给人一种感觉——看了,也好像啥也没看。本质上还是没懂,今天我们一起来学习下啥是mcp,让我们在一个极短的时间内,以说人话的方式,快速吃透它,让它为您所用。

AI面试官可以根据简历迅速提出相关问题,甚至在某些方面进行追问,就像安踏体育用品集团有限公司的AI面试,以卡通形象出现,虽然声音机械化,但能快速评估面试者的各项能力。• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。:在AI面试之前,建

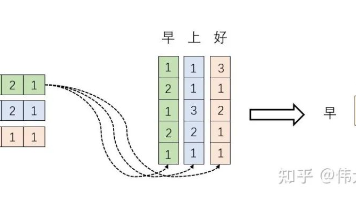

本文回顾了作者一年前初次接触Transformer模型时的困惑,特别是对Self-Attention机制的理解。作者通过重新阅读相关论文,深入探讨了Self-Attention的核心概念,包括QKV矩阵的作用、向量内积的几何意义以及矩阵运算的核心思想。文章详细解释了键值对注意力的公式,并通过实例展示了矩阵XXT的意义,即通过内积计算向量间的相关性。此外,作者还讨论了Softmax操作在注意力机制中

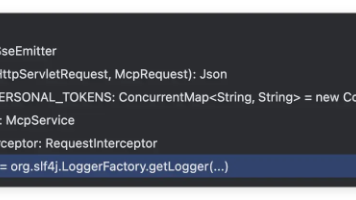

我们之前开发了一个SPMS的智能生产管理系统,其中包含了很多资源管理(ERP)库存管理(WMS)生产管理(MES)等功能,前段时间MCP在国内火了起来,我们也顺带的给这个开源管理系统加上了几个MCP工具的功能,可以参考之前我们发布的文章我们和目前主流的STDIO模式的MCP工具不一样,我们使用的是MCP的SSE/HTTP模式,所以本文不涉及STDIO模式的MCP的实现和内容。今天我们分享了在这个开

maxkb.cn/好了,基本就是这些啦,再推荐一本关于大模型的书,叫做《大模型导论》,希望AI时代,我们每个人都能找准自己的定位,利用好AI,增强自己,而不是被取代。最后再多说一句,大模型飞速发展,存在信息差是肯定的,如果你真的不了解AI,短期内也不想了解,就不要轻易相信那些在你面前扯各种AI概念的人,尤其是不熟的人,现在这方面的诈骗也挺多的,保护好自己。

Reinforcement Learning for all Scenarios,二次强化学习阶段,旨在提高模型的有用性和无害性,同时优化其推理能力,对于推理数据,用基于规则的奖励来指导数学、代码和逻辑推理领域的学习过程。deepseek 方案最重要的步骤是 DeepSeek-R1-Zero,用了一个 cot 的 prompt 模板,然后一堆基于规则的 reward 模型,强化学习用的 GRPO,