简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

MaxFrame 是基于云原生的分布式 Python 计算服务,支持 Python 编程接口,兼容 Pandas、XGboost 等数据处理及 ML 算子接口且自动实现分布式处理,同时能直接使用 MaxCompute 的弹性计算资源和数据接口,与 MaxCompute Notebook、镜像管理等功能共同构成了 MaxCompute 的 Python 开发生态。

阿里云向量检索 Milvus 版是一款 Serverless 全托管服务,确保了与开源 Milvus 的完全兼容性,并支持无缝迁移。它在开源版本的基础上增强了可扩展性,能提供大规模 AI 向量数据的相似性检索服务。凭借其开箱即用的特性、灵活的扩展能力和全链路监控告警,Milvus 云服务成为多样化 AI 应用场景的理想选择,包括多模态搜索、检索增强生成(RAG)、搜索推荐、内容风险识别等。您还可以

DLRover 采用运行时优化思想来对分布式训练作业进行自动扩缩容。DLRover 首先让训练作业跑起来, 然后监控训练作业所有节点的负载和整体训练性能,并根据监控指标来动态调整作业的资源,从而提升训练性能和资源利用率。

近期,Sora模型的热度持续上涨,社区中涌现了一些类Sora的开源项目,这些项目均基于Diffusion Transformer结构,,旨在生成更长、更高分辨率、且效果更好的视频。EasyAnimate是阿里云人工智能平台PAI自主研发的DiT-based视频生成框架,它提供了。在预训练模型的基础上,EasyAnimate可通过少量图片的LoRA微调来改变生成视频的风格,相比已有方案具有更好的扩展

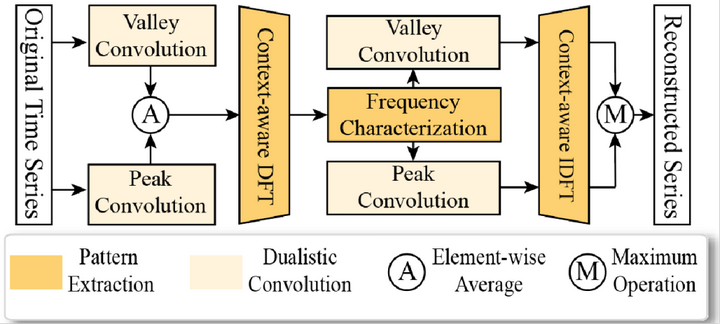

因此,我们可以根据当前数据样本与其对应的正常模式频域子空间的关系,令对于当前正常模式而言的正常数据重构误差远小于异常数据的重构误差,以此检测异常。更进一步,我们提出上下文感知的傅里叶变换和反变换机制,有效利用频域的稀疏性提升计算效率,在频域上不存在时序依赖,可以对该模型进行细粒度的高并发实现,进一步减少异常检测的时间开销。近来,基于重构类方法的异常检测模型独占鳌头,在无监督异常检测中达到了很高的准

这是一种面向命名实体识别的小样本学习算法,采用两阶段的训练方法,检测文本中最有可能是命名实体的Span,并且准确判断其实体类型,在仅需要标注极少训练数据的情况下,提升预训练语言模型在命名实体识别任务上的精度。

阿里云人工智能平台 PAI 提供了完整的模型微调产品能力,支持 监督微调(SFT)、偏好对齐(DPO)、强化学习微调(GRPO) 等业界常用模型微调训练方式。根据客户需求及代码能力层级,分别提供了 PAI-Model Gallery 一键微调、PAI-DSW Notebook 编程微调、PAI-DLC 容器化任务微调的全套产品功能。

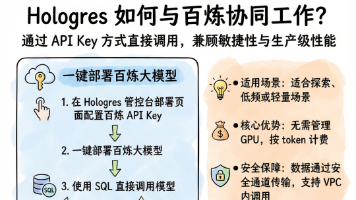

阿里云 Hologres 深度集成百炼大模型平台,推出 AI Function 能力——无需 Python,无需额外服务,用你熟悉的 SQL,直接调用大模型,实现从结构化数据到图片、PDF、视频的全模态智能分析。

检索增强生成模型结合了信息检索与生成式人工智能的优点,从而在特定场景下提供更为精准和相关的答案。以人工智能平台 PAI 为例,为您介绍在云上构建面向金融场景的大模型 RAG 检索增强解决方案。

阿里云向量检索 Milvus 版是一款 Serverless 全托管服务,确保了与开源 Milvus 的完全兼容性,并支持无缝迁移。它在开源版本的基础上增强了可扩展性,能提供大规模 AI 向量数据的相似性检索服务。凭借其开箱即用的特性、灵活的扩展能力和全链路监控告警,Milvus 云服务成为多样化 AI 应用场景的理想选择,包括多模态搜索、检索增强生成(RAG)、搜索推荐、内容风险识别等。您还可以