简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

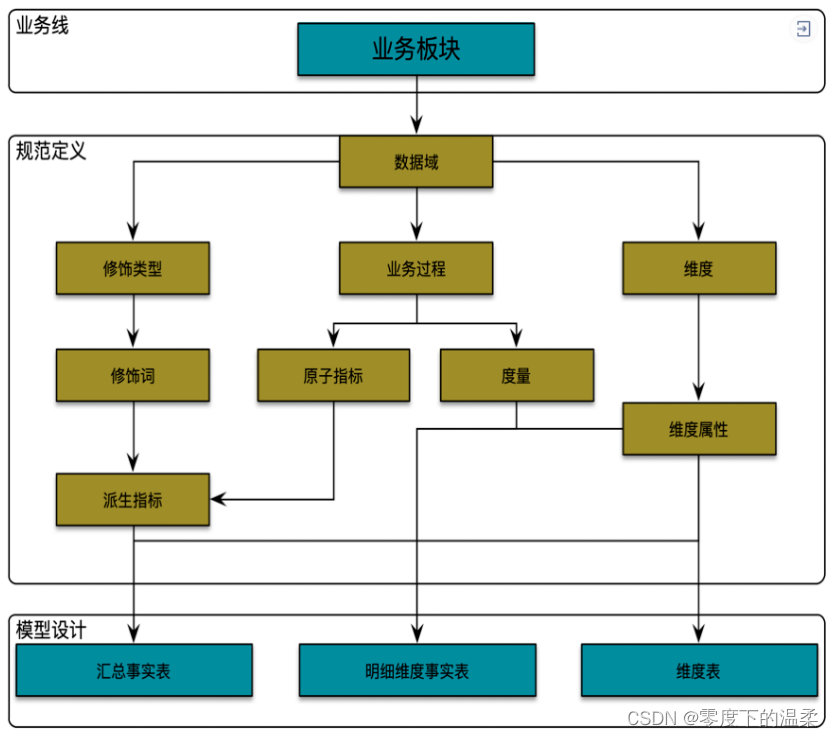

指标体系1. 痛点分析主要从业务、技术、产品三个视角来看:业务视角业务分析场景指标、维度不明确;频繁的需求变更和反复迭代,数据报表臃肿,数据参差不齐;用户分析具体业务问题找数据、核对确认数据成本较高。技术视角指标定义,指标命名混乱,指标不唯一,指标维护口径不一致;指标生产,重复建设;数据汇算成本较高;指标消费,数据出口不统一,重复输出,输出口径不一致;产品视角缺乏系统产品化支持从生产到消费数据流没

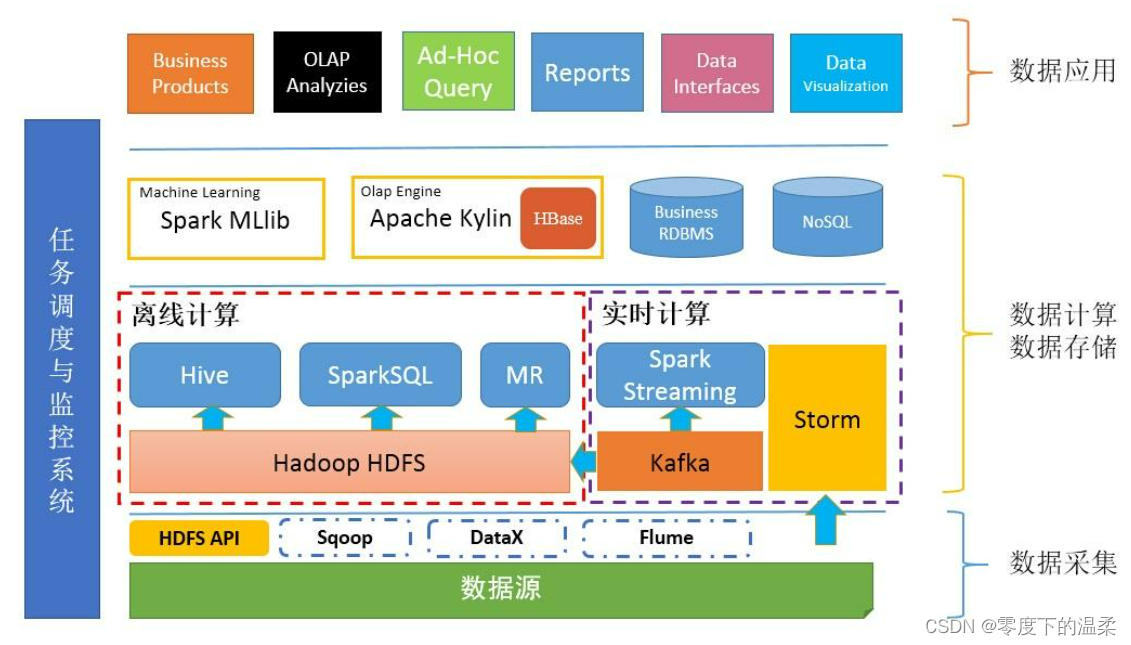

1. 通常来说,Spark与MapReduce相比,Spark运行效率更高。请说明效率更高来源于Spark内置的哪些机制?spark是借鉴了Mapreduce,并在其基础上发展起来的,继承了其分布式计算的优点并进行了改进,spark生态更为丰富,功能更为强大,性能更加适用范围广,mapreduce更简单,稳定性好。主要区别(1)spark把运算的中间数据(shuffle阶段产生的数据)存放在内存,

在 src/main/目录下,可以看到已有的默认源文件目录是 java,我们可以将其改名为 scala。将数据文件 UserBehavior.csv 复制到资源文件目录 src/main/resources 下,我们将从这里读取数据_大数据培训。

定义样例类 OrderEvent,这是输入的订单事件流;另外还有 OrderResult,这是输出显示 的 订 单 状 态 结 果 。 订 单 数 据 也 本 应 该 从 UserBehavior 日 志 里 提 取 , 由 于UserBehavior.csv 中没有做相关埋点,我们从另一个文件 OrderLog.csv 中读取登录数据_大数据培训。...

以下文章来源于大数据左右手 ,作者左右前言实时数仓,难免会遇到join维表的业务。现总结几种方案,供各位看官选择:查找关联(同步,异步)状态编程,预加载数据到状态中,按需取冷热数据广播维表Temporal Table JoinLookup Table Join查找关联查找关联就是在主流数据中直接访问外部数据(mysql,redis,impala ...)去根据主键或者某种关键条件去关联取值。适合:

我们不管是基于 Hadoop 的数据仓库(如 Hive ),还是基于传统 MPP 架构的数据仓库(如 Teradata ),抑或是基于传统 Oracle 、MySQL 、SQL Server 关系型数据库的数据仓库,其实都面临如下问题:怎么组织数据仓库中的数据?怎么组织才能使得数据的使用最为方便和便捷?怎么组织才能使得数据仓库具有良好的可扩展性和可维护性?Kimball 维度建模理论很好地回答和解

以下文章来源于涤生大数据1 Hive有哪些参数,如何查看这些参数Hive自带的配置属性列表封装在HiveConfJava类中,因此请参阅该HiveConf.java文件以获取Hive版本中可用的配置属性的完整列表。具体可以下载hive.src通过eclipse查看。全部属性有上千个吧,一般Hive的自带属性都是以hive.开头的,每个属性且自带详细的描述信息,其次Hive官网也有,但是属性不是特别

需求一:用户活跃主题DWS层--(用户行为宽表层) 目标:统计当日、当周、当月活动的每个设备明细1 每日活跃设备明细 dwd_start_log--->dws_uv_detail_day--把相同的字段collect_set到一个数组, 按mid_id分组(便于后边统计)collect_set将某字段的值进行去重汇总,产生array类型字段。如: concat_ws('|', collect

1一面维度建模 如何建 确认主题 确认粒度 确认度量 确认事实表 确认维度表 Hive shuffle 和 spark shuffle的区别 Spark 为什么快 Spark任务是怎么执行的 转化率如何计算 缓慢变化维怎么处理 Flink状态 Flink窗口 Flink广播流题目 两个升序链表 合并后仍然升序给你两个单词 word1 和 word2,请你计算出将 word1 转换成 word2 所

1. 简单介绍一下FlinkFlink是一个面向流处理和批处理的分布式数据计算引擎,能够基于同一个Flink运行,可以提供流处理和批处理两种类型的功能。 在 Flink 的世界观中,一切都是由流组成的,离线数据是有界的流;实时数据是一个没有界限的流:这就是所谓的有界流和无界流。2. Flink的运行必须依赖Hadoop组件吗Flink可以完全独立于Hadoop,在不依赖Hadoop组件下运行。但是