简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文提出了G-LLaVA智能体,通过构建增强的几何数据集Geo170K,显著提高了多模态大语言模型在几何问题解决中的表现。论文题目: G-LLaVA: Solving Geometric Problem with Multi-Modal Large Language Model论文链接: https://arxiv.org/abs/2312.11370PS: 欢迎大家扫码关注公众号,我们一起在AI

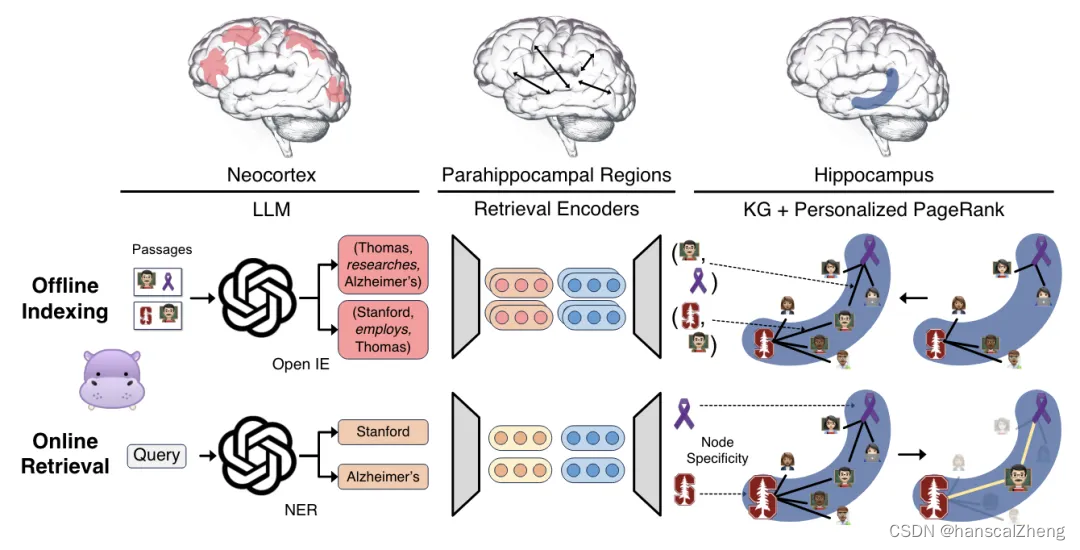

HippoRAG作为一种新型的LLM长期记忆框架,通过模仿人类大脑的记忆机制,展示了在多跳问答任务中的潜力。论文题目:HippoRAG: Neurobiologically Inspired Long-Term Memory for Large Language Models论文链接:https://arxiv.org/pdf/2405.14831PS: 欢迎大家扫码关注公众号,我们一起在AI的世

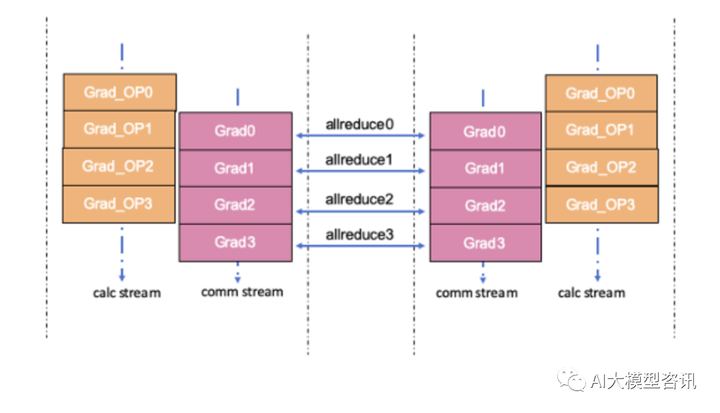

也就是说上一个梯度的通信和下一个梯度的计算间并没有依 赖,通信和计算可以并行,让两者的耗时相互重叠掩盖,减少反向的耗时,下图为通信计算并行相互重叠示例。减少总的通信消耗, 可以通过减少通信频率来实现, 通信融合是一个可 行的手段,通过将 N 个梯度的 Allreduce 通信合并成一次 Allreduce 通信,可以减少 N- 1 次通信延迟时间。通信算子调度到通信流, 计 算算子调度到计算流,

在大型语言模型中,平衡模型参数、词汇量与训练数据的规模对于实现高效能和经济性的模型扩展至关重要。论文重点研究了大型语言模型中词汇量大小对模型扩展规律的影响,发现更大规模的模型应配备更庞大的词汇量以优化性能,并通过实验验证了这一观点,指出当前许多大型语言模型所使用的词汇量实际上偏小。论文题目:Scaling Laws with Vocabulary: Larger Models Deserve La

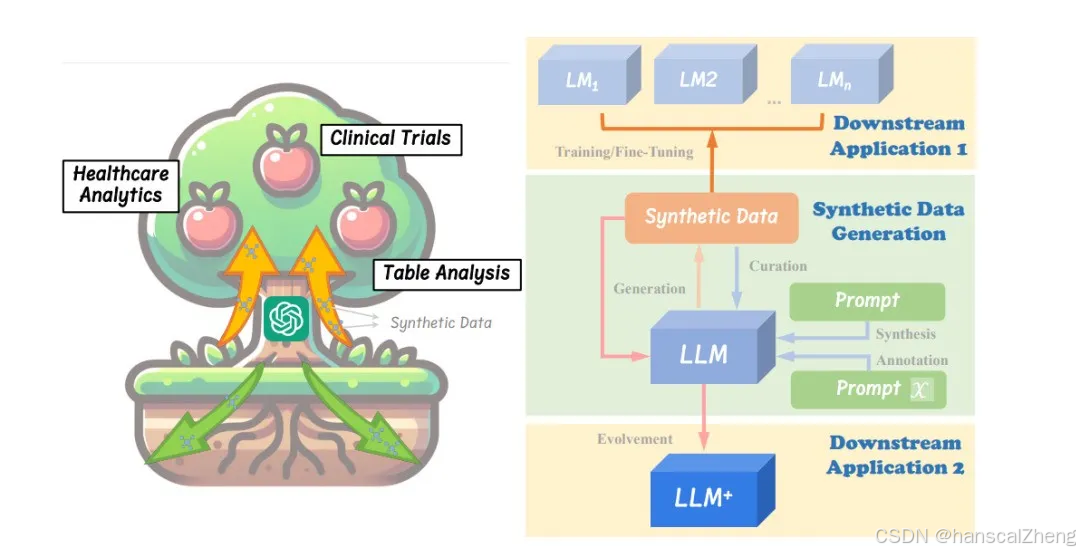

尽管看似简单,但生成同时具有高正确性和足够多样性的合成数据集需要精心设计过程,并涉及许多技巧,使得LLMs驱动的合成数据生成成为一个非平凡的问题。论文的主要目的是提供该领域的全面概述,确定关键关注领域,并突出需要解决的空白,希望为学术界和工业界带来见解,并推动LLMs驱动的合成数据生成的进一步发展。论文题目:On LLMs-Driven Synthetic Data Generation, Cur

论文提出了偏好链优化(CPO)方法,通过对大型语言模型进行微调,使其在复杂问题推理中生成更优的逻辑推理路径,同时显著降低推理复杂性。论文题目: Chain of Preference Optimization: Improving Chain-of-Thought Reasoning in LLMs论文链接: https://arxiv.org/abs/2406.09136PS: 欢迎大家扫码关注

文章倡导将具身人工智能(E-AI)作为迈向通用人工智能(AGI)的关键步骤,并强调了E-AI相较于当前的人工智能进步,如大型语言模型(LLMs),在实现具备感知、行动、记忆和学习能力的智能体方面的必要性和理论框架。论文题目: A call for embodied AI论文链接: https://arxiv.org/abs/2402.03824PS: 欢迎大家扫码关注公众号,我们一起在AI的世界中

文章提出了一种利用人工智能反馈强化学习(RLAIF)来优化视频大型多模态模型(VLMMs)的视频与文本对齐的方法,显著提升了模型在视频理解任务中的表现。论文题目: Tuning Large Multimodal Models for Videos using Reinforcement Learning from AI Feedback论文链接: https://arxiv.org/abs/240

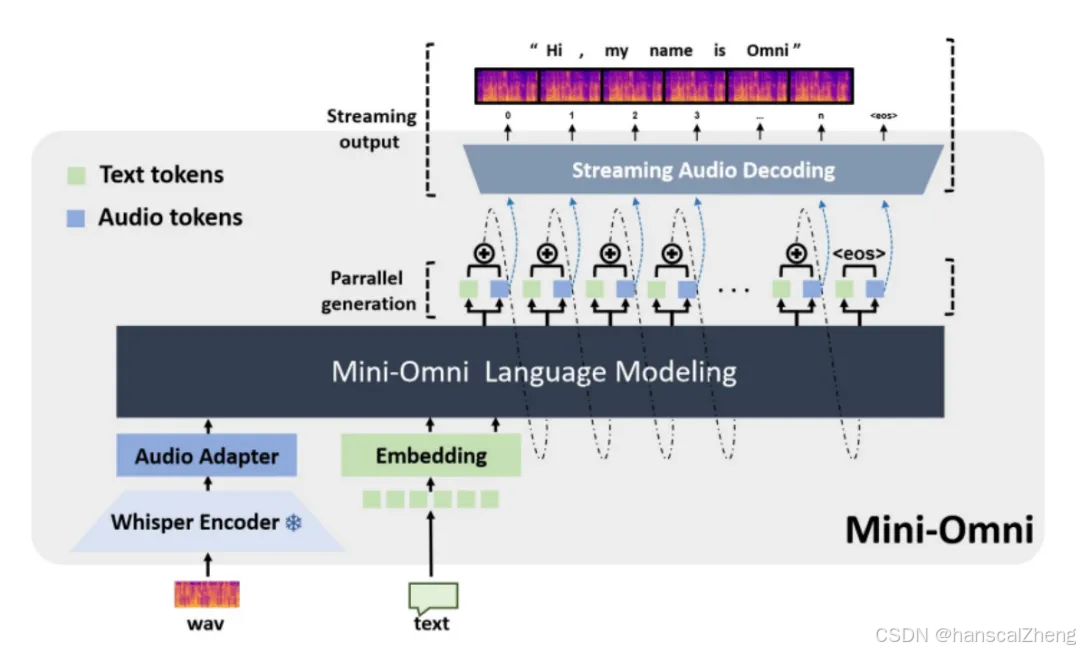

文章介绍了Mini-Omni模型,一种能够实现实时语音交互的端到端多模态大语言模型,并提出了提升语音生成效率的方法。论文题目: Mini-Omni: Language Models Can Hear, Talk While Thinking in Streaming论文链接: https://arxiv.org/abs/2408.16725PS: 欢迎大家扫码关注公众号,我们一起在AI的世界中探索

UNWIND用于将任何列表变回单独的行。这些列表可以是传入的参数,先前编辑的 collect 结果或其他列表表达式。注意UNWIND 需要指定一个新的名称。列表操作unwind [1, 2, 3, NULL] as xreturn x, 'val' as y结果是:列表去重with [1, 1, 2, 2] as collunwind coll as xwith distinct xreturn