简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

2025年1月15日,北京月之暗面科技有限公司宣布全新多模态图片理解模型moonshot-v1-vision-preview正式发布,该模型完善了moonshot-v1模型系列的多模态能力,助力Kimi更好地理解世界。Vision模型具备强大的图像识别能力,能准确识别图像中的复杂细节和细微差别,无论是食物还是动物,都能区分出相似但不相同的对象。例如,面对16张相似的人眼较难区分的蓝莓松饼和吉娃娃图

上周,OpenAI 发布了其最新的前沿模型,正式命名为 gpt-4o-2024-08-06,该新模型在API中支持结构化输出。虽然OpenAI仍建议开发人员将gpt-4o-2024-08-06用于大多数API使用,但chatgpt-4o-latest模型将允许开发人员测试OpenAI在聊天用例方面的最新改进。根据OpenAI的官方文档页面,chatgpt-4o-latest将是一个动态模型,将不断

这两款大模型今年3月发布,均支持8K和128k上下文长度。据了解,ERNIE Lite是百度自研的轻量级大语言模型,兼顾优异的模型效果与推理性能,适合低算力AI加速卡推理使用。ERNIE Speed则是百度自研高性能大语言模型,适合作为基座模型进行精调,更好地处理特定场景问题,同时具备极佳的推理性能。百度则更进一步,直接宣布两款主力模型免费,从“天价”到“骨折价”再到免费,大模型进入免费时代已然到

英伟达公司首席执行官黄仁勋周五(6月14日)在加州理工学院(Caltech)毕业典礼上发表演讲,鼓励毕业生在逆境中努力,不断寻求新的机遇。黄说,加州理工学院因其毕业生受人尊敬而闻名,如诺贝尔物理学奖获得者理查德-费曼(Richard Feynman)、诺贝尔化学奖获得者莱纳斯-鲍林(Linus Pauling)和半导体先驱卡佛-米德(Carver Mead),他因创造了 "摩尔定律 "一词而功不可

最近的研究发现,处于高密度环境中的星系往往比孤立的星系大得多,这对现有的星系形成理论提出了挑战。这一发现得益于机器学习和来自数百万个星系的大量数据。这些发现提出了关于暗物质和星系合并在塑造宇宙中的作用的新问题。

字节跳动在回应中表示,涉事实习生恶意干扰商业化技术团队研究项目的模型训练任务,但并不影响商业化的正式项目及线上业务,也不涉及字节跳动大模型等其他业务。经核实,涉事人一直在商业化技术团队实习,并没有Al Lab实习经历。该实习生已在8月被公司辞退。公司也将其行为同步给行业联盟和所在学校,交由校方处理。10月19日,针对实习生攻击字节跳动模型一事,字节跳动官方回应表示,经公司内部核实,确有商业化技术团

这种独特的"看视频学习"方法使GR-2获得了丰富的知识储备,深入理解了人类的日常行为模式和复杂的世界环境。随着技术的不断完善和应用场景的拓展,我们有理由期待GR-2及类似的智能机器人系统在未来会给我们的生活和工作方式带来革命性的变化。只需一个简单的语言指令,如"从白盘子左侧拿起叉子",GR-2就能生成准确的动作视频,轻松完成任务。无论是在果蔬分类任务中应对物品位置的变化,还是在工业应用中进行端到端

6月21日,华为开发者大会(HDC 2024)在广东东莞正式开幕。盘古大模型5.0的更新,也是此次HDC2024的另一项重头戏。在过去的一年中,盘古大模型正在疯狂向各行各业渗透。此次,华为方面展示了他们在具身智能、医药、气象、铁路、媒体、钢铁等领域的应用。据介绍,一年的时间,盘古大模型已经落地到30多个行业、400多个场景,堪称火箭速度。

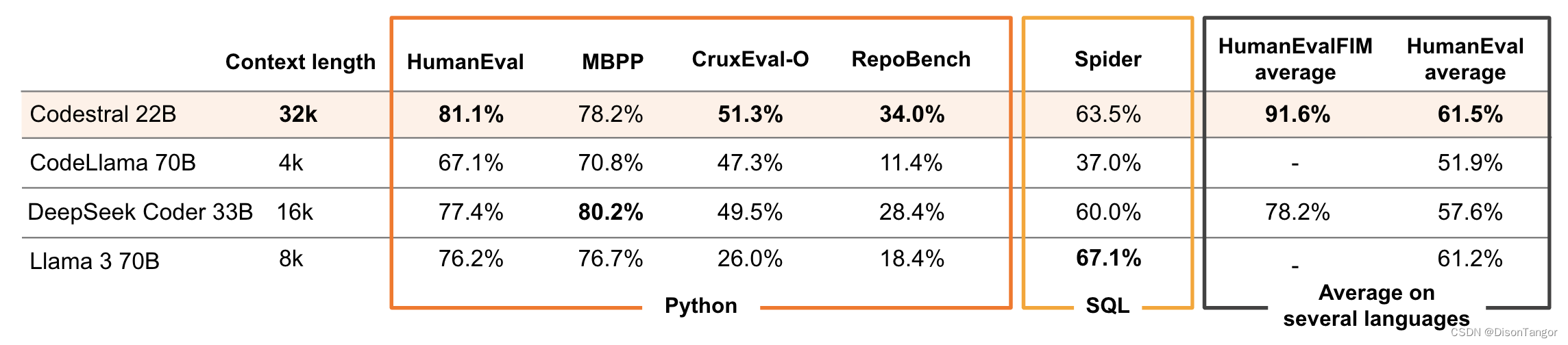

Mistral 将这种模式描述为"开放",但这还有待商榷,因为这家初创公司的许可证禁止将 Codestral 及其产出用于任何商业活动。虽然有"开发"的例外,但即使是"开发"也有注意事项:许可证明确禁止"员工在公司业务活动中的任何内部使用",究其原因可能是 Codestral 部分训练内容受版权保护。在 2023 年 6 月的 Stack Overflow民意调查中,44% 的开发人员表示,他们现

Mooncake 推理系统通过创新的 PD 分离架构和以存换算为中心的理念,显著提升了推理的吞吐能力,吸引了广泛的行业关注。” 他期待更多企业和研究机构加入 Mooncake 项目,共同探索更高效的模型推理系统架构,让 AI 助手等基于大模型技术的产品能够惠及更广泛的人群。同时,该项目将兼容多种推理引擎和底层存储、传输资源。Kimi 公司的工程副总裁许欣然表示:“通过与清华大学 MADSys 实验