简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本次开源的声纹识别算法来源于wenet社区发布的wespeaker, 具有高质量、轻量级、面向产品等特点

Conformer模型是一种结合了Transformer的自注意力机制和CNN卷积模块的混合模型, 主要用于语音识别领域, 能够将输入的音频转换为对应的文本序列

本次开源的声音事件检测算法来源于Aibaba开源的语音算法仓库, 具有轻量级、稳定性高等特点。接下来详细介绍如何在sigmstar D1ssd2355开发板上如何部署的详细步骤。

星宸科技推出轻量化端侧AI开发套件ComakePiD2,搭载1.5TOPS算力芯片SSC309QL,支持离线语音识别和复杂图像处理,功耗仅300mW。其49mm迷你尺寸适配可穿戴设备、无人机等场景,配备Wi-Fi6和4K视频处理能力,结合Comake开发者社区资源,助力开发者快速实现AI产品量产。

本文详细介绍了嵌入式开发环境的搭建与配置方法。主要内容包括:1)开发环境采用"宿主机+目标板"模式,需配置交叉编译环境;2)推荐使用64位Linux服务器(Ubuntu 18.04及以上),配置16GB内存和600GB硬盘;3)安装必要的软件包和交叉编译工具链;4)设置默认shell为bash,Python版本为2.x;5)详细说明了SDK解压、project编译、boot编译

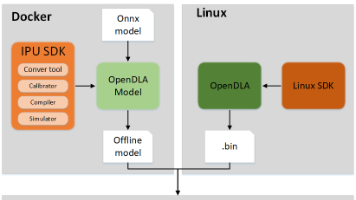

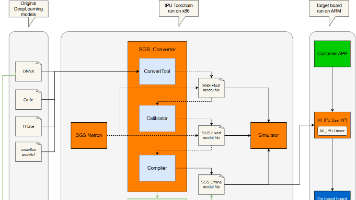

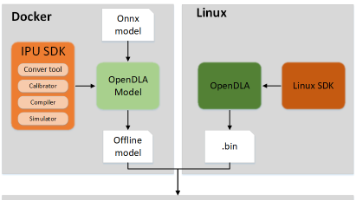

文章摘要:本文介绍了IPU-Toolchain模型推理流程及Simulator工具的使用方法,包括浮点/定点网络模型的推理步骤、工具参数配置(如图片输入、模型路径、预处理等)以及远程开发板推理操作。详细说明了Simulator的必选/可选参数功能,并提供了板端RPC服务连接、网络测试及内存优化方案。最后指引用户访问Comake开发者社区获取更多资源。全文约150字。

星宸科技推出轻量化端侧AI开发套件ComakePiD2,搭载1.5TOPS算力芯片SSC309QL,支持离线语音识别和复杂图像处理,功耗仅300mW。其49mm迷你尺寸适配可穿戴设备、无人机等场景,配备Wi-Fi6和4K视频处理能力,结合Comake开发者社区资源,助力开发者快速实现AI产品量产。

语音分离是指从混合的音频信号中提取出独立的语音源, 例如, 在多人会议录音中, 分离出每个说话人的声音。 本次开源的语音分离算法来源于SpeechBrain发布的Pytorch开源工具包, 该工具包集成了多种先进的音频处理技术, 详情可参考Speechbrain官方说明,可以进一步的参考该文章实战起来。

Sigmastar Comake PI D1AIOT开发板套件,此文记录一下开箱与使用体验

星宸科技推出ComakePiD1 AIoT开发板,搭载SSD2355芯片,为开发者提供低功耗、高性能的端侧AI解决方案。该开发板配备4核A35 CPU、1T NPU算力,支持主流AI框架转换,并集成丰富外设接口。适用于智能音箱、工业HMI、教育机器人等场景,具备双网口、多摄像头支持及音频处理能力。配套开源SDK、AI工具链和开发者社区,助力快速实现产品量产。开发板满负荷功耗<1.3W,兼具高