简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

政策与标准不是“束缚手脚的绳子”,而是“保驾护航的护栏”。就像老电工常说“地线是生命保险丝”,合规就是企业发展的“保险丝”——只有吃透新规、踩准节奏,才能在行业转型中少走弯路、行稳致远。

文档摘要:1000字的技术文章→200字要点,比如输入一篇关于“LLM幻觉问题”的文章,摘要会包括“幻觉定义、原因、解决方法、行业影响”。会议录音转摘要:将1小时的会议录音(转文字后)浓缩为500字摘要,标注“决策事项、待办任务、责任人”。新闻摘要:输入一篇5000字的深度报道,模型能提炼出“事件起因、经过、结果、各方观点”。Transformer架构:是LLM的“骨架”——通过自注意力机制实现并

追求极致精度的“工匠精神”,适合对准确率要求极高的场景YOLO:追求实时速度的“闪电侠”,适合需要快速响应的应用SSD:平衡速度与精度的“中庸之道”,适合大多数通用场景。

摘要:检索增强生成(RAG)技术在应用中面临检索质量低、上下文管理难、生成不忠实、知识更新慢和评估困难等核心痛点。本文提出分层解决方案:通过查询重写、语义分块和混合检索提升检索质量;采用动态上下文选择和元数据过滤优化管理;运用强指令提示和后处理增强生成忠实度;实现增量更新和版本控制保障知识一致性;构建评估框架和模块化架构支持持续迭代。未来RAG将向端到端优化、智能体化和平台化方向发展,需结合领域知

本文系统梳理了1986-2026年AI大模型40年的发展历程。研究以反向传播算法为起点,划分为早期探索(1986-2005)、深度学习复兴(2006-2016)和大模型时代(2017-2026)三个阶段,详细分析了各时期的关键技术突破(如AlexNet、GAN、Transformer)和应用场景拓展。研究发现模型架构经历了从感知机到Transformer的九次认知跃迁,呈现出参数规模扩大、多模态融

神经网络发展经历了从单模型突破到跨架构融合的递进过程,核心遵循"线性建模→循环时序建模→注意力并行建模→大模型融合建模"的技术主线。从1943年M-P神经元模型开始,历经感知机、RNN、LSTM等关键突破,最终在2017年迎来Transformer的革命性创新。Transformer融合注意力机制和前馈网络,实现全并行计算,彻底改变了神经网络的发展方向,开启了大模型时代。后续B

《ChatGPT商业与创业AI提示词大全》是一份精心整理的实用指南,专为创业者及商业人士设计。该资源覆盖创业全流程关键环节: 核心功能模块: 创意孵化:提供智能域名生成、商业模式画布等工具 运营管理:包含团队建设、项目管理等标准化模板 营销加速:集成SEO策略、社交媒体广告等数字营销方案 融资支持:提供投资者匹配、路演材料生成等专业服务 特色亮点: 200+经过验证的提示词模板 明确的任务角色定位

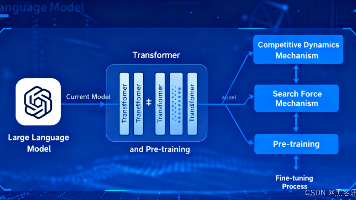

摘要: 大语言模型(LLM)的核心是文本预测,基于Transformer架构实现长文本理解,通过预训练(通用知识)和微调(专项技能)获得能力。用户需了解其四大限制:幻觉(编造信息)、上下文窗口有限(长文本记忆不足)、知识截止(无法获取最新信息)和推理深度不足。应用时需掌握提示词工程三原则:明确具体指令、提供参考示例、设定专业角色,并针对不同任务(内容创作、信息整理等)适配策略。通过分步骤提问、交叉

本文系统梳理了长短期记忆网络(LSTM)的发展脉络。作为RNN的改进模型,LSTM通过门控机制解决了梯度消失问题,成为处理长序列数据的里程碑。文章分析了LSTM的核心创新、优势及其变体(如GRU、Bi-LSTM),并对比了CNN/TCN和Transformer等新兴时序模型的特性。尽管Transformer在并行计算和长距离依赖方面表现优异,LSTM在小数据、低算力场景仍具优势。未来LSTM将向轻

在第2章中,我们拆解了智能体的“身体构造”——大脑、工具、记忆与规划四大核心组件。而本章将聚焦“如何将这些组件落地”,通过梳理技术选型逻辑、架构设计思路,为你绘制一份可落地的智能体技术实现蓝图。构建智能体的过程,好比“组装一台精密的数字机器”:首先要选对核心的“发动机”(大脑,即LLM),再为其匹配“传动系统”(工具调用框架)、“存储模块”(记忆数据库)和“控制系统”(规划逻辑)。其中,——本章将