简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

基于 Rust 编写的 AI Agent 框架 ZeroClaw,接入 60s 新闻 API 和 AWS SNS,实现了定时获取每日新闻与多平台热搜并推送邮件的自动化助手。过程中解决了源码重复定义 bug、OpenAI Provider 硬编码地址(改用 custom: provider 接入本地 LiteLLM 代理)、安全策略限制(放开 http_request 域名白名单和 shell 命令

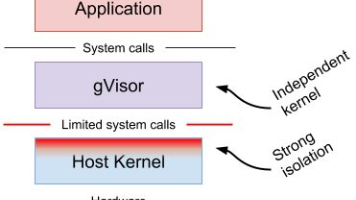

摘要 本文探讨了云原生环境中的安全沙箱技术,重点分析了gVisor在容器隔离中的应用。文章比较了三种隔离方案:基于硬件的虚拟化(如KVM)、基于规则的执行(如seccomp)和gVisor方案,指出gVisor通过拦截系统调用实现轻量级隔离,兼具资源效率和安全性的优势。详细介绍了gVisor的架构设计(Sentry内核和Gofer文件系统访问)及其在EKS环境中的部署实践,包括runtime配置和

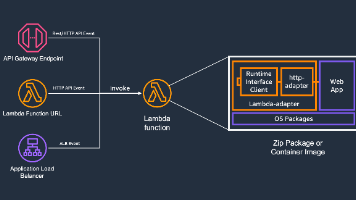

摘要 MCP(Model Context Protocol)定义了客户端与服务端之间的通信机制,支持两种标准化传输方式:stdio和Streamable HTTP。相比早期基于HTTP+SSE的方案,Streamable HTTP通过单一端点简化了实现。在AWS Lambda上部署MCP服务器有三种主要方法:1)使用自定义MCP处理器适配Lambda请求-响应模型;2)通过stdio运行现有MCP

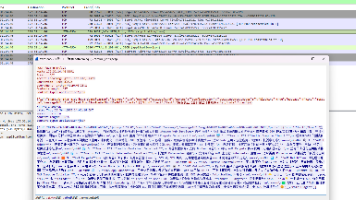

本文探讨了利用A2A(Agent-to-Agent)能力实现跨语言、跨框架的智能体协同工作。通过AgentScope框架,开发者可以将应用包装成符合A2A规范的服务端点,并自动注册到Nacos服务发现系统中。文章详细展示了如何使用Python代码创建导游智能体服务,包括定义Nacos注册中心、配置Agent技能(如景点推荐和旅游咨询),以及部署服务的过程。同时,通过抓包分析发现,客户端实际通过98

本文介绍了在AWS GPU环境下部署Qwen-Image模型的实践过程。测试环境采用4块A10G显卡(24GB显存),使用Docker容器和Kubernetes部署。尝试了两种推理方式:通过diffusers库直接推理时遇到单卡显存不足问题(需20GB以上显存),而ComfyUI方案通过FP8量化模型减少了显存需求,成功在单卡上完成推理(约38秒/图)。实验表明,Qwen-Image模型对显存要求

本文介绍了AI Agent记忆系统的概念与实现方式。记忆系统分为短期记忆和长期记忆:短期记忆参与模型推理,需要上下文管理策略(如压缩、摘要);长期记忆从短期记忆抽取,通过检索辅助推理,通常由独立组件实现(如Mem0、Zep)。文章对比了不同框架的记忆实现,包括AgentScope的会话级短期记忆和跨会话长期记忆,以及AWS Strands框架的Mem0集成。还介绍了通过agent-memory-s

文章摘要: 本文介绍了如何在VSCode中使用Cline工具集成AWS相关服务,通过配置MCP服务器实现多种功能。重点包括:1)通过LiteLLM封装自部署模型以降低成本;2)配置文档查询服务用于知识检索;3)集成AWS API服务用于资源管理;4)使用计费管理服务监控成本;5)特定领域工具如IAM策略分析。提供了不同场景的JSON配置模板,包括在线文档助手、资源检索、成本管理等典型用例配置方案,

当然,Ray还提供了更高级的库,比如RLLib,它提供了更丰富的强化学习算法和模型,可以处理更复杂的场景。这个类包含了游戏的关键信息:寻觅者的当前位置seeker,目标的位置goal,以及寻觅者可以执行的动作空间action_space和它能观察到的状态空间observation_space。这个过程会涉及到智能体的移动、状态的观察、奖励的获取,以及最终的决策。Simulation类的rollou

我们开始构建神经网络模型了。import torch.nn as nn # 导入 torch.nn 库# 定义编码器类,继承自 nn.Moduleself.hidden_size = hidden_size # 设置隐藏层大小self.embedding = nn.Embedding(input_size, hidden_size) # 创建词嵌入层self.rnn = nn.RNN(hidden

本文介绍了基于Qwen-Agent项目的CosyVoice2 TTS模型部署过程。测试环境采用AWS g5.4xlarge实例和Ubuntu 24.04系统,通过Docker容器隔离运行环境。重点解决了vllm 0.9.0版本与Python 3.12的兼容性问题,通过conda创建Python 3.10虚拟环境成功运行。文章详细演示了零样本语音克隆、说话人特征保存复用、细粒度控制标记使用以及指令驱