简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文详细介绍了如何利用Nanobot和vLLM构建智能QQ聊天机器人。Nanobot作为超轻量级AI智能体(仅4000行代码),结合vLLM的高效推理能力,可实现快速响应和多功能对话。教程涵盖从环境准备(推荐16GB+显存GPU)、星图AI部署Qwen3-4B模型、QQ机器人注册,到Nanobot安装配置的全流程。最终实现的机器人支持本地部署、多轮对话和功能扩展,为个人AI助手提供实用解决方案。文

本文详细介绍了如何利用Nanobot和vLLM构建智能QQ聊天机器人。Nanobot作为超轻量级AI智能体(仅4000行代码),结合vLLM的高效推理能力,可实现快速响应和多功能对话。教程涵盖从环境准备(推荐16GB+显存GPU)、星图AI部署Qwen3-4B模型、QQ机器人注册,到Nanobot安装配置的全流程。最终实现的机器人支持本地部署、多轮对话和功能扩展,为个人AI助手提供实用解决方案。文

本文详细介绍了如何利用Nanobot和vLLM构建智能QQ聊天机器人。Nanobot作为超轻量级AI智能体(仅4000行代码),结合vLLM的高效推理能力,可实现快速响应和多功能对话。教程涵盖从环境准备(推荐16GB+显存GPU)、星图AI部署Qwen3-4B模型、QQ机器人注册,到Nanobot安装配置的全流程。最终实现的机器人支持本地部署、多轮对话和功能扩展,为个人AI助手提供实用解决方案。文

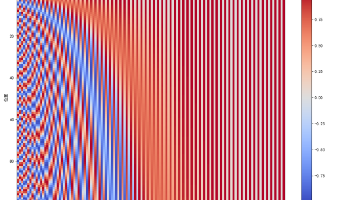

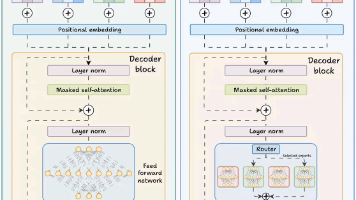

本文系统解析了Transformer模型中的两种关键位置编码技术:正弦绝对位置编码和旋转位置嵌入(RoPE)。正弦编码通过多维正弦波组合为每个位置生成独特向量,利用波形频率差异实现位置区分,同时保留相对位置关系。RoPE则创新性地采用旋转矩阵对嵌入向量进行变换,将位置信息融入向量角度变化中。两种方法都实现了位置与语义信息的有效平衡,前者通过简单相加,后者通过几何变换。可视化分析表明,这两种编码方案

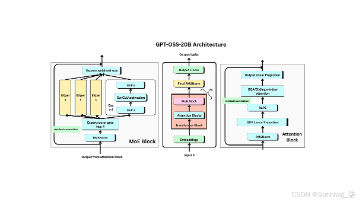

GPT-OSS通过混合专家(MoE)架构实现高效的大模型运算,每个token仅激活少量专家模块,既保留大容量知识存储又控制计算成本。相比GPT-2,GPT-OSS采用RoPE位置编码、Swish/SwiGLU激活函数、分组查询注意力(GQA)和滑动窗口注意力等创新技术,显著提升模型性能与效率。这些改进使GPT-OSS在保持推理速度的同时扩展参数量,成为开放权重的大型语言模型范本,推动AI技术进步与

OpenAI开源了GPT-OSS系列大语言模型,包含120B和20B参数两个版本,采用混合专家(MoE)架构,支持128k上下文长度和工具调用功能。模型在数学推理、编程、多语言理解等基准测试中表现优异,可本地部署运行:120B版需80GB显存,20B版需16GB显存。OpenAI提供了完整的软件工具链支持,包括Hugging Face集成、vLLM服务器和Ollama支持,并允许用户进行微调。这一

混合专家 (MoE) 架构是一种神经网络设计,通过为每个输入动态激活一组称为专家的专用网络子集来提高效率和性能。门控网络确定要激活哪些专家,从而实现稀疏激活并降低计算成本。MoE 架构由两个关键组件组成:门控网络和专家。让我们来分解一下:从本质上讲,MoE 架构就像一个高效的交通系统,根据实时条件和所需目的地将每辆车(或在本例中为数据)引导至最佳路线。每个任务都会被路由到最适合处理该特定任务的专家

深度学习并没有想象的那么难,甚至比有些传统的机器学习更简单。所用到的数学知识也不需要特别的高深,本章将会一边讲解深度学习中的基本理论,一边通过动手使用PyTorch实现一些简单的理论,本章内容很多,所以只做一个简短的介绍。

MNIST 包括6万张28x28的训练样本,1万张测试样本,很多教程都会对它”下手”几乎成为一个 “典范”,可以说它就是计算机视觉里面的Hello World。所以我们这里也会使用MNIST来进行实战。前面在介绍卷积神经网络的时候说到过LeNet-5,LeNet-5之所以强大就是因为在当时的环境下将MNIST数据的识别率提高到了99%,这里我们也自己从头搭建一个卷积神经网络,也达到99%的准确率。

Python数据分析初级