简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文提出了一种新型的轻量级视觉网络架构——LSNet(Large-Small Network),旨在通过高效的感知和聚合策略,在有限的计算成本下实现高性能的视觉信息处理。LSNet的设计灵感来源于人类视觉系统的“看大,聚焦小”策略,通过结合大核感知(Large-Kernel Perception, LKP)和小核聚合(Small-Kernel Aggregation, SKA)的LS卷积操作,实现

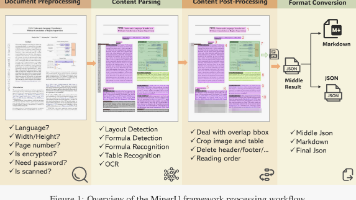

MinerU是一款由OpenDataLab开源的多模态文档智能解析工具链,旨在将PDF等非结构化文档转化为机器可读的结构化数据。MinerU支持多种输出格式(Markdown/LaTeX/HTML/JSON),可处理复杂版式文档,并针对重叠元素设计了智能后处理算法。该工具填补了开源社区在高精度文档理解基础设施方面的空白,为构建高质量大模型语料库提供了工业级解决方案。

这篇文章介绍了MeanFlow,这是一种新型的一步生成模型框架,用于生成建模。与传统的流匹配方法不同,MeanFlow通过引入平均速度的概念来表征流场,而不是使用瞬时速度。平均速度定义为两个时间步长之间的位移与时间间隔的比值,这一定义使得模型能够在单次函数评估中完成从先验分布到数据分布的转换,显著提高了生成效率。文章详细阐述了MeanFlow模型的理论基础,包括平均速度与瞬时速度之间的关系,以及如

Qwen3 代表了人类在通往通用人工智能(AGI)和超级人工智能(ASI)旅程中的一个重要里程碑。通过扩大预训练和强化学习的规模,之子实现了更高层次的智能。作者无缝集成了思考模式与非思考模式,为用户提供了灵活控制思考预算的能力。此外,作者还扩展了对多种语言的支持,帮助全球更多用户。

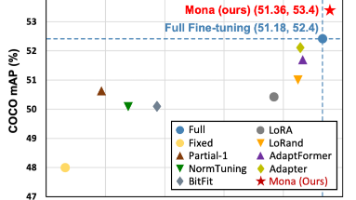

文介绍了一种名为Multi-cognitive Visual Adapter(Mona)的新型调优方法,通过仅调整预训练模型中约5%的参数,成功超越了传统的全量微调方法,为视觉识别任务的高效迁移学习提供了新的解决方案。实验结果表明,Mona在多种视觉任务上均实现了超越全量微调的性能表现,同时显著减少了计算成本和存储需求。

Qwen-Image是由阿里巴巴团队开发的200亿参数多模态图像基础模型,在复杂文本渲染和精准图像编辑方面取得突破性进展。该模型采用MMDiT架构,整合了多模态大语言模型Qwen2.5-VL和创新的变分自编码器,通过多阶段训练策略和严格的数据过滤流程,实现了卓越的生成能力。在公开基准测试中,Qwen-Image在文本到图像生成、中文文本渲染、图像编辑等任务上均达到SOTA水平,特别是在中文长文本处

决策树(decision tree)是一类常见的机器学习方法,是一种基于树结构的监督学习算法,广泛应用于分类和回归任务中。

周志华西瓜书机器学习第二章

《机器学习》,又称西瓜书,是南京大学教授周志华教授编著的一本机器学习领域的经典教材。在接下来的日子里,我将每周精心打磨一章内容,全方位、多角度地为大家剖析书中精髓。