简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

保姆级本地Windows环境快速部署DeepSeek大模型(带Web交互界面)教程

阿里巴巴通义千问团队推出的Qwen3-VL-8B-Instruct是一款80亿参数的开源视觉语言模型,采用Dense架构设计,通过交错MRoPE位置编码、DeepStack特征融合和文本-时间戳对齐三项技术创新,在32项评测中超越Gemini 2.5Pro等闭源模型。该模型支持256K token长上下文,具备精准的工业质检(91.3%准确率)、视频事件定位(96.8%准确率)和医疗诊断能力,同时

机器人灵巧手产业迎来爆发期,2025年全球市场规模达63.39亿元,中国占比超80%。技术方面,混合传动方案成为主流,触觉传感器分辨率提升至0.5mm,国产化率达70%。应用场景从工业制造扩展到医疗、家庭服务等领域,预计2030年市场规模将达450亿元。特斯拉、灵心巧手等企业领跑市场,国产厂商通过技术创新将产品价格降至5-10万元/只。未来产业将围绕"轻量化、高自由度、多模态感知&quo

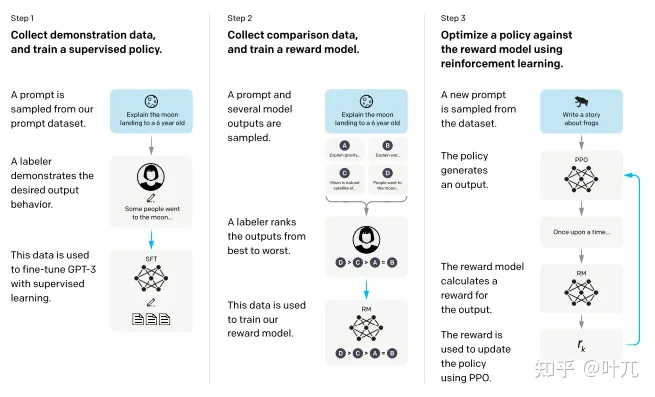

其次,从2003年NPLM开始,几乎每个论文都会讲到如何进行大规模的模型训练,尽量在成本可控制的情况下,即要有成功的设计且还要在可控成本下成功的执行,在当前的NLP-LLM上本身也是很难的工作(参考albert和Roberta,二者都是通过了合理的设计从而使模型可以变得更大)这样就将所有的NLP任务统一起来了。chatgpt的做法是,让模型的知识应用到某个领域,并不计划让模型因为任务的改变而改变,

谷歌发布新一代AI大模型Gemini3,实现多项技术突破:1)完全基于自研TPU训练,摆脱GPU依赖;2)创新统一多模态架构,支持跨模态交互;3)引入分层推理引擎,在MathArena等测试中表现优异;4)首创生成式UI,能动态创建定制化交互界面;5)增强智能体能力,支持复杂工具调用链。该模型在多项基准测试中领先,标志着AI向通用智能体方向迈出重要一步。

计算机视觉及图像处理领域会议,CCF推荐(A类,B类,C类)

我们有时候在生成较大的图谱时,会产生大量的节点以及与之关联的关系,可能会遇到' 由于初始节点显示设置, 并非所有返回节点都被显示. 仅显示 300 个节点中的 300 个 '上述问题。即便我们在代码段中已经设置了MATCH (n) RETURN n LIMIT 10000这是由于neo4j图数据库本身的初始化设置导致的问题在设置里进行修改即可原参数为300,100,1000,上述为自行设置此时再执

pip install langidimport langidprint(langid.classify("This is a test"))print(langid.classify("测试啊"))print(langid.classify("테스트입니다."))print(langid.classify("これはテストです"))print(langid.classify("นี่คือการท

python实现音频切割

这篇总结的恰到好处的文章,对ELMo以来的15个代表性的预训练语言模型进行了多维度的对比和分析。本文转载自知乎专栏《高能NLP之路》并进行了剪切和少量修改,作者JayLou,原文链接https://zhuanlan.zhihu.com/p/76912493首先上一张镇楼专用图,看一下ELMo以来的预训练语言模型发展的概况然后上本文正餐,一个高能的question list,这也是本文写作的主线。Q