简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

NMS是什么:目标检测的后处理算法,用于去除冗余框;核心思想:保留局部最高分框,抑制与其高度重叠的框;关键参数:IoU阈值(常用0.5~0.7);代码实现:10行Python即可搞定(排序 + IoU计算 + 迭代抑制);适用场景:任何输出多个候选框的目标检测模型(YOLO、SSD等)。🌟 一句话牢记NMS:“只留最自信的框,重叠太

宝子们,今天咱们一起了解了机器学习算法里的四大门派——监督学习、无监督学习、半监督学习和强化学习😃。监督学习就像有老师指导的学生,无监督学习是自己探索的探索者,半监督学习是“半吊子”的聪明学生,强化学习则是爱“打游戏”的智能体。它们在不同的场景下都有各自的优势和应用。希望这篇文章能让你对机器学习算法有更清晰的认识🤗。如果你还有其他关于机器学习的问题,欢迎在评论区留言讨论哦👏!咱们下期再见啦?

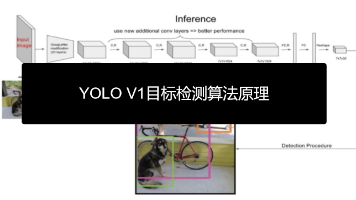

在YOLO(You Only Look Once)问世之前,目标检测算法就像是一个人拿着放大镜在图片上一点点寻找目标:先找可能包含物体的区域,再对这些区域进行分类。这种方法准确但速度慢,难以实时处理。2016年,Joseph Redmon等人提出YOLO V1,带来了一种革命性的思路:为什么不把目标检测当作一个回归问题,只需"看一眼"图片就能直接输出所有检测结果呢? 这就是

在深度学习的炼丹江湖里,选择合适的激活函数就像给我们的模型挑选一件称手的“神兵利器”。二分类问题输出层,Sigmoid 函数这位老江湖偶尔还能露两手;多分类问题输出层,SoftMax 函数这位皇帝稳坐江山;回归问题输出层,Identity 函数这个小精灵默默发挥作用;而隐藏层中,ReLU 及其小伙伴 LeakReLU、ELU 等就像各路武林高手,各有各的绝招,我们要根据具体的“江湖形势”(数据特点

经过前面的步骤,咱们的“丹药”终于要炼成啦!全连接层就像炼丹炉的“出丹口”,它把前面提取的特征整合起来,做出最终的判断(分类或回归)。它会综合考虑所有的特征,就像咱们判断一颗丹药是否炼成一样,要综合考虑颜色、气味、形状等多个方面,然后给出一个最终的“成丹”结果!宝子们,咱们这趟“炼丹”之旅是不是越来越有趣啦?从深度学习这口“大炼丹炉”,到CNN这位“炼丹小能手”,咱们一步步揭开了它们的神秘面纱。

TensorFlow + Horovod > PyTorch + DDP > MindSpore自动并行。:MindSpore联邦学习 > PySyft > TensorFlow Federated。🔥 建议掌握PyTorch+TensorFlow(覆盖90%场景)"你正在使用哪个框架?✅ TensorFlow(工业标准,长期维护)✅ PyTorch(学界标准,方便复现论文)✅ MindSpor

KNN(K-Nearest Neighbors,K最近邻)是最直观的机器学习算法之一,核心思想就是一个样本的类别由其最近的K个邻居决定。比如要判断新同学是“学霸”还是“学渣”,只需看他最常一起玩的K个朋友属于哪类。算距离:计算测试样本与所有训练样本的距离(常用欧氏距离📏);找邻居:选取距离最小的K个样本;数票数:统计K个邻居中各类别的数量;做决策:将测试

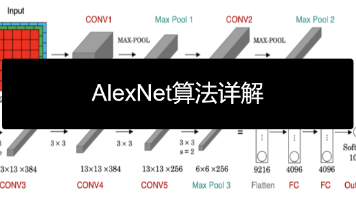

AlexNet的成功并非偶然,而是创新技术 + 工程突破技术面:ReLU、Dropout、数据增强解决训练难题工程面:双GPU并行、重叠池化榨干硬件性能影响力:点燃深度学习十年黄金期,催生CV、NLP、RL等领域大模型✨ 关注我,下期将带来更现代的ResNet残差网络解析!

LSTM 作为 RNN 的 “进化版”,通过遗忘门、输入门等结构,解决了长序列记忆的难题,在 NLP、时间序列等领域大显身手。但它也不是完美的,计算复杂度比 RNN 高,训练起来更费时间和算力,就像学霸虽然成绩好,但也得花更多时间学习不是😉如果你也对序列数据处理感兴趣,不妨动手试试LSTM吧!说不定你也能用它创造出一些有趣的应用呢!🎁: 下期预告:《GRU:我比LSTM少1个门,但得更快!》?

目标检测是计算机视觉中的一项重要技术,它的任务是从图像或视频中找出感兴趣的目标,并检测出它们的位置和大小。与简单的图像分类不同,目标检测需要同时解决两个问题:物体识别(分类) 和物体定位(边界框回归)。这就好比不仅要认出图片中有猫和狗,还要用框标出它们各自在什么位置。选一阶段:如果你需要实时检测(如自动驾驶、直播监控),或资源有限(移动端、嵌入式设备)。选二阶段:如