简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

分类问题;Logistic回归;对数/交叉熵损失函数

线性回归;softmax回归;图像分类数据集

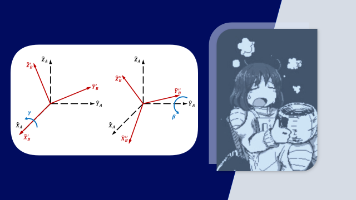

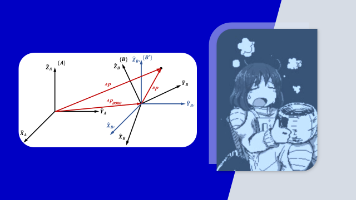

本文探讨了物体姿态的多种数学表示方法。首先指出旋转矩阵9个分量存在6个约束条件,实际仅需3个参数即可确定姿态。重点分析了X-Y-Z固定角和Z-Y-X欧拉角两种表示法,推导了其旋转矩阵表达式,并指出两者在数学形式上的一致性。还介绍了等效角度-轴线表示法,给出了绕任意轴旋转的通用矩阵表达式。这些方法(旋转矩阵、固定角、欧拉角和等效角度-轴线)构成了姿态表示的基础,但也存在局限性,为后续更复杂的应用埋下

本文介绍了Actor-Critic算法及其变体的基本原理。Actor-Critic结合策略梯度和价值函数近似,Actor负责决策动作,Critic评价动作质量。QAC算法用Q函数替代REINFORCE中的G_t,采用SARSA更新Q网络。AAC算法引入优势函数A=Q-V,通过V函数和TD误差估计优势。为解决数据相关问题,A3C采用多智能体并行异步更新,而A2C改进为同步更新,使训练更稳定。这些方法

本文介绍了SayCan框架,该研究通过将大语言模型(LLM)的语义理解能力与机器人示能函数相结合,实现了自然语言指令到机器人动作的转化。论文提出了一种创新方法:用LLM提供任务基础(解析指令),同时利用示能函数提供世界基础(评估执行可行性),二者协同决策。实验表明,在模拟厨房环境中,该系统能有效完成简单指令,规划成功率达84%。研究还探讨了当前局限性和未来方向,如技能库扩展、失败恢复机制等。这项工

STM32是ST公司基于ARMCortex-M内核开发的32位微控制器,功能强大、性能优异、片上资源丰富、功耗低,是一款经典的嵌入式微控制器。系列:主流系列STM32F1内核:ARM Cortex-M3主频:72MHz供电:2.0~3.6V(标准3.3V)封装:LQFP48主闪存存储器为最常用的启动模式。不同型号的启动文件后缀选择方法:建立工程文件夹,Keil中新建工程,选择型号工程文件夹里建立S

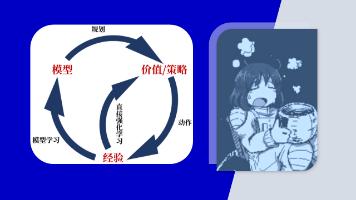

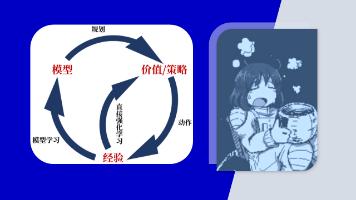

环境的(Model)是一个智能体可以用来预测环境对其动作的反应的任何事物。给定一个状态和一个动作,模型能产生后继状态和下一个收益的预测作为环境的反应结果。根据是否有模型参与,强化学习算法可分为(Model-Based RL,MBRL)和在【深度强化学习】和【分层强化学习】中,我们探讨的都是MFRL,它们将环境视为一个黑箱,智能体直接从与环境交互获得的经验数据中学习价值函数或策略,而不会尝试理解环境

环境的(Model)是一个智能体可以用来预测环境对其动作的反应的任何事物。给定一个状态和一个动作,模型能产生后继状态和下一个收益的预测作为环境的反应结果。根据是否有模型参与,强化学习算法可分为(Model-Based RL,MBRL)和在【深度强化学习】和【分层强化学习】中,我们探讨的都是MFRL,它们将环境视为一个黑箱,智能体直接从与环境交互获得的经验数据中学习价值函数或策略,而不会尝试理解环境

摘要 本文介绍了机器人学中的齐次变换矩阵及其应用。主要内容包括: 位姿描述:通过位置矢量和旋转矩阵表示物体在空间中的位置和姿态。旋转矩阵的行列具有特殊几何意义,且不同坐标系间的旋转矩阵互为转置。 变换映射:推导了坐标系间位置和姿态都不同时的变换公式,引入齐次变换矩阵简化计算。齐次变换矩阵包含旋转矩阵和位置矢量,可统一表示一般变换。 变换算子:介绍了平移和旋转两种基本变换算子。平移算子用齐次矩阵表示

主要参考学习资料:《动手学深度学习》阿斯顿·张 等 著【动手学深度学习 PyTorch版】哔哩哔哩@跟李牧学AI由于本系列一开始跳过了第一章引言部分,因此系列编号比书本章节编号提前。现改为和书本统一(因为之前自己的原始笔记也是按照书本章节编的,每次发布都要修改有些麻烦)。