简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

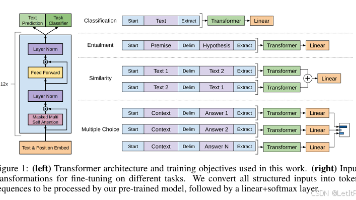

本文系统梳理了GPT系列模型的技术演进路线,从GPT-1到GPT-4的核心技术始终基于Decoder-only Transformer架构。GPT-1首创无监督预训练+微调范式,通过任务特定输入表示实现迁移学习;GPT-2转向纯预训练,探索zero-shot能力;GPT-3突破性地提出few-shot上下文学习,利用1750亿参数实现元学习;GPT-4则实现多模态突破,通过RLHF提升对齐能力。

情感分析是通过计算技术对带有情感色彩的主观性文本进行分析和推理的过程,旨在识别用户的态度和观点。其核心任务包括情感信息抽取和情感分类。该领域发展得益于公开评测如TREC、NTCIR和丰富的数据如Cornell、MPQA和情感词典如GI、HowNet。技术上,情感分析方法从早期的基于规则和词典的方法发展到如今的机器学习如LSTM、SVM、预训练语言模型,其中SnowNLP等库提供了开箱即用的解决方案

根据“冈萨雷斯《数字图像处理》(第四版)”教材,系统介绍了图像增强、滤波、编码和分割等基础知识,图像增强技术通过灰度变换、锐化和滤波等手段,提升图像质量,利于识别和分析。空域与频域处理结合逻辑、算术运算,用于噪声抑制与细节增强,广泛用于医学、遥感等领域。

数据结构--c++实现图的相关操作和算法实验报告

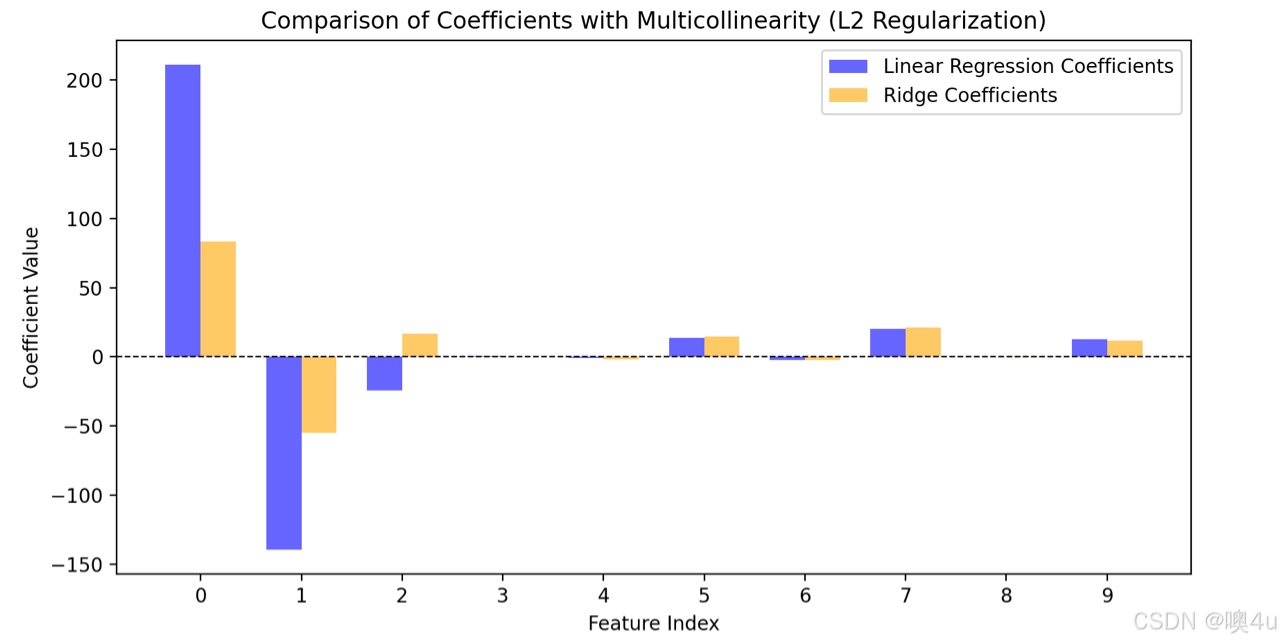

这篇文章详细介绍了机器学习中用于降低模型复杂度的三种正则化技术,并提供代码和可视化结果说明和检验。

《智能控制(第四版)-刘金琨》课本例题和课后上机实验代码汇总(部分)

详细解析专用于回归的基础机器学习模型--线性回归(包括多项式非线性回归),ARIMA(SARIMA)模型以及灰色预测模型。详细原理、数据假设、参数检验。

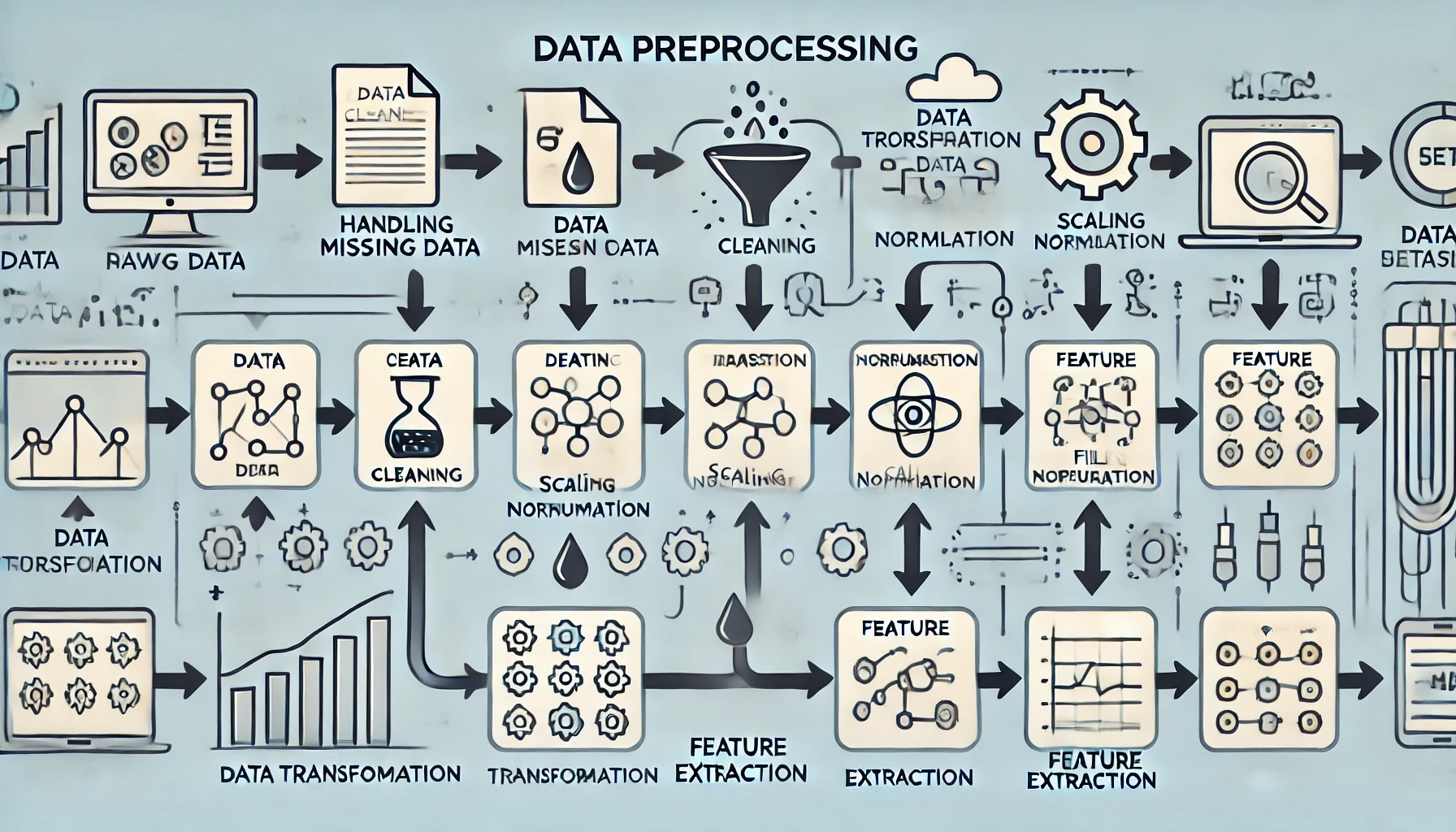

数据处理是机器学习中至关重要的一步,确保模型在干净、高质量的数据上进行训练。在这一篇文章中,我们将聚焦对于各种数据形式的各种处理方式。含2024亚太杯中文赛项相关题目实战。

本文综述了信息论在深度学习中的关键应用,重点探讨了信息瓶颈理论、互信息估计和编码率减少原则三大方向。在信息瓶颈理论方面,研究表明深度网络训练呈现"拟合-压缩"两阶段动态,非线性激活函数能促进信息压缩以提升泛化能力,变分信息瓶颈(DVIB)框架可有效提高模型可解释性。互信息神经估计(MINE)方法通过Donsker-Varadhan表示实现了高维数据中的高效互信息估计。最大编码率

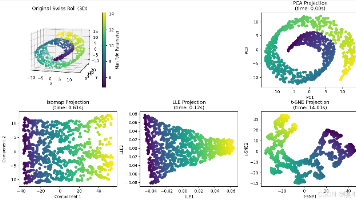

简要介绍了几种常见的降维方法,包括主成分分析(PCA)、线性判别分析(LDA)、t-SNE和独立成分分析(ICA),并且对于每一种方法给出了应用示例。并介绍了几种流形学习(非线性降维方法)--多维缩放(MDS)、等度量映射(Isomap)、局部线性嵌入(LLE)。