简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

数量比例:一般为训练数据集的 1:1 到 1:10,根据任务的复杂性进行调整。风格差异:确保风格差异适中,避免过大差异引发过拟合。超参数调整:调整正则化强度与学习率等超参数,确保正则化不影响模型的主学习目标。影响:正则化数据集的增加通常能提升泛化能力,但过多会影响训练效果,特别是模型可能会偏向于正则化数据集的特征。

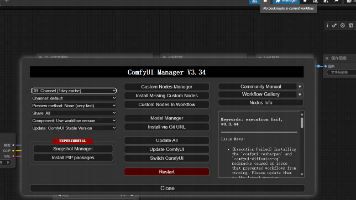

本文介绍了ComfyUI-Manager插件的安装步骤:1)下载并安装GIT;2)进入ComfyUI的custom_nodes目录;3)克隆GitHub仓库或运行便携版脚本;4)安装Python依赖库;5)重启ComfyUI后即可使用管理功能,包括安装节点/模型、更新插件等。该教程由游戏AI研究所社区提供,帮助用户扩展ComfyUI功能。

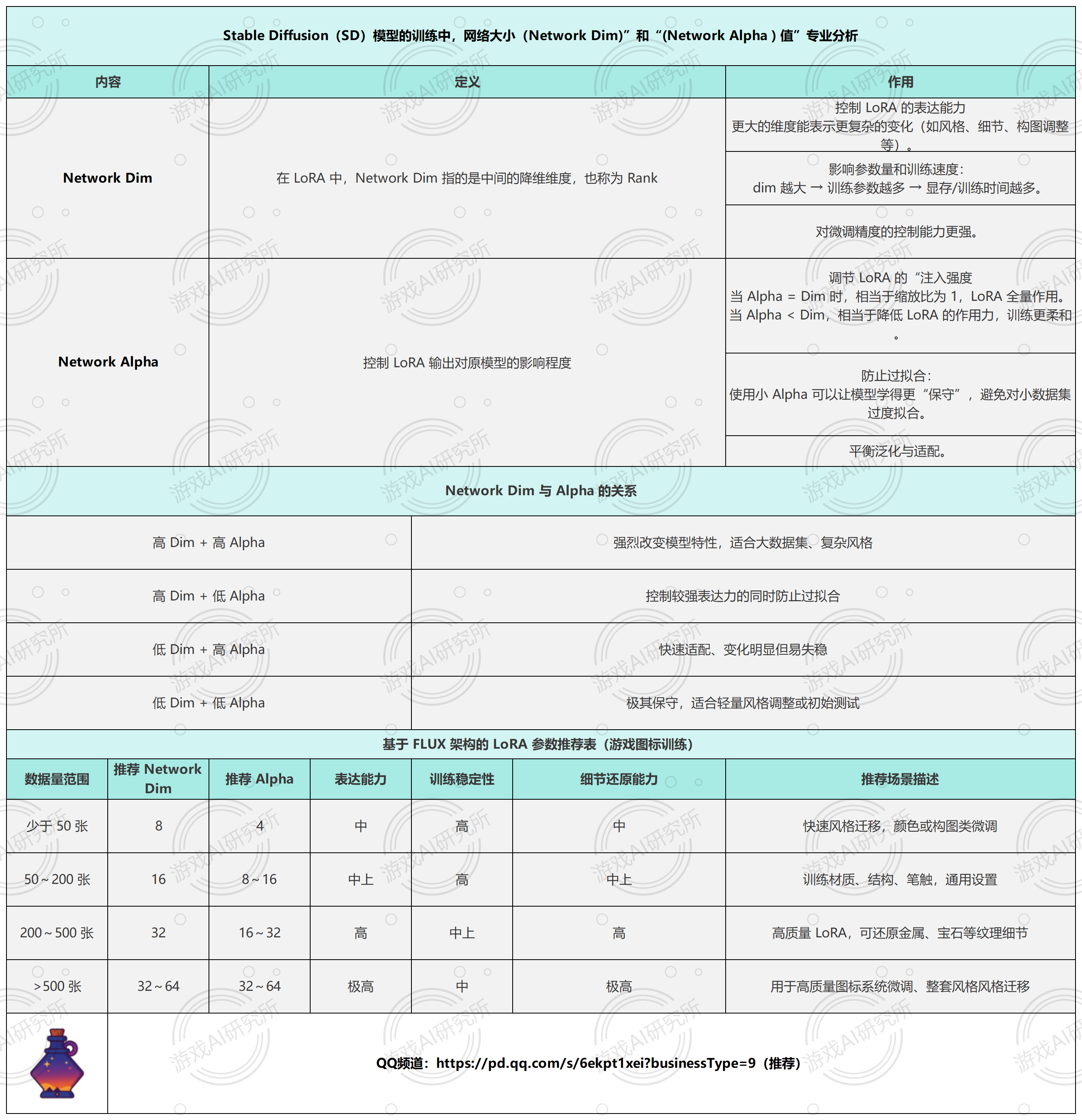

控制 LoRA 的表达能力更大的维度能表示更复杂的变化(如风格、细节、构图调整等)。

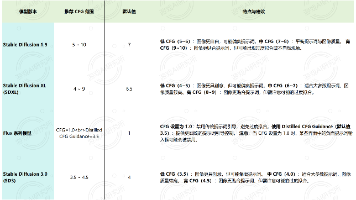

在Stable Diffusion(SD)中,步数(Steps) 指的是采样过程中的迭代次数,也就是模型从纯噪声一步步“清晰化”图像的次数。你可以理解为模型在画这张图时“润色”的轮数。

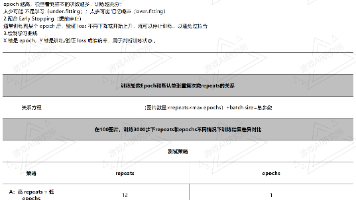

在 LoRA(例如使用 Kohya‑ss)训练中,epochs 和 repeats 分别控制了模型“看”数据的轮数和每张图在一个epoch中出现的频次,两者共同决定训练强度和步骤总数

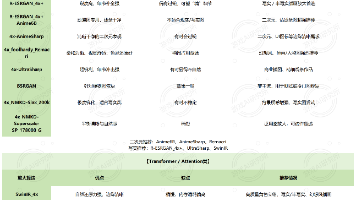

Ⅲ总结:SDXL 高分辨率修复支持多种放大算法,按原理大致分为六类:①Latent 插值类,②传统数学插值,③GAN 神经网络放大,④Transformer/注意力机制放大,⑤图像修复模型,⑥反扩散重建。Latent 系列(如 Latent antialiased / bicubic)运行快,但图像模糊,仅适合草图或预览;传统插值(如 Lanczos)基于图像数学插值,不带美学优化,保真度高但缺乏

ComfyUI 魔壶启动器 让你的 每一条 ComfyUI 管线都能一键生成独立小应用:• 不再需要复杂节点配置; • 一键打包,直接分发或共享; • 支持参数可视化面板,外部用户也能轻松调用。 这意味着,创作者可以把复杂的AI流程变成简单易用的小工具——让AI内容生产真正模块化、组件化。

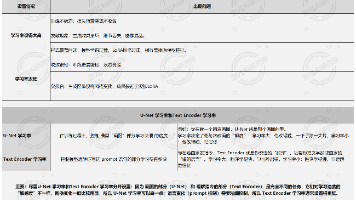

学习率是控制 LoRA 在 SDXL 模型中“学习快慢”的关键超参,需分别为 U‑Net(画图部分)和 Text Encoder(语义理解部分)设定不同的值。根据素材集规模,U‑Net 学习率从 3e‑6(10 张)到 2e‑4(> 3000 张)逐步提高,Text Encoder 则从 5e‑7 上升到 3e‑5。训练总步数也应随数据量增长而增加(约 800–> 10000 步),并配合 3%–

CFG参数控制模型在生成图像时对提示词的服从程度,数值范围通常为1到20,推荐在5到12之间。数值越高,模型越严格遵循提示词,但可能导致图像失真;数值越低,模型自由度更高,图像可能更自然但偏离描述。CFG与提示词长度无直接关系,仅控制模型对提示词的接近程度。在Flux模型中,建议将CFG设为1.0以禁用传统提示词引导,并将Distilled CFG Guidance设为3.5作为新的引导机制。

4.测试结果得出结论:1.相比之前的单模态可使用较少素材集进行训练2.架构独特,可能面临模型崩溃,训练的时候参数设置尤为重要避免过拟合或欠拟3.和之前sdXL等模型的训练有一点不同,打标要尽量详细,越详细越好哦!4.10–30 张高质量图像即可获得良好效果,再也不用为找素材苦恼了!