简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

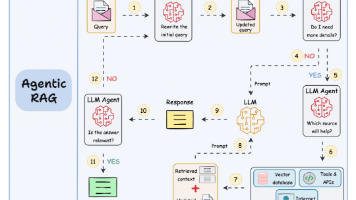

不用啃复杂理论,一句话说清:**RAG = 本地知识库检索 + AI 生成**核心流程:1. 把本地文档(PDF/Word)转成「向量」存到向量库(比如 Redis)2. 用户提问时,先把问题转成向量,去向量库找最相关的内容3. 把找到的内容 + 用户问题一起传给大模型4. 大模型基于“本地知识 + 自身能力”生成答案

大模型相关的岗位开出的薪资都是比较高的,而且现在大模型尚未成熟落地,有很多机会如果你想要从事算法相关的工作,大模型算法及应用无疑是一个比较好的选择

春节期间,好几个朋友问我同一个问题:**「你不是搞 AI 的吗,我也想学学,从哪开始啊?」**做老师的、做销售的、刚毕业的学生、创业十几年的老板,当然也包括后台经常私信我的粉丝朋友们。

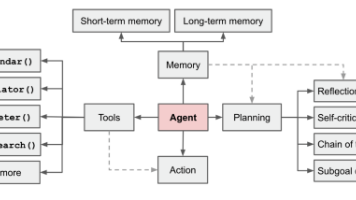

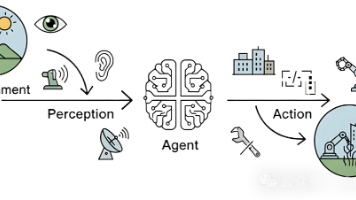

以大模型(LLM) 作为核心控制器的智能体 (Agent) 概念非常引人注目。目前已有一些概念验证演示,如 AutoGPT、GPT-Engineer 和 BabyAGI,它们都是鼓舞人心的范例。LLM 的潜力远不止于生成高质量的文案、故事、文章和程序,它还可以被视为一个强大的解决通用问题手段。

欢迎来到智能体的世界!在人工智能浪潮席卷全球的今天,**智能体(Agent)**已成为驱动技术变革与应用创新的核心概念之一。无论你的志向是成为AI领域的研究者、工程师,还是希望深刻理解技术前沿的观察者,掌握智能体的本质,都将是你知识体系中不可或缺的一环。

本文介绍了自动驾驶中利用强化学习微调来改进智能体行为。自动驾驶汽车研究的一个主要挑战是对智能体行为进行建模,这具有关键的应用,包括为非车载评估构建逼真且可靠的仿真以及为车载规划预测交通智能体运动。尽管监督学习已经在跨不同领域建模智能体方面取得了成功,但是这些模型在测试部署时可能会受到分布偏移的影响。本项工作通过使用强化学习对行为模型进行闭环微调来提高智能体行为的可靠性。本文方法在Waymo Ope

Adaptive RAG(自适应检索增强生成)是一种先进的 RAG 策略,它智能地将动态查询分析与自我纠错机制相结合,以优化响应准确性。

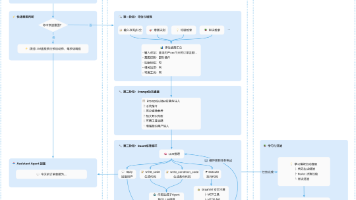

📖 简介Cloud NativeAssistant Agent 是一个基于 Spring AI Alibaba 构建的企业级智能助手框架,采用代码即行动(Code-as-Action)范式,通过生成和执行代码来编排工具、完成任务。它是一个能理解、能行动、能学习的智能助手解决方案,可帮助企业快速构建智能答疑客服、系统诊断、运维助手、业务助理、AIOps 等智能体。仓库地址:spring-ai-al

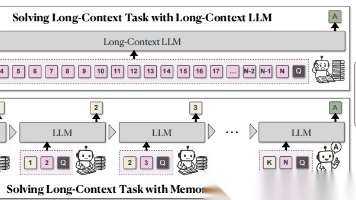

尽管在长度外推、注意力机制优化以及记忆模块方面已有诸多改进, 但在外推过程中保持性能不下降的前提下,以线性复杂度处理无限长文档, 仍然是长文本处理领域的终极挑战。

机器学习、深度学习和大模型,经常傻傻的分不清,这里将结合图文跟大家讲清楚。假设我们**有一个文本情感分析的任务,需要判断一段文本的情感是正面、负面还是中性**。下面分别是机器学习、深度学习和大模型的实现方式。