简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

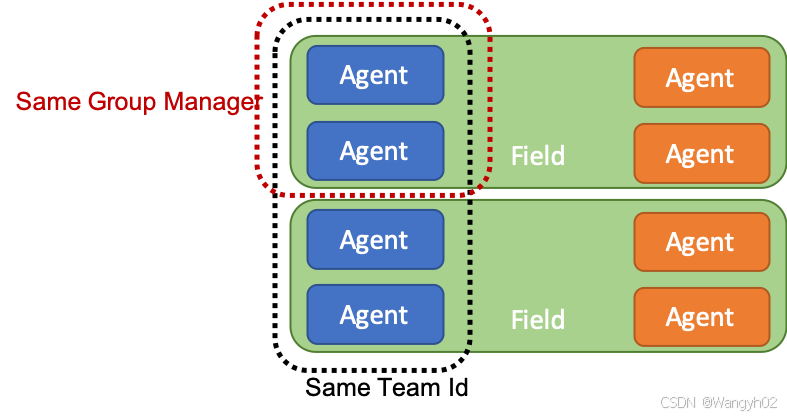

使用在决策之间累积奖励。使用覆盖决策之间累积的任何先前奖励。为了确保更稳定的学习过程,任何给定奖励的幅度通常不应大于 1.0。正向奖励通常比负向奖励更有助于塑造智能体所期望的行为。过多的负向奖励可能会导致智能体无法学习任何有意义的行为。对于移动任务,通常会为向前速度设置一个较小的正奖励(0.1)。如果您希望智能体快速完成任务,那么在智能体未完成任务的每一步(-0.05)内提供小额惩罚通常会很有帮助

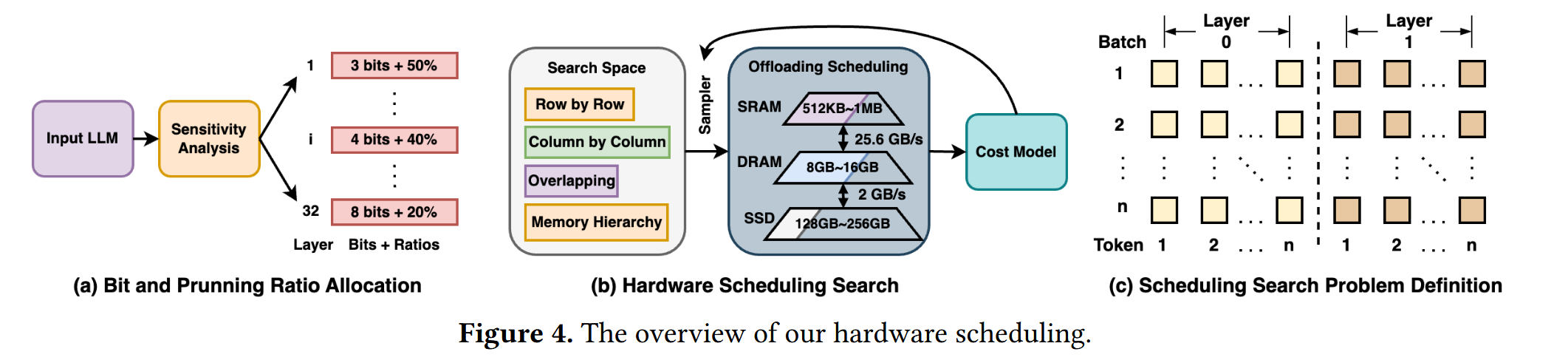

受第2.3节中所发现的机会的启发,我们接下来介绍所提出的Edge-LLM框架的算法设计,以在有限的计算和内存开销下,实现有效且高效的大语言模型适配。如图2所示,我们提出的Edge-LLM微调算法整合了两个关键促成因素,每个因素都利用了上述减少计算和内存开销的机会之一。具体来说:(1)为了降低计算开销,我们提出了分层统一压缩(LUC)技术,以减少目标大语言模型的冗余。这项技术的灵感来源于我们对大语言

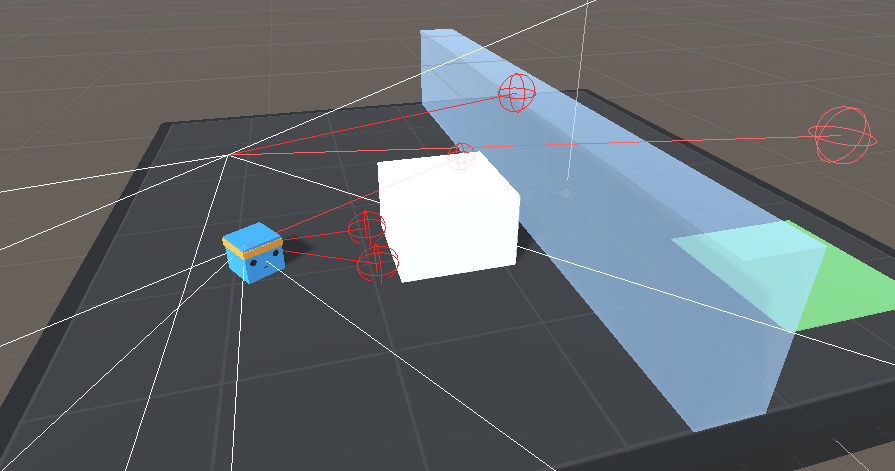

这篇文章详细介绍了Unity ML-Agents Toolkit中智能体(Agent)的观测和传感器机制,重点讲解了如何为智能体设计有效的观测系统以支持其学习和决策。文章涵盖了多种观测方式,包括矢量观测、视觉观测、射线观测、网格观测和变数量观测,分别适用于不同的场景和需求。矢量观测通过`VectorSensor`收集数字信息,视觉观测通过相机或渲染纹理捕捉图像,射线观测通过射线投射检测环境物体,网

大型语言模型 (LLM) 的出现彻底改变了自然语言处理应用程序,由于减少延迟、数据本地化和个性化用户体验等原因,在边缘设备上运行 LLM 变得越来越有吸引力。本综述探讨了在资源受限的设备上部署计算成本高昂的 LLM 所面临的挑战,并探讨了跨多个领域的创新解决方案。本文研究了设备端语言模型的开发、其高效架构(包括参数共享和模块化设计)以及最先进的压缩技术,如量化、修剪和知识蒸馏。分析了硬件加速策略和

EdgeShard 提出了一种通过协作边缘计算实现高效大语言模型(LLM)推理的框架。当前 LLM 主要依赖云计算,导致延迟高、带宽成本大和隐私问题。边缘计算通过在靠近数据源的边缘设备上部署 LLM 来解决这些问题,但资源受限和网络不稳定是主要挑战。EdgeShard 将 LLM 划分为多个分片,并部署在分布式边缘设备和云服务器上,通过自适应设备选择和模型分区优化推理性能。实验表明,EdgeSha

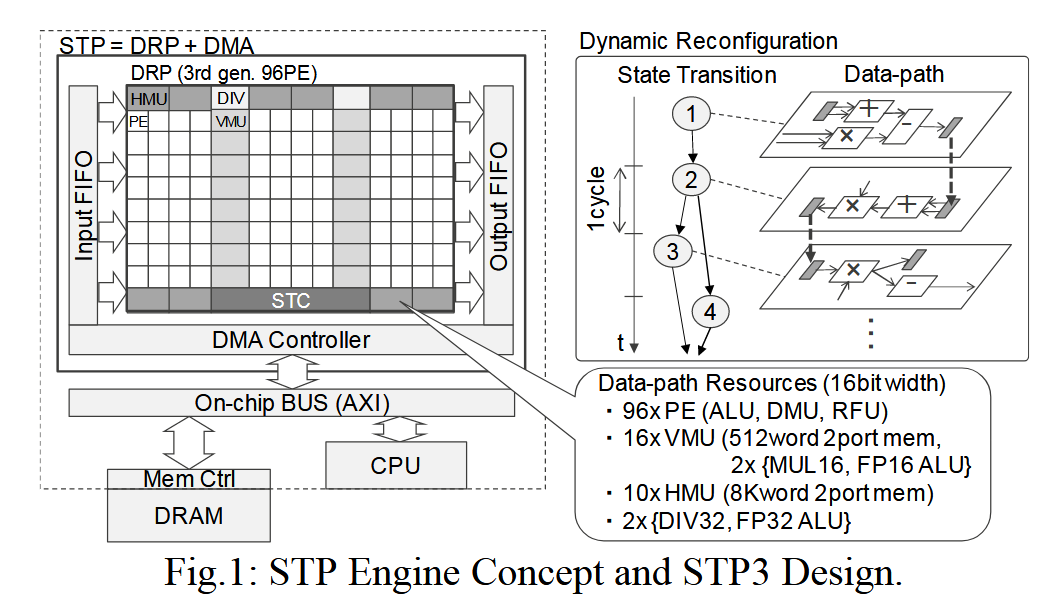

本文介绍了一种新型动态可重构处理器技术——STP3-AI,用于加速嵌入式系统中的深度神经网络(DNN)处理。STP3-AI集成了第三代动态可重构处理器(DRP)、专用的AI乘法累加器(AI-MAC)和直接内存访问(DMA)引擎。该处理器支持16位浮点运算和二值化DNN推理计算,具有高度通用性、高性能和低延迟的特点。AI-MAC单元通过三种模式(FP16、二进制权重和二进制网络)优化了内存占用和吞吐

Genesis是一款由卡内基梅隆大学、马里兰大学、斯坦福大学、麻省理工学院等全球顶尖研究机构联合开发的开源生成式物理引擎。于2024年12月19日正式开源。它专为机器人、嵌入式 AI 和物理 AI 应用设计,能够模拟各种物理现象(如刚体、液体、软体等),并通过自然语言描述生成交互式 3D 场景、机器人策略和面部动画。

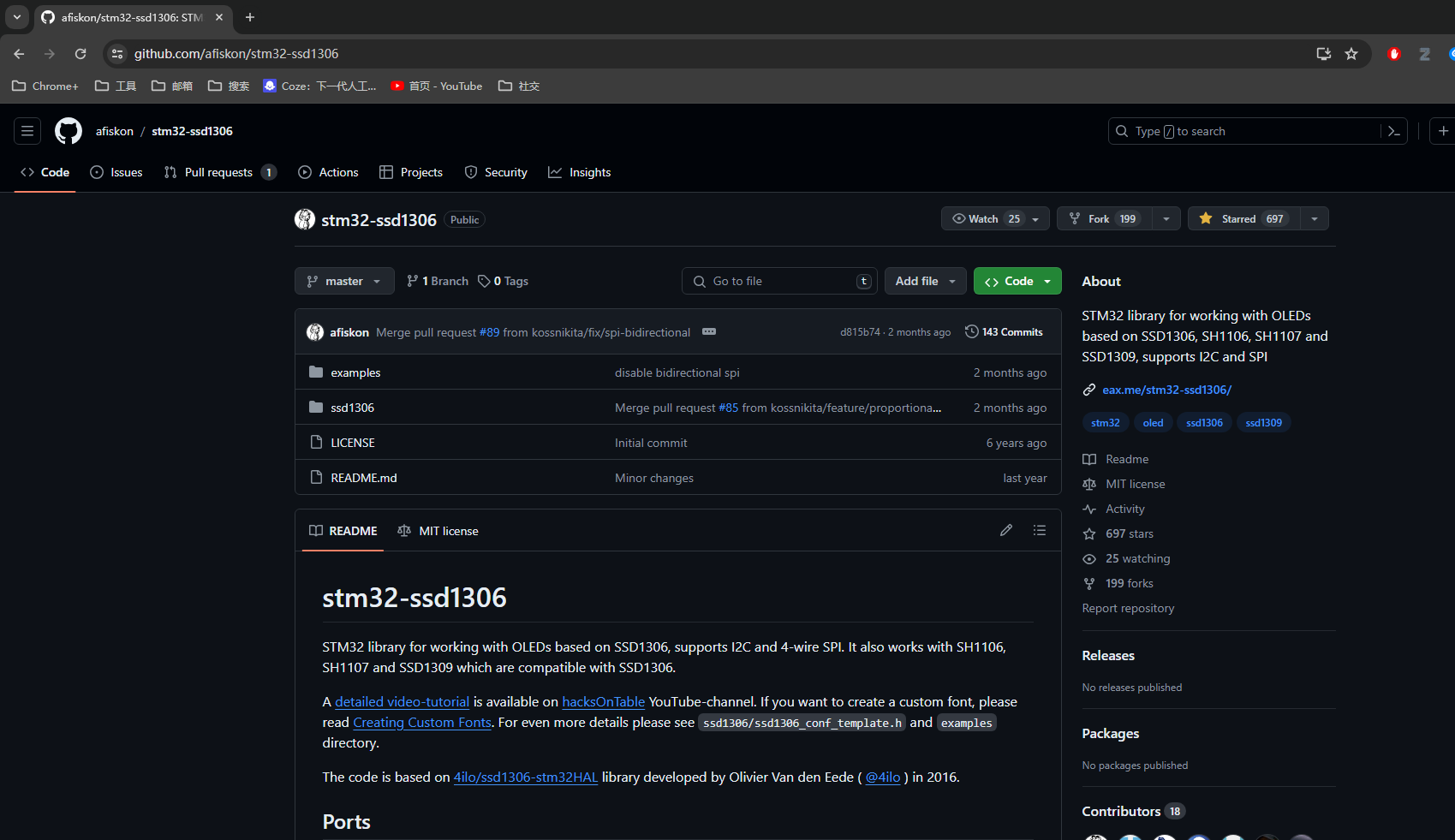

本文将指导您如何在STM32微控制器上使用afiskon的库来移植并操作基于SSD1306、SH1106、SH1107和SSD1309的OLED显示屏。这个库支持I2C和SPI通信协议,使得OLED显示屏的集成和显示操作变得简单高效。

文章《Edge 大型语言模型综述:设计、执行和应用》由Yue Zheng等人撰写,发表于2025年8月31日的《ACM Computing Surveys》期刊。该期刊影响因子为23.8,属于SCI Q1分区和中科院工程技术1区。文章全面探讨了边缘计算环境下大型语言模型的设计、执行及其应用。通过分析现有技术和未来趋势,作者提出了在资源受限的边缘设备上优化和部署大型语言模型的方法,并展示了其在智能设

EdgeShard 提出了一种通过协作边缘计算实现高效大语言模型(LLM)推理的框架。当前 LLM 主要依赖云计算,导致延迟高、带宽成本大和隐私问题。边缘计算通过在靠近数据源的边缘设备上部署 LLM 来解决这些问题,但资源受限和网络不稳定是主要挑战。EdgeShard 将 LLM 划分为多个分片,并部署在分布式边缘设备和云服务器上,通过自适应设备选择和模型分区优化推理性能。实验表明,EdgeSha