简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

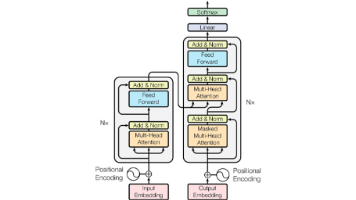

饭要一口一口吃”。同样,在自然语言处理(NLP)中,模型在处理大规模数据时,如果将其分割成小块,会更容易处理。因此,Token(词元)可以是小至一个字符、大至一个单词的文本片段,而将大段文本分割成词元的过程就称为Tokenization(词元化)。,根据模型的设计方式,Token可以是单词级、子词级,甚至是字符级单词级词元化(Word-level tokenization)"]子词级词元化(Sub

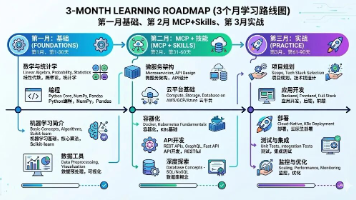

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

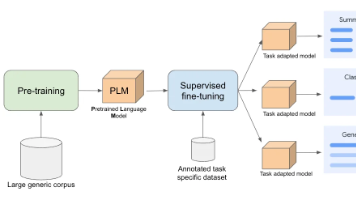

深度解析大语言模型的指令微调(SFT):定义、流程与价值边界

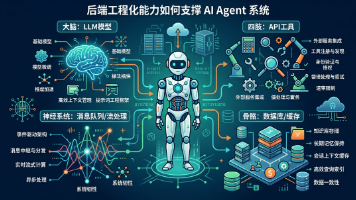

后端开发者曾是互联网大厦的建筑师。现在,大厦的建筑方式变了。AI 不会取代后端开发者,但会取代那些拒绝进化的 CRUD 程序员。未来的后端架构,将是确定性代码与概率性模型的深度耦合。我们不再仅仅是代码的编写者,更是智能系统的总设计师。拥抱这种不确定性,将你的工程化能力与 AI 的推理能力结合。在这个重塑的时代,做那个定义规则的人,而不是被代码淹没的人。对于正在迷茫择业、想转行提升,或是刚入门的程序

2020 年,有人说"短视频是风口"2022 年,有人说"元宇宙是未来"2024 年,有人说"AI 是泡沫"岗位多(12,000+,月增 35%)薪资高(35k 起步,50k 常见)竞争少(真正懂的没几个)观望,等别人先试错(然后看别人拿 50k)学习,成为第一批入行的人(然后拿到 offer)创造,做自己的 Agent 产品(然后自己当老板)我的建议:别等。今天就开始:打开刷 10 道面试题写一

AI时代,没有永远的岗位,只有永远的适应。替代的是重复任务,融合的是核心能力,新增的是无限机遇。2025-2030年,是职场重构的关键6年。看清趋势、提前转型,才能在AI浪潮中站稳脚跟,从"被替代者"变成"驾驭AI的人"。未来已来,你准备好了吗?对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(

2026年春招的火爆,已经明确传递出一个信号:AI风口是真风口,人才缺口是真缺口,但机会永远留给有准备、选对方向的人。对于小白、程序员,或是即将填报志愿的高考生而言,选择什么样的专业,就决定了你将以什么样的姿势站上这个风口。这里给大家做个清晰的适配总结,方便快速对号入座:\1.动手能力强、不惧硬件挑战,喜欢机器人领域——优先选具身智能,瞄准机器人研发、AI实体落地岗位,缺口大、薪资高;