简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

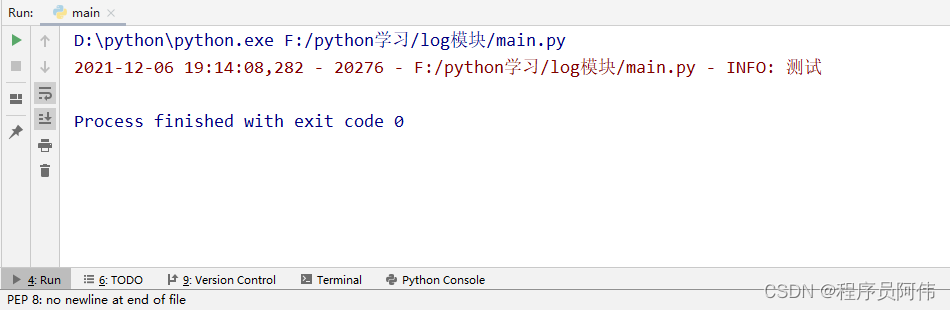

导入第三方库import loggingimport logging.handlers封装工具类1、创建util.py文件'''日志工具类'''class Logging:def __init__(self):# log文件存储路径self._log_filename = 'test.log''''%(levelno)s: 打印日志级别的数值%(levelname)s: 打印日志

今天要用到虚拟机,然后就使用XShell连接,可是现实无法连接,然后我又用其他工具连接,也无法连接,明明之前还能连接的。解决办法首先这个方法是保证你的其他配置没问题,也就是之前能连接禁用,再启用VM8网卡 即可...

问题报错问题忘记记录了,口头描述一下吧,事情是这样的,今天启动hadoop集群的时候,突然namenode无法启动了,之前都是可以正常启动的,我回忆了一下,应该是我最后一次不正常的操作导致的后果,hadoop集群启动的时候,直接关闭了虚拟机,因此上网查找解决办法,但是大多数都是要格式化才能解决,这样的话,数据就全部丢失了。如何解决既然问题已经找到了,最后一次的启动造成的,那么我们可以回退hadoo

windows本地运行mr程序时(不提交到yarn,运行在jvm靠线程执行),hadoop.dll防止报nativeio异常、winutils.exe没有的话报空指针异常。

今天在使用pytorch加载数据时出现如下错误:raise RuntimeError('DataLoader worker (pid(s) {}) exited unexpectedly'.format(pids_str))RuntimeError: DataLoader worker (pid(s) 4252, 17184) exited unexpectedly仔细分析了一下,原因定位在num

代码public class YamlUtil {public static void main(String[] args) {URL url = YamlUtil.class.getClassLoader().getResource("");System.out.println(url);}}输出结果分析通过上面的结果,可以看到getClassLoader().getResource()定位到

为什么创建虚拟环境?一般来说,使用全局环境的话,会出现包版本冲突的情况,这样的话,每当我们需要完成项目时,就需要去不更改包的版本,如果为每个项目创建一个虚拟环境,这样的话,我们的项目的包库都是独立的,不存在冲突的现象。创建流程1.首先确保你的项目中没有该文件夹venv,这个文件夹就是用来存放环境的,新建的项目是没有该文件夹的。2.点击setting3.找到Interpreter4.完成后继续点击添

启动redis服务端redis-server 配置文件路径启动客户端redis-cli密码登录auth 密码封装工具类import redisclass RedisHelper:def __init__(self, host, password, port):# 连接redisself.__redis = redis.StrictRedis(host=host, password=password