简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文记录了在华为昇腾Atlas 800I A2推理卡上部署Qwen2.5-7B-Instruct模型的完整过程,包括环境搭建、模型部署、性能调优等关键步骤,希望能为有类似需求的朋友提供参考。经过完整的部署和测试过程,Qwen2.5-7B模型在昇腾Atlas 800I A2平台上运行稳定,性能表现良好。从监控结果可以看到4张NPU卡都正常工作,温度控制在45°C左右,功耗稳定,为后续部署提供了良好的

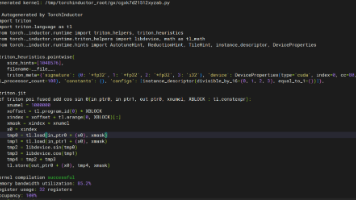

通过 TorchDynamo 的字节码重写、AOT Autograd 的图优化和 TorchInductor 的代码生成,实现了在保持 PyTorch 灵活性的同时获得接近静态图的性能。随着深度学习模型复杂度的不断提升,模型推理和训练的性能优化成为了业界关注的焦点。PyTorch 2.0 引入的 torch.compile 功能,通过即时编译(JIT)技术实现了显著的性能提升。随着技术的不断成熟,

在 Rust 中,所有权(Ownership)是一套管理内存资源的规则。每个值都有一个。

Rust 异步运行时中的工作窃取调度算法,是其高性能并发模型的核心驱动力。它通过将调度逻辑分散到各个核心的本地队列,结合不对称的访问模式(本地 LIFO,远程 FIFO),巧妙地将性能优化与内存安全相结合。这种机制不仅消除了传统集中式调度器的竞争瓶颈,更利用缓存局部性最大限度地榨取了现代多核处理器的性能。理解工作窃取,就是理解 Rust 如何在零成本抽象的框架下,实现高性能并发的专业秘密。

零成本抽象(Zero-Cost Abstraction)这一概念由 Bjarne Stroustrup(C++ 创建者)推广,但在 Rust 中得到了更彻底的实践。不为未使用付费 (You don’t pay for what you don’t use):如果代码没有使用某个特性,编译后的产物中就不会包含与之相关的代码或数据结构。等价性能 (Performance Equivalence)

Tokio 的 IO 循环是 Rust 异步运行时复杂而精巧的核心组件。它通过对操作系统事件多路复用 API 的高效利用,结合 Rust 零成本的。

这篇文章对传输层协议TCP的内容进行充分讲述,关于其三次握手、四次挥手、以及它的各种其他知识都有涉及,非常详细

以在一个升序数组中查找一个数为例,每次考察数组当前部分的中间元素,如果中间元素刚好是要找的,就结束搜索过程;如果中间元素小于所查找的值,那么左侧的只会更小,不会有所查找的元素,只需到右侧查找;该题相比于上题,该题有多个峰值存在,故在两个封顶之间的区间内,从左到右一定递增,故套用模板二,找区间左端点即可。3、该区间对题目具有单调性,即:在区间中的值越大或越小,题目中的某个量对应增加或减少。注:封顶的

是 C++17 引入的一种类型安全的联合体(Union),它允许可变类型的数据存储在一个统一的类型中。传统联合体(union)的问题:C风格或 C++的普通 union 不是类型安全的。我们需要自己记住当前存储的是哪种类型,如果访问错了(比如在一个存储 int 的 union 上读取 float),会导致未定义行为,而且它无法处理非平凡类型(如 std::string)std::variant 的

ops-nn 算子库是 CANN 架构中神经网络加速的核心实现。它通过对专用矩阵计算单元和向量计算单元的深度映射、引入如 NC1HWC0 等硬件友好型数据格式优化访存效率,以及采用深度融合策略来打破“内存墙”,为深度学习模型提供了坚实的底层高性能计算支持。深入理解 ops-nn 的运行机制和优化策略,对于开发者在模型部署和调优过程中至关重要。这不仅能帮助他们充分发挥 AI 硬件的计算潜力,实现更高