简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

统计学习方法第四章 朴素贝叶斯法公式推导最大后验估计 贝叶斯估计

泛化误差上界 极大似然估计贝叶斯估计推导正太分布均值的极大似然估计和贝叶斯估计

字典 a 可以随时修改变量,比如把name改成'Bill',但是一旦程序结束,变量所占用的内存就被操作系统全部回收。如果没有把修改后的'Bill'存储到磁盘上,下次重新运行程序,变量又被初始化为'Bob'。==我们把变量从内存中变成可存储或传输的过程称之为序列化,==在Python中叫pickling。序列化之后,就可以把序列化后的内容写入磁盘,或者通过网络传输到别的机器上。反过来,把变量内容从序

它和 ReLU 函数的不同之处在于,当 x 小于零时,LeakyReLU 函数的导数值并不为 0,而 是常数𝑝,p 一般设置为某较小的数值,如 0.01 或 0.02。,我们可以看到输出,当x小于0 的时候,leakyRelu_x的结果被乘以0.1。,我们可以看到输出,当x小于0 的时候,leakyRelu_x的结果被乘以0.1。LeakyReLU 函数有效的克服了 ReLU 函数的缺陷,使用也

它可以用于将预测概率作为输出的模型(如风控中的评分卡、逻辑回归等),例如表示二分类的类别概率或置信度。函数是连续可导的(即可微),能够提供非常平滑的梯度值,防止模型训练过程中出现突变的梯度(即避免“跳跃”的输出值)。在神经网络的梯度计算中,通过缓存每层的 Sigmoid 函数输出值,即可在需 要的时候计算出其导数.(这里注意sigmoid和softmax的区别,经过sigmoid的所有输出加起来不

【代码】神经网络常见激活函数 2-tanh函数(双曲正切)

注册流程切换中文邀请码:XcgtUixn。

注册流程切换中文邀请码:XcgtUixn。

本章节包含在上一章中,学习了多头注意力机制并对其进行了编码,它是LLMs的核心组件之一。在本章中,将编写 LLM 的其他构建块,并将它们组装成类似 GPT 的模型。

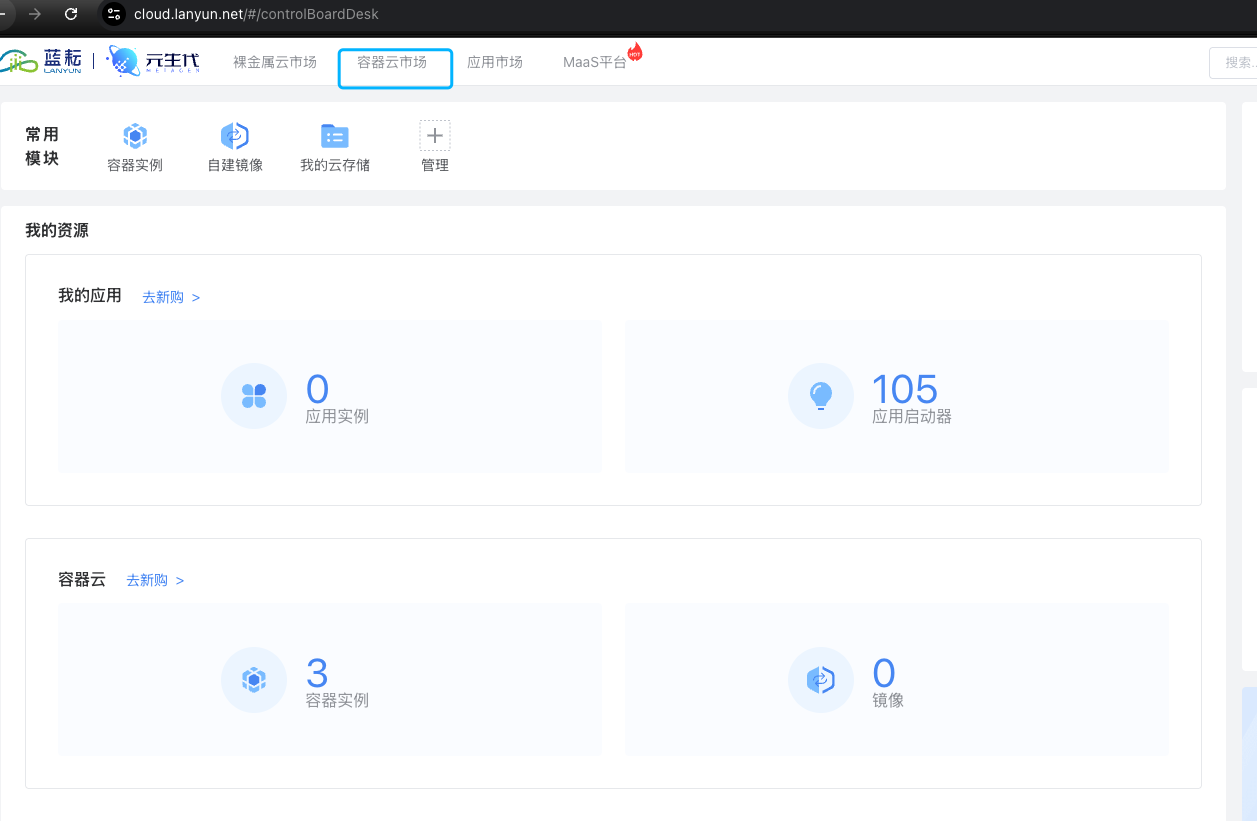

蓝耘算力云平台和AutoDL的使用非常类似,可以说几乎是一模一样下面这个是我的注册码,第一次注册填写后会送20的券创建GPU实例注册完成后进入容器云市场创建自行选择是否扩容数据盘(免费50G),选择镜像后点击立即购买立即购买后,会出现以下提示,点击确定点击确定后等待开机,当开机状态为运行中,则可以连接了,这里我之前已经有实例了,就不新开了。