简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1、简介:1.1 什么是EasyDL专业版EasyDL专业版是EasyDL在2019年10月下旬全新推出的针对AI初学者或者AI专业工程师的企业用户及开发者推出的AI模型训练与服务平台,目前支持视觉及自然语言处理两大技术方向,内置百度海量数据训练的预训练模型,可灵活脚本调参,只需少量数据可达到优模型效果。适用人群专业AI工程师且追求灵活、深度调参的企业或个人开发者支持定制模型...

令人惊讶的是,我们发现一个简单的设计可以满足所有三个约束条件:一个强大的图像编码器计算图像嵌入,一个提示编码器嵌入提示,然后两个信息源在一个轻量级的掩码解码器中进行组合以预测分割掩码。在自然语言处理领域,以及近年来的计算机视觉领域,基础模型是一种有前途的发展,通常可以通过“提示”技术实现对新数据集和任务的零样本和小样本学习。其次,我们发现在使用提示工程的零-shot转移协议下,在各种下游任务中,包

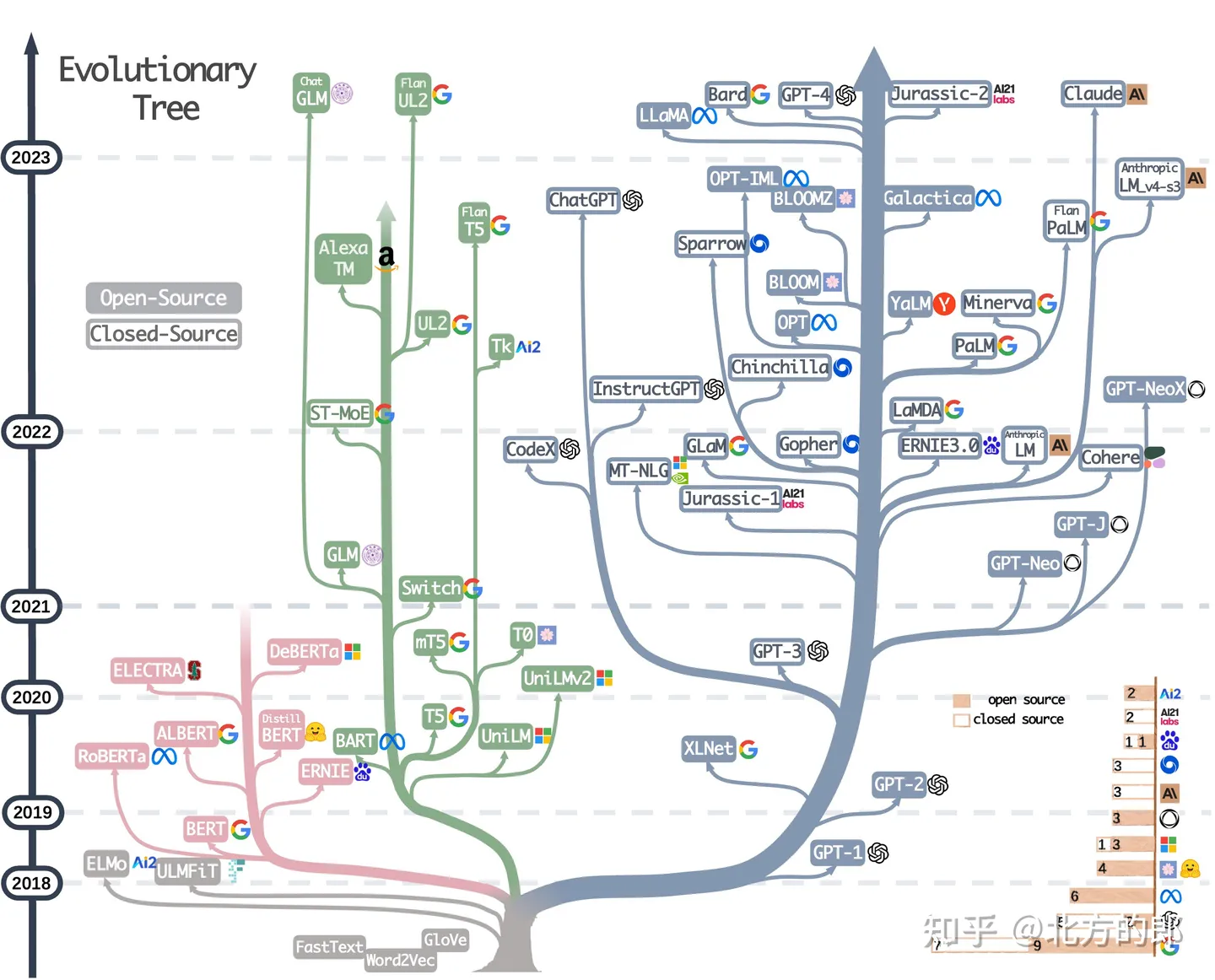

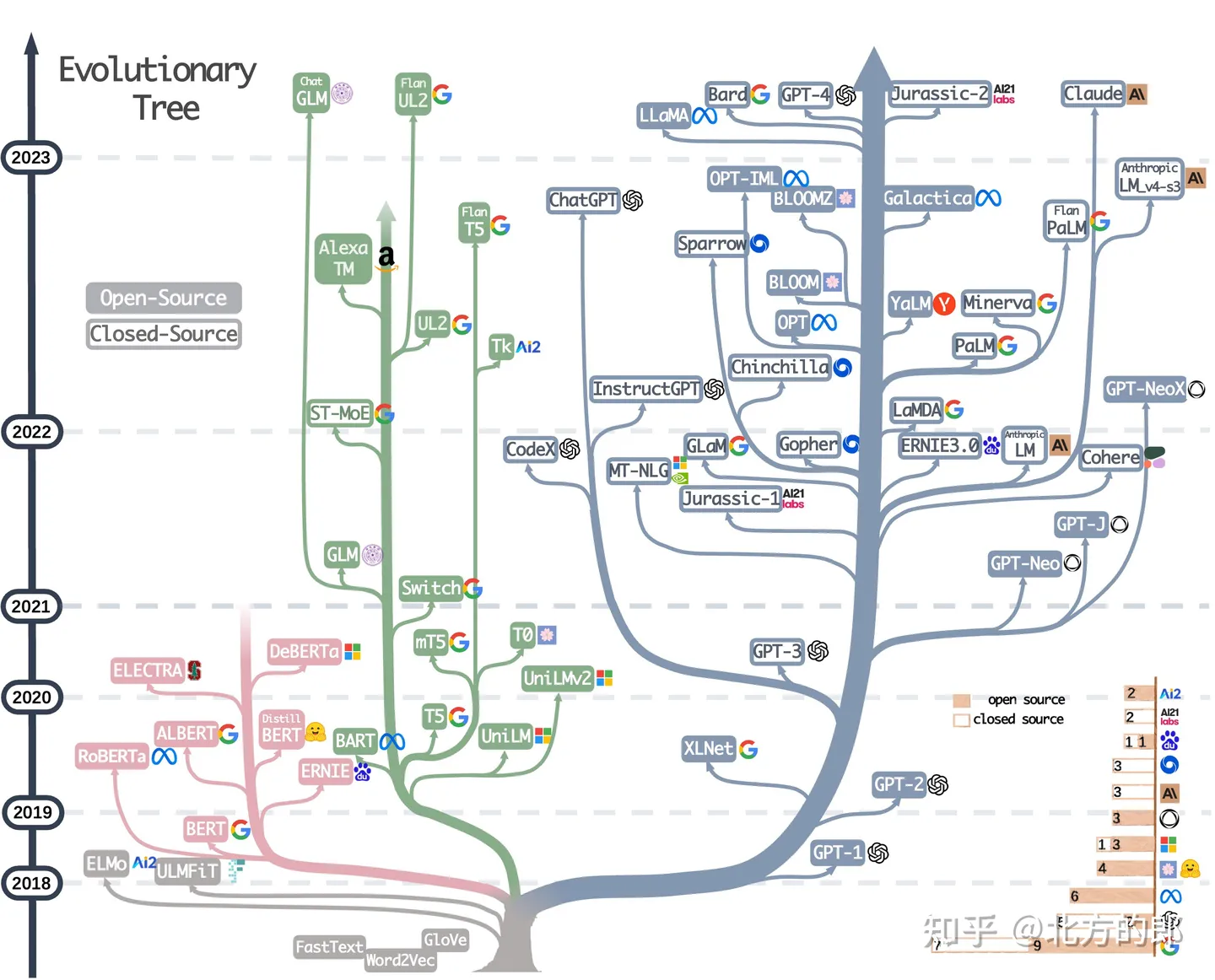

近期大语言模型迅速发展,让大家看得眼花缭乱,感觉现在LLM的快速发展堪比寒武纪大爆炸,各个模型之间的关系也让人看的云里雾里。最近一些学者整理出了 ChatGPT 等语言模型的发展历程的进化树图,让大家可以对LLM之间的关系一目了然。论文:https://arxiv.org/abs/2304.13712Github(相关资源):https://github.com/Mooler0410/LLMsPr

近期大语言模型迅速发展,让大家看得眼花缭乱,感觉现在LLM的快速发展堪比寒武纪大爆炸,各个模型之间的关系也让人看的云里雾里。最近一些学者整理出了 ChatGPT 等语言模型的发展历程的进化树图,让大家可以对LLM之间的关系一目了然。论文:https://arxiv.org/abs/2304.13712Github(相关资源):https://github.com/Mooler0410/LLMsPr

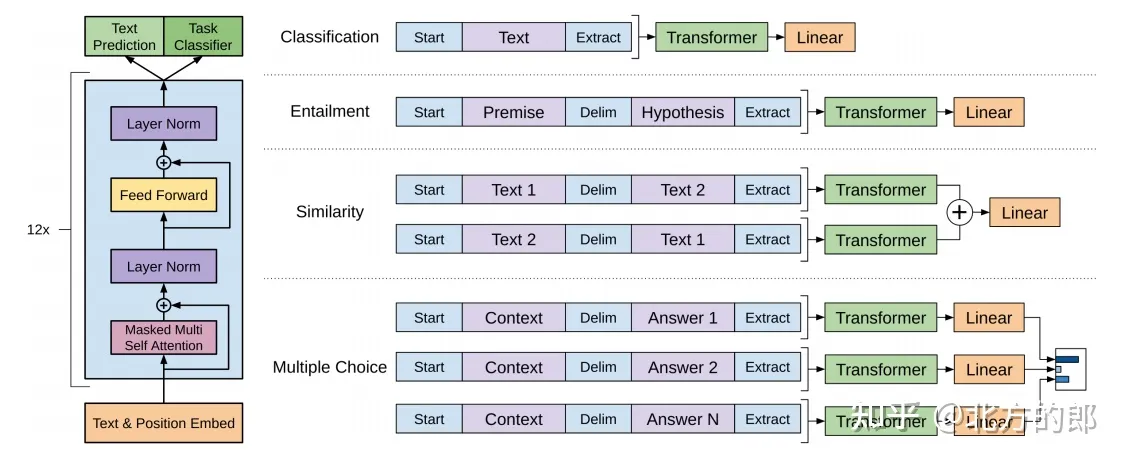

GPT和BERT的输入顺序不同:GPT是从左到右的单向模型,它只能在当前位置之前看到的上下文信息,而BERT是一种双向模型,它可以同时看到前面和后面的文本信息。GPT和BERT的训练数据不同:GPT使用了更广泛的训练数据,包括维基百科和网页文本,而BERT则使用了更多的语言任务,如问答和阅读理解。GPT和BERT的任务不同:GPT是一种基于语言模型的生成式模型,可以生成类似人类写作的文本,而BER

Stability AI与它的多模式AI研究实验室DeepFloyd共同宣布研究版本DeepFloyd IF的发布,这是一款强大的文text-to-image级联像素扩散模型(cascaded pixel diffusion model),复现了Google的Imagen(北方的郎:深入浅出讲解Stable Diffusion原理,新手也能看明白),Imagen也依赖于一个冻结的文本编码器:先将文

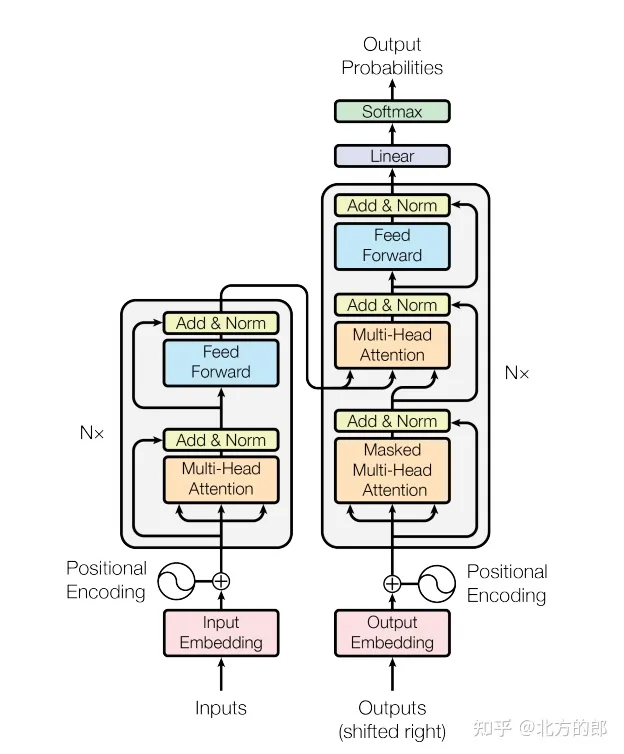

Transformer模型通过引入自注意力机制和多头注意力机制来替代传统的循环神经网络和卷积神经网络,从而提高了模型的表现。同时,Transformer模型还采用了分头处理和残差连接等技术,进一步提高了模型的效率和表现。该模型在机器翻译等任务中取得了极高的性能,成为自然语言处理领域的经典模型之一。

机器学习的过程中很多时候需要用到类似透视表的功能。Pandas提供了pivot和pivot_table实现透视表功能。相对比而言,pivot_table更加强大,在实现透视表的时候可以进行聚类等操作。pivot_table帮助地址:https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.pivot_table.htm...

1.功能描述:基于深度学习及大规模图像训练,准确识别图片中的物体、场景信息。可以应用于:相关内容及广告推荐:对用户浏览网页中图片进行分析,识别图片内容给出相关内容推荐或广告展示。相册分类及智能美图:批量读图实现相册智能分类管理。通用物体与场景识别进行了能力升级——模型升级,Top1准确率绝对值提升7%,业界领先!具体如下图所示:2.平台接入通用物体与场景识别接入网址:http...

【使用攻略】【人体关键点识别】1.方案介绍百度推出了人体关键点识别,检测图像中的人体并返回人体矩形框位置,精准定位21个核心关键点,包含头顶、五官、颈部、四肢主要关节部位,支持多人检测、大动作等复杂场景。支持多人体检测,检测图像中的所有人体,标记出每个人体的坐标位置;不限人体数量,适应人体轻度遮挡、截断的情况。人体关键点识别的功能特点可以应用到体育健身,根据人体关键点信息,分析人体姿态、...