简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

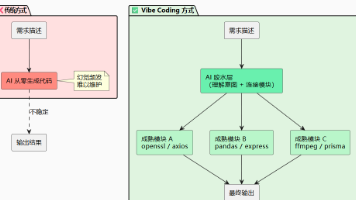

摘要: Vibe Coding是由Andrej Karpathy提出的新型开发范式,以自然语言驱动AI完成编码,开发者专注创造与架构。其核心原则包括:胶水编程(复用模块而非生成代码)、规划驱动(先文档后执行)、上下文优先(明确任务边界)、模块化设计(接口先行)以及单一事实来源(白板为真相源)。此外,强调数据与函数分离、可证伪测试、人机协作(人调度AI)、迭代收敛(快速验证优化)和系统思维(实体-链

摘要: Skills 是 AI 任务的标准工作流程(SOP),通过模块化封装提升 Prompt 的复用性和稳定性。相比传统 Prompt,Skills 支持渐进式加载、团队协作和持续优化,解决了重复描述、上下文浪费和结果不稳定等问题。其核心结构包括 SKILL.md(定义流程)和资源目录(按需加载),通过精准的 description 触发。Skills 与 Rules(行为约束)、MCP(能力接

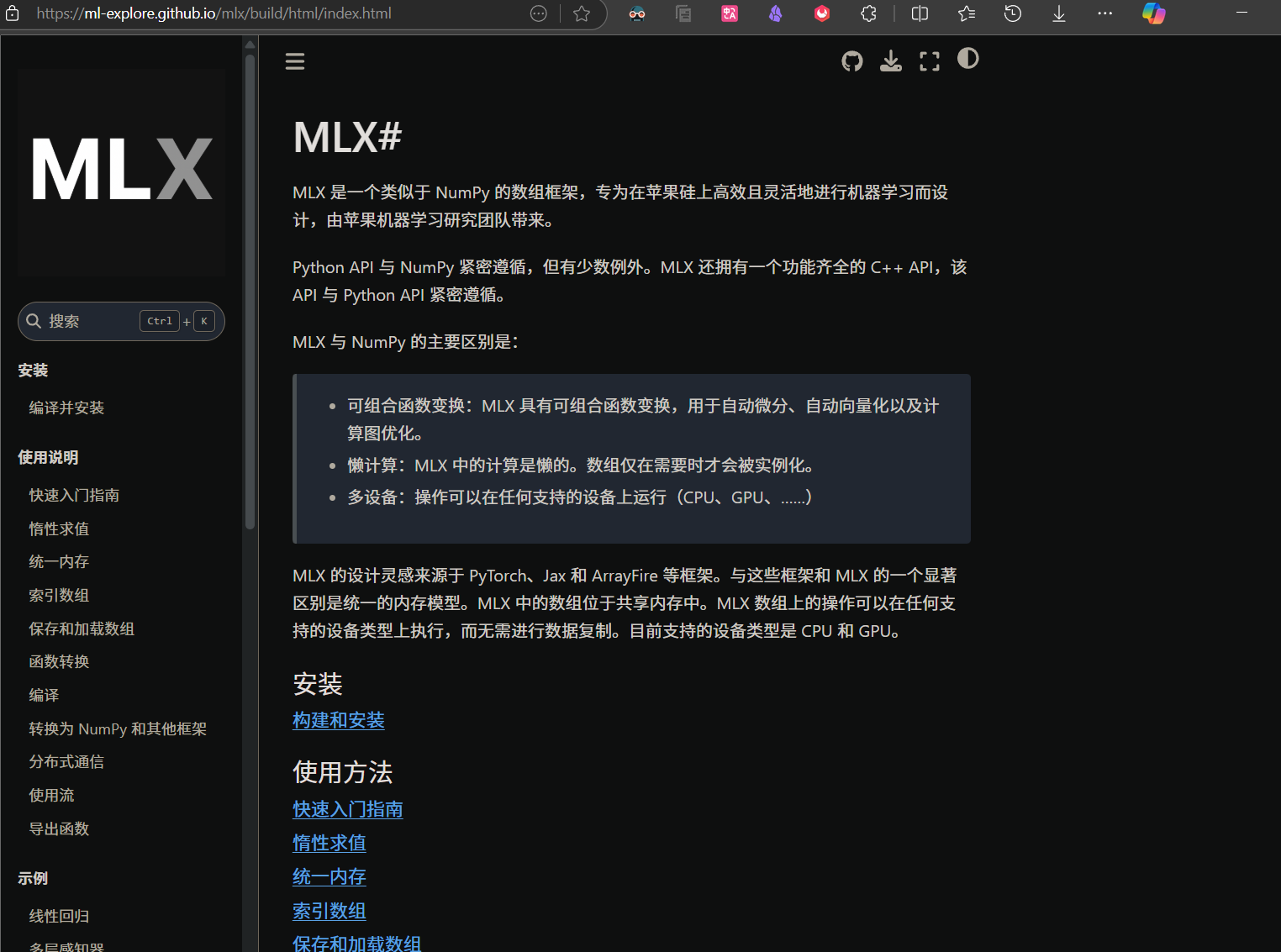

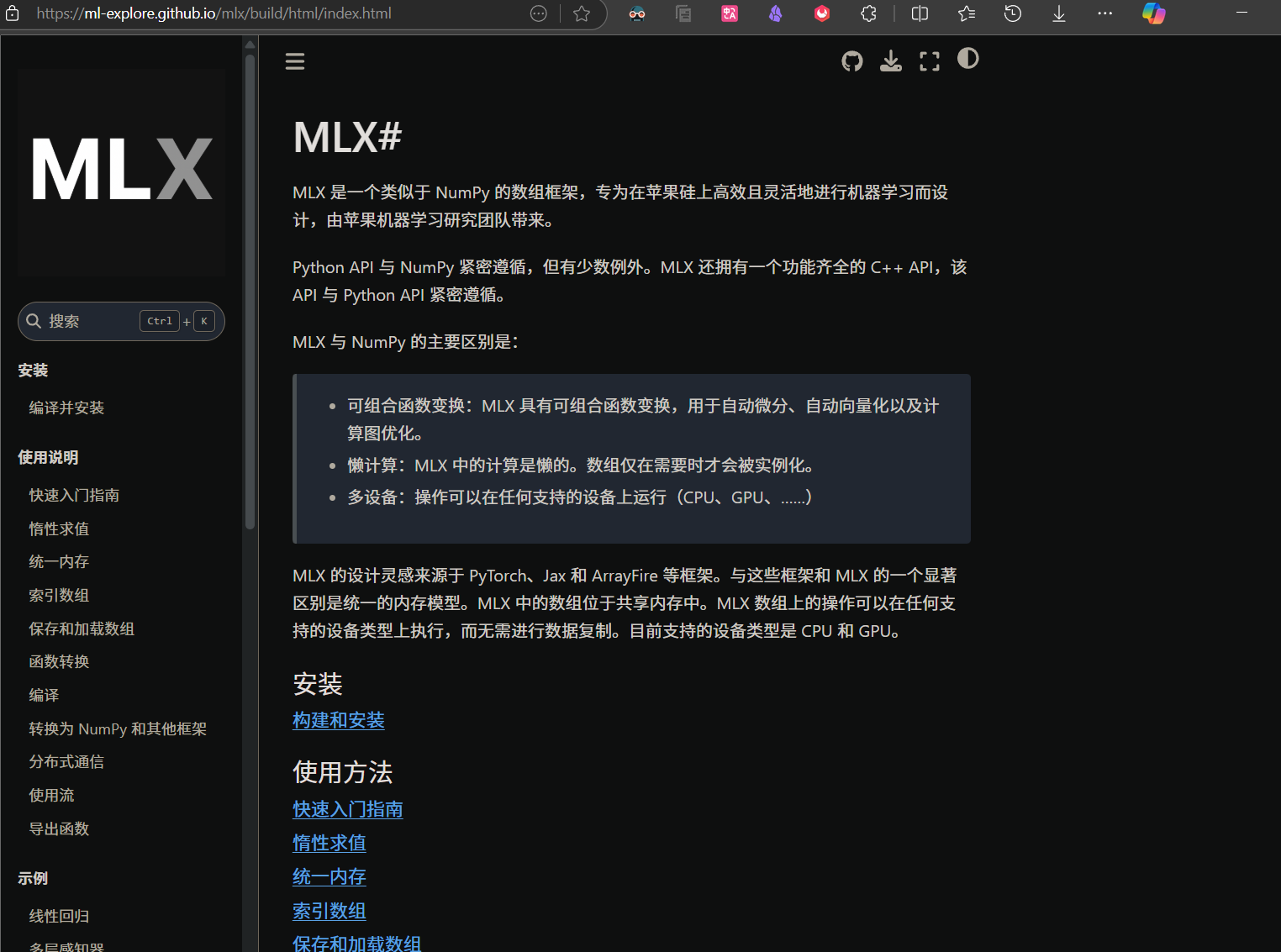

在本地设备上微调大语言模型(LLM)已成为开发者探索AI应用的新趋势。使用苹果MLX框架微调Qwen2.5-0.5B模型通过Ollama服务接入自定义项目实现端到端的本地化AI解决方案通过本教程,您已掌握:✅ Mac本地LLM微调技术✅ MLX框架的实战应用✅ Ollama服务集成方法使用自定义数据集进行领域适配探索不同量化策略的精度/性能平衡结合LangChain构建完整AI应用延伸阅读MLX官

由于我用macmini m4在本地用ollama部署了几个大模型,并通过内网穿透到了公网,由oneapi分发,但是没有ollama没做鉴权,导致任何人都可以通过我的ip访问访问我本地大模型。还好我今天收到了天翼云的提醒才意识到这个问题,现在已经修复这个问题了,希望看到朋友赶快去检查一下。

由于我用macmini m4在本地用ollama部署了几个大模型,并通过内网穿透到了公网,由oneapi分发,但是没有ollama没做鉴权,导致任何人都可以通过我的ip访问访问我本地大模型。还好我今天收到了天翼云的提醒才意识到这个问题,现在已经修复这个问题了,希望看到朋友赶快去检查一下。

在本地设备上微调大语言模型(LLM)已成为开发者探索AI应用的新趋势。使用苹果MLX框架微调Qwen2.5-0.5B模型通过Ollama服务接入自定义项目实现端到端的本地化AI解决方案通过本教程,您已掌握:✅ Mac本地LLM微调技术✅ MLX框架的实战应用✅ Ollama服务集成方法使用自定义数据集进行领域适配探索不同量化策略的精度/性能平衡结合LangChain构建完整AI应用延伸阅读MLX官

由于我用macmini m4在本地用ollama部署了几个大模型,并通过内网穿透到了公网,由oneapi分发,但是没有ollama没做鉴权,导致任何人都可以通过我的ip访问访问我本地大模型。还好我今天收到了天翼云的提醒才意识到这个问题,现在已经修复这个问题了,希望看到朋友赶快去检查一下。

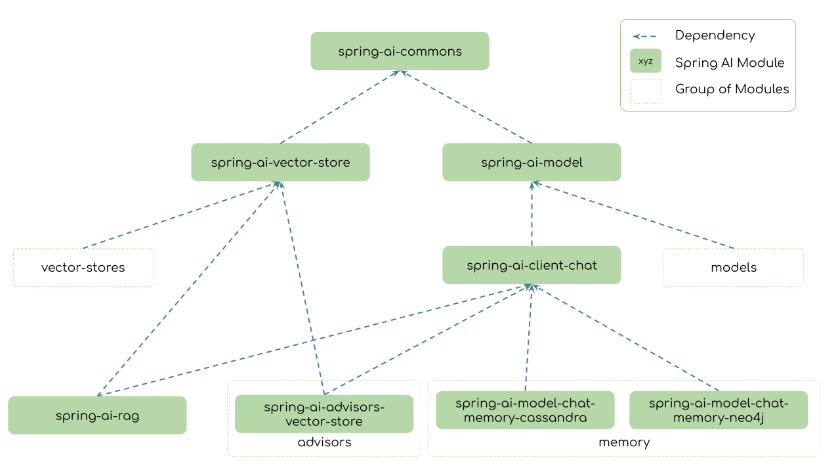

Spring AI 1.0.0-M7 不仅是一次版本迭代,更是 Java 生态拥抱 AI 革命的关键一步。无论您是构建聊天机器人、数据分析工具还是智能服务,Spring AI 都将助您以更少代码实现更多可能。M7 的发布标志着 Spring AI 已进入最终打磨阶段。根据路线图,团队计划于近期推出候选版本(RC1),并加速推进正式版(GA)的发布。作为通往 1.0 正式版(RC1 及 GA)的最后

在本地设备上微调大语言模型(LLM)已成为开发者探索AI应用的新趋势。使用苹果MLX框架微调Qwen2.5-0.5B模型通过Ollama服务接入自定义项目实现端到端的本地化AI解决方案通过本教程,您已掌握:✅ Mac本地LLM微调技术✅ MLX框架的实战应用✅ Ollama服务集成方法使用自定义数据集进行领域适配探索不同量化策略的精度/性能平衡结合LangChain构建完整AI应用延伸阅读MLX官

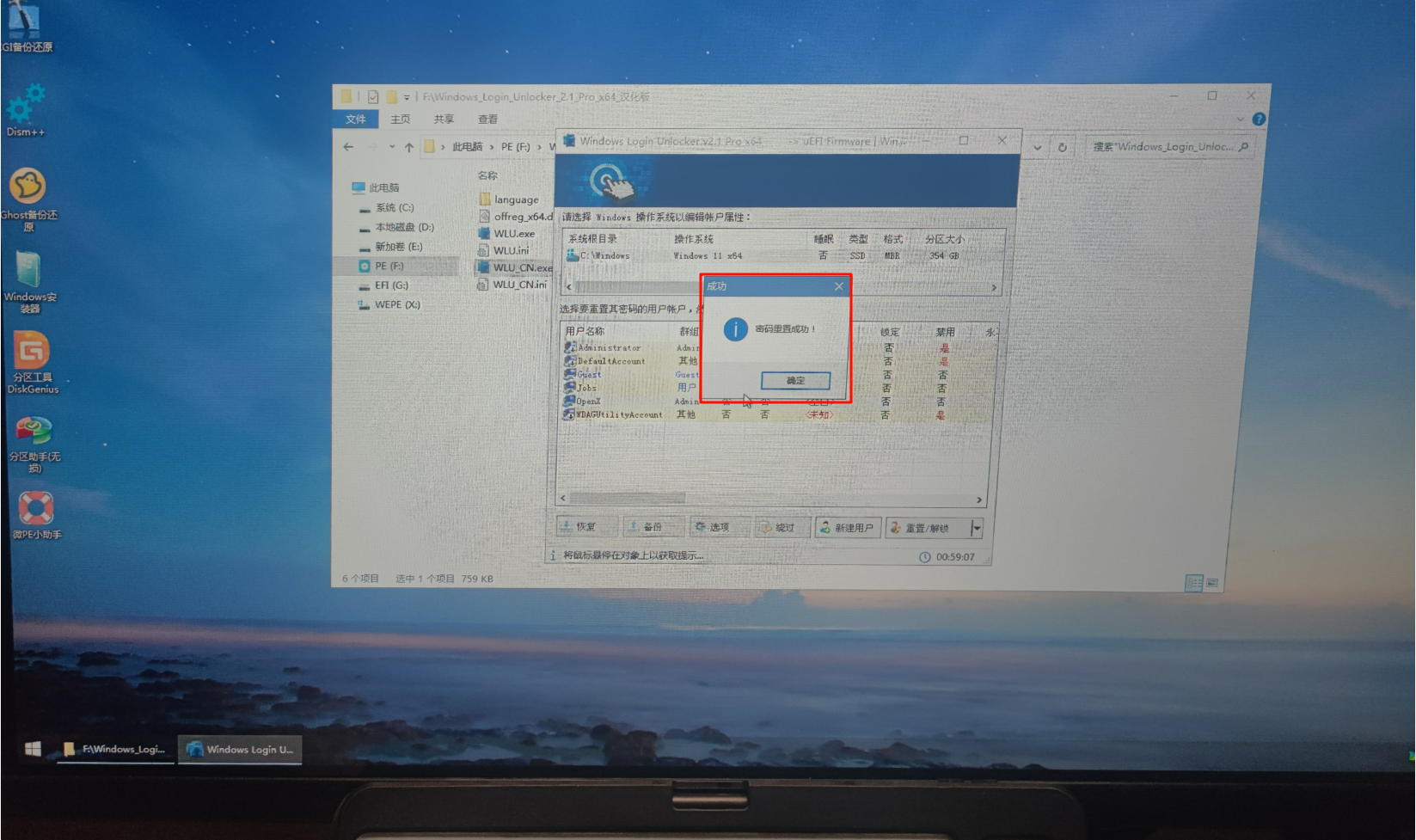

密码忘记是一件非常痛苦的事,下面介绍一种不用重装系统,不需要懂技术,跟着一步一步来,100%成功的方案。看到本教程,将让你少走很多很多的弯路,请耐心看完。