简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

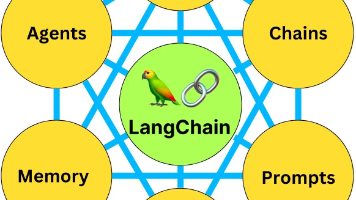

本文是LangChain入门教程,旨在帮助初学者了解大型语言模型(LLM)开发框架LangChain。内容涵盖了LangChain的基本概念、安装配置、核心组件(模型、提示、内存、索引)以及实际应用场景。通过学习本教程,读者将掌握LangChain的基础知识,为在AI领域进一步探索和创新打下坚实基础。建议收藏本文,以便随时查阅。

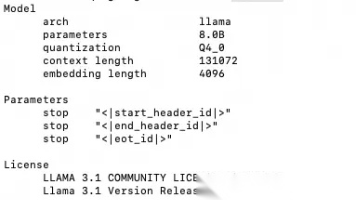

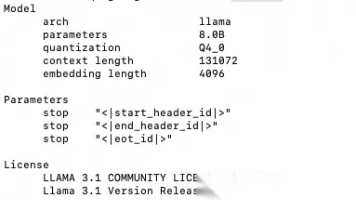

本文针对想学习大模型但受限于电脑配置的同学,介绍了如何使用MacBook Pro本地搭建大模型。主要内容包括模型量化的概念和作用,推荐使用Ollama大模型管理工具一键部署量化后的LLM模型(以Llama3.1为例),并详细阐述了通过Docker和Open WebUI实现本地Web UI管理调试大模型的步骤。教程旨在降低AI学习门槛,帮助读者迈出AI技术学习第一步。

本文将带领开发者入门Android AI大模型,涵盖大模型基础概念、类型、训练与推理过程,并推荐适合Android的轻量级模型。教程详细讲解在Android项目中集成大模型的环境搭建、模型转换、加载初始化及推理过程,并介绍图像分类、文本分类和目标检测等实际应用案例。此外,还分析了开发中可能遇到的问题及解决方案,帮助开发者更好地应对挑战。

本文将带你5分钟内完成从环境配置到模型运行的全过程,体验LLM的强大功能。文章介绍了Hugging Face平台及其优势,包括安装Python环境、安装Hugging Face库、使用Pipeline快速调用预训练模型、加载和使用不同类型的模型、进行文本生成和分析、优化模型运行性能等。通过学习本文,你将掌握使用Hugging Face快速上手LLM的基本方法,为后续深入学习打下基础。

本文针对想学习大模型但受限于电脑配置的同学,介绍了如何使用MacBook Pro本地搭建大模型。主要内容包括模型量化的概念和作用,推荐使用Ollama大模型管理工具一键部署量化后的LLM模型(以Llama3.1为例),并详细阐述了通过Docker和Open WebUI实现本地Web UI管理调试大模型的步骤。教程旨在降低AI学习门槛,帮助读者迈出AI技术学习第一步。

本文介绍了开源框架LangChain,旨在帮助开发者轻松构建基于语言模型的应用。LangChain支持多种预训练模型,并提供数据处理、微调、推理等服务。通过一个简单的问答系统案例,详细展示了如何使用LangChain进行开发。此外,还介绍了LangChain的多模态模型、模型评估、解释及持续学习等进阶功能,为开发者提供全面的指导。

小白程序员快速入门LangChain大模型框架,轻松构建AI应用

本文将带领开发者入门Android AI大模型,涵盖大模型基础概念、类型、训练与推理过程,并推荐适合Android的轻量级模型。教程详细讲解在Android项目中集成大模型的环境搭建、模型转换、加载初始化及推理过程,并介绍图像分类、文本分类和目标检测等实际应用案例。此外,还分析了开发中可能遇到的问题及解决方案,帮助开发者更好地应对挑战。

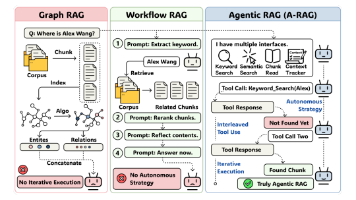

大模型在传统RAG系统中检索自主权受限,导致任务效率和结果质量受限。中国科大量身打造的A-RAG框架通过分层检索接口,赋予模型检索主动权,实现按需选择检索粒度和策略。A-RAG包含构建分层索引、设计分层检索工具、智能体循环三个关键步骤,大幅提升复杂问答任务的准确率和效率。实验证明,A-RAG在多跳问答数据集上表现优异,且随着模型能力提升,性能同步增强。该框架适用于多跳问答、复杂信息检索等场景,为程

Skills是一种将Prompt模块化、结构化的方法,解决了传统MCP和普通Prompt调用在复杂任务中的局限性。它通过元认知层(我是谁、为什么做)、显式化决策逻辑和问题解决螺旋机制,赋予AI完整的认知模型,使其能更好地应对复杂场景。本文详细阐述了Skills的核心要素和转化方法,适合想要提升AI应用能力的程序员和小白学习。