简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

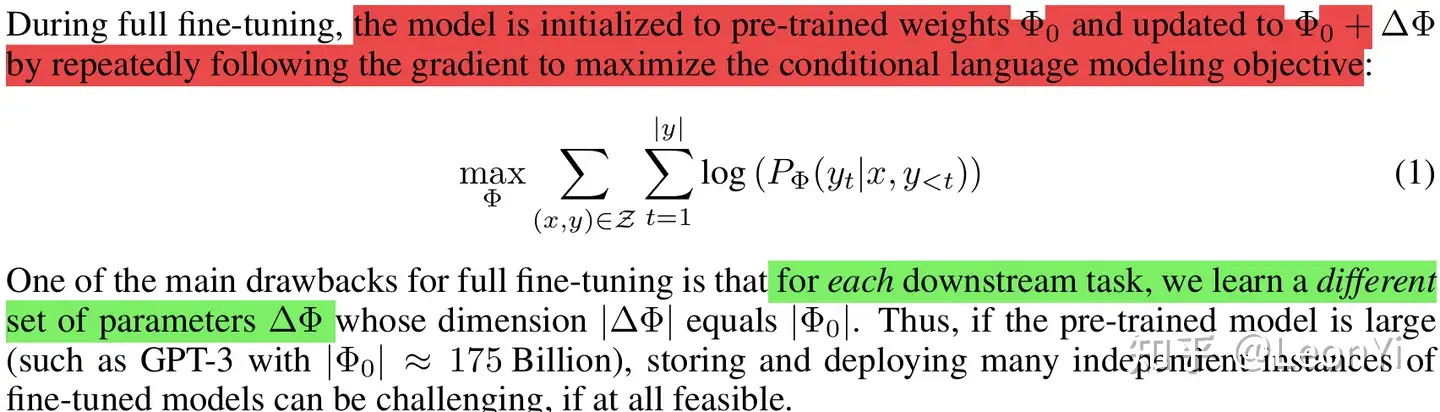

博客首发于我的知乎,详见:https://zhuanlan.zhihu.com/p/702629428一、LoRA原理LoRA(Low-Rank Adaptation of LLMs),即LLMs的低秩适应,是参数高效微调最常用的方法。LoRA的本质就是用更少的训练参数来近似LLM全参数微调所得的增量参数,从而达到使用更少显存占用的高效微调。1.1 问题定义LoRA与训练目标是解耦的,...

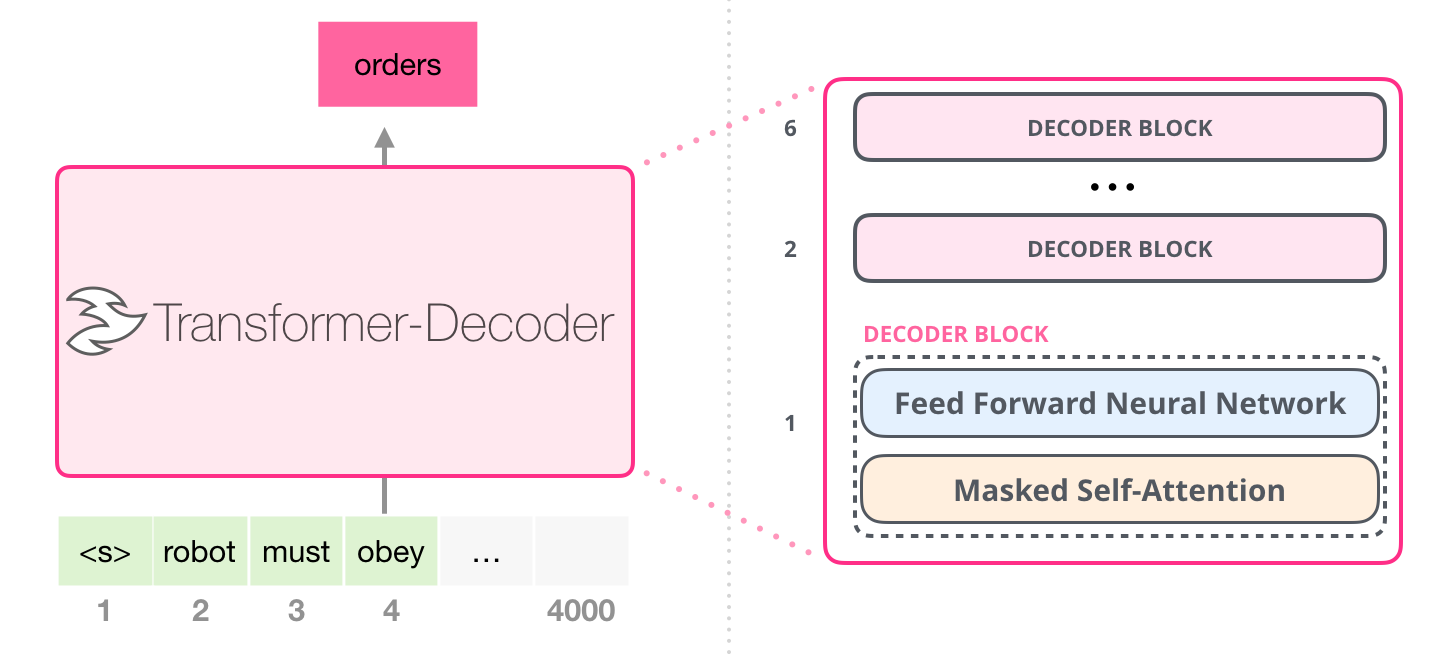

写在前面本文主要是对博客 https://jaykmody.com/blog/gpt-from-scratch/ 的精简整理,并加入了自己的理解。中文翻译:https://jiqihumanr.github.io/2023/04/13/gpt-from-scratch/#circle=on项目地址:https://github.com/jaymody/picoGPT本文将用60行代码...

简述根据如下两本书:1)大规模语言模型:从理论到实践 -- 张奇、桂韬、郑锐、黄萱菁2)ChatGPT原理与实战按更合理的顺序总结了学习路径,实际可按需学习,后续每个目录将给出相应学习资料和资源(参见Github仓库链接)。学习目录第1章 技术发展与需求分析1.1 市场需求分析1.1.1、初识大型语言模型LLM1.1.2、需求和就业市场分析(职位与技术需求分析)...

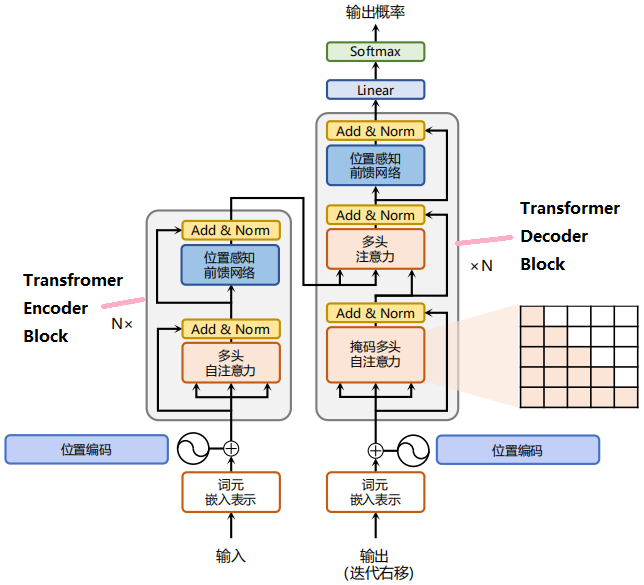

一、Transformer概述Transformer是由谷歌在17年提出并应用于神经机器翻译的seq2seq模型,其结构完全通过自注意力机制完成对源语言序列和目标语言序列的全局依赖建模。Transformer由编码器和解码器构成。图2.1展示了该结构,其左侧和右侧分别对应着编码器(Encoder)和解码器(Decoder)结构,它们均由若干个基本的 Transformer Encoder/D...

一、安装和使用官网下载安装Cursor,然后创建一个代码文件。Ctrl + K生成, Ctrl + L提问。默认每小时30词。# 1. Try generating with command K on a new line. Ask for a pytorch script of a feedforward neural network# 2. Then, select the ...

自己讲论文做的异构图神经网络的ppt。再转变成博客有点麻烦,所以做成图片笔记。论文链接:https://arxiv.org/abs/1903.07293

本文是深度学习入门: 基于Python的实现、神经网络与深度学习(NNDL)以及动手学深度学习的读书笔记。本文将介绍基于Numpy的卷积神经网络(Convolutional Networks,CNN)的实现,本文主要重在理解原理和底层实现。一、概述1.1卷积神经网络(CNN)卷积神经网络(CNN)是一种具有局部连接、权重共享和平移不变特性的深层前馈神经网络...

简述根据如下两本书:1)大规模语言模型:从理论到实践 -- 张奇、桂韬、郑锐、黄萱菁2)ChatGPT原理与实战按更合理的顺序总结了学习路径,实际可按需学习,后续每个目录将给出相应学习资料和资源(参见Github仓库链接)。学习目录第1章 技术发展与需求分析1.1 市场需求分析1.1.1、初识大型语言模型LLM1.1.2、需求和就业市场分析(职位与技术需求分析)...

GPT,GPT-2,GPT-3 论文精读【论文精读】_哔哩哔哩_bilibiliELMo:将上下文当作特征,但是无监督的语料和我们真实的语料还是有区别的,不一定符合我们特定的任务,是一种双向的特征提取。OpenAI GPT: 通过transformer decoder学习出来一个语言模型,不是固定的,通过任务 fine-tuning,用transfomer代替ELMo的LSTM。OpenA...

一、背景编码是信息处理的基础(重新表示信息)。普通的编码是等长编码,例如7位的ASCIL编码,对出现频率不同的字符都使用相同的编码长度。但其在传输和存储等情况下编码效率不高。可使用不等长编码,来压缩编码:高频字符编码长度更短,低频字符编码长度更长。[例] 将百分制的考试成绩转换成五分制的成绩按顺序分别编码。按频率分别编码(高频短编码,类似于香农熵衡量随机变量的编码长度下界)。...